Алгоритм LOWESS

Материал из MachineLearning.

(→Локальные веса) |

(→Локальные веса) |

||

| Строка 49: | Строка 49: | ||

Для четкого определения агоритма поясним концепцию локальных весов <tex>w(x_t)</tex> и робастных весов <tex>\delta(x_t)</tex>. | Для четкого определения агоритма поясним концепцию локальных весов <tex>w(x_t)</tex> и робастных весов <tex>\delta(x_t)</tex>. | ||

== Локальные веса == | == Локальные веса == | ||

| - | :Рассмотрим один из широко распространенных примеров | + | :Рассмотрим один из широко распространенных примеров – функцию |

::<tex>W(z)=(1-|z|^3)^3, \, \, |z|<=1 \\ W(z)=0, \,\, |z|>1 </tex> | ::<tex>W(z)=(1-|z|^3)^3, \, \, |z|<=1 \\ W(z)=0, \,\, |z|>1 </tex> | ||

:Для заданного параметра <tex>0 < f < 1</tex> пусть <tex>r</tex> - ближайшее целое число к произведению <tex> f*m</tex>. Пусть <tex> h_t</tex> расстояние до <tex>r</tex>-того ближайшего соседа объекта <tex>x_t</tex>. Тогда локальный вес для любого объекта ::<tex>x</tex> в окрестности <tex>x_t</tex> есть | :Для заданного параметра <tex>0 < f < 1</tex> пусть <tex>r</tex> - ближайшее целое число к произведению <tex> f*m</tex>. Пусть <tex> h_t</tex> расстояние до <tex>r</tex>-того ближайшего соседа объекта <tex>x_t</tex>. Тогда локальный вес для любого объекта ::<tex>x</tex> в окрестности <tex>x_t</tex> есть | ||

Версия 09:45, 5 января 2010

| | Статья плохо доработана. |

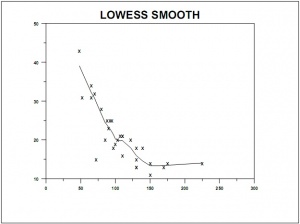

Алгоритм LOWESS (locally weighted scatter plot smoothing) - локально взвешенное сглаживание.

Содержание |

Введение

- Данная методика была предложена Кливлендом(Cleveland) в 1979 году для моделирования и сглаживания двумерных данных

. Эта техника предоставляет общий и гибкий подход для приближения двумерных данных.

- Локально-линейная модель loess(lowess) можеть быть записана в виде:

-

- Эта модель может быть расширена на случай локально-квадратичной зависимости и на модель с бо‘льшим числом независимых переменных.

- Параметры

и

локально линейной модели оцениваются, с помощью локально взвешенной регрессии, которая присваивает объекту тем больший вес, чем более близок он близким к объекту

.

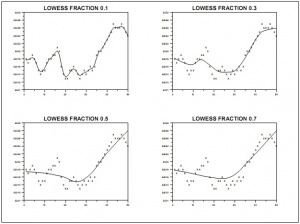

- Степень сглаживания определяется параметром сглаживания

, который выбирает пользователь.

- Параметр

указывает какая доля(fraction) данных используется в процедуре. Если

, то только половина данных используется для оценки и влияет на результат, и тогда мы получим умеренное сглаживание. С другой стороны, если

, то используются восемьдесят процентов данных, и сглаживание намного сильнее. Во всех случаях веса данных тем больше чем они ближе к объекту

.

- Процедура оценки использует не метод наименьших квадратов, а более устойчивый(робастный) метод, который принимает меры против выбросов.

- График приближенных значений

-

- от

полезен для принятия решения о характере связи между

и

. Для проверки качества приближения полученного с помощью процедуры устойчивого loess полезно посмотреть на график остатков обычной регресссии, то есть в осях (i) остатки от числа наблюдения (ii) остатки от прибли‘женных значений, (iii) остатки от значений независимой переменной. Как показал Кливленд, может быть предпочтительно использовать график в осях модули остатков от полученных приближенных значений вместо графика (ii) для устойчивого loess сглаживания, чтобы проверить наличие тренда или других систематических особенностей.

- Когда

вычисления могут быть слишком долгими, в этом случае можно сократить количество вычислений оценивая

и

только в точках отстоящих друг от друга как минимум на

единиц, где параметр

может задаваться либо приниматься по умолчанию. Рекомендуемые значения

-

Если

-

Если

, где

— [межквартильный размах](Interquartile range).

-

- С такими параметрами вычисления будут выполнены для примерно 100 точек.

Примеры

- На Рис. 2. Приведена иллюстрация уровня сглаживания в зависимости от значения параметра

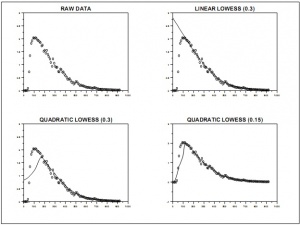

- Сглаживание также может быть локально квадратичным, в этом случае выражения для

имеет вид

-

Примеры сглаживания с квадратичным локальным приближением показаны на Рис. 3.

Технические детали алгоритма

Базовое предположение состоит в следующем

где - функция глаживания, остатки

имеют нулевое математическое ожидание и фиксированную дисперсию. Затем сглаживание

мы приближаем локально-линейной(локально квадратичной, в случае нелинейной модели) функцией, чтобы получить

-

.

-

Для четкого определения агоритма поясним концепцию локальных весов и робастных весов

.

Локальные веса

- Рассмотрим один из широко распространенных примеров – функцию

- Для заданного параметра

пусть

- ближайшее целое число к произведению

. Пусть

расстояние до

-того ближайшего соседа объекта

. Тогда локальный вес для любого объекта ::

в окрестности

есть

.

Замечание

Алгоритм LOWESS

Вход

- обучающая выборка;

весовые функции;

Выход

Коэффициенты

Алгоритм

- 1: инициализация

- 2: повторять

- 3: вычислить оценки скользящего контроля на каждом объекте:

- 4: вычислить новые значения коэффициентов

:

;

- 5: пока коэффициенты

не стабилизируются

Коэффициенты , как и ошибки

, зависят от функции

, которая,

в свою очередь, зависит от

. На каждой итерации строится функция

,

затем уточняются весовые множители

. Как правило, этот процесс сходится довольно быстро.

Он называется локально взвешенным сглаживанием (locally weighted scatter plot smoothing, LOWESS).

Выбор ядра

- В качестве ядра

большинство практических источников рекомендуют использовать следующее:

Пусть - есть медиана коэффициентов

,

тогда

, где

Более простой вариант, состоит в отбросе коэффициентов, соответствующих объектам с максимальными

. Это соотвествует ядру

где –-

- тый член вариационного ряда

Примеры применения

Литература

- Воронцов К.В. Лекции по алгоритмам восстановления регрессии. — 2007.

- A.I. McLeod Statistics 259b Robust Loess: S lowess. — 2004.

- John A Berger, Sampsa Hautaniemi, Anna-Kaarina Järvinen, Henrik Edgren, Sanjit K Mitra and Jaakko Astola Optimized LOWESS normalization parameter selection for DNA microarray data. — BMC Bioinformatics, 2004.

См. также

- Непараметрическая регрессия

- Регрессионный анализ

- Local regression

- Расин, Джеффри (2008) «Непараметрическая эконометрика: вводный курс», Квантиль, №4, стр. 7–56.

| | Данная статья является непроверенным учебным заданием.

До указанного срока статья не должна редактироваться другими участниками проекта MachineLearning.ru. По его окончании любой участник вправе исправить данную статью по своему усмотрению и удалить данное предупреждение, выводимое с помощью шаблона {{Задание}}. См. также методические указания по использованию Ресурса MachineLearning.ru в учебном процессе. |

→