Непараметрическая регрессия: ядерное сглаживание

Материал из MachineLearning.

(Новая: Coming soon) |

|||

| Строка 1: | Строка 1: | ||

| - | + | {{UnderConstruction|[[Участник:SL|SL]] 01:27, 12 января 2009 (MSK)}} | |

| + | '''Ядерное сглаживание''' - один из простейших видов [[Непараметрическая регрессия|непараметрической регрессии]]. | ||

| + | |||

| + | == Принцип == | ||

| + | Используйщий идейно простой подход к представлению последовательности весов <tex>\{ W_{ni}(x) \}_{i=1}^n</tex> состоит в описании формы весовой функции <tex>W_{ni}(x)</tex> посредством функции плотности со скалярным параметром, который регулирует размер и форму весов около х. Эту функцию формы принято называть ''ядром'' <tex>K</tex>. | ||

| + | |||

| + | == Последовательность весов == | ||

| + | === Определение ядра === | ||

| + | '''Ядро''' — это непрерывная ограниченная симметричная вещественная функция <tex>K</tex> с единичным интегралом | ||

| + | ::<tex>\int K(u)du=1</tex> | ||

| + | Последовательность весов для ядерных оценок (для одномерного | ||

| + | <tex>x</tex>) определяется как | ||

| + | ::<tex>W_{ni}(x)=\frac{K_{h_n}(x\;-\;X_i)}{\hat{f}_{h_n}(x)}</tex>, | ||

| + | где | ||

| + | ::<tex>\hat{f}_{h_n}(x)=\frac{\sum_{i=1}^n K_{h_n}(x\;-\;X_i)}{n}</tex>, | ||

| + | a | ||

| + | ::<tex>K_{h_n}(u)=\frac{K\(\frac{u}{h_n}\)}{h_n}</tex> | ||

| + | представляет собой ядро с параметром масштаба <tex>h_n</tex>. Подчеркнув | ||

| + | зависимость <tex>h\ =\ h_n</tex> от объема выборки <tex>n</tex>, условимся сокращен- | ||

| + | но обозначать последовательность весов <tex>W_{ni}(x)</tex>. | ||

| + | |||

| + | === Функция ядра === | ||

| + | Функция <tex>\hat{f}_{h_n}(x)</tex> является ''ядерной оценкой плотности Розенблата — Парзена'' (Rosenblatt, 1956; Parzen, 1962) для (маргинальной) плотности переменной <tex>x</tex>. Данный вид ядерных весов <tex>W_{ni}(x)</tex> был предложен в работах (Nadaraya, 1964) и (Watson, 1964), и, как следствие, | ||

| + | ::<tex>\hat{m}_h(x)=\frac{n^{-1}\sum_{i=1}^n K_{h_n}(x\;-\;X_i)Y_i}{n^{-1}\sum_{i=1}^n K_{h_n}(x\;-\;X_i)}</tex> | ||

| + | часто называют оценкой ''Надарая — Ватсона''. ''форма'' ядерных весов определяется ядром <tex>K</tex> в то время как ''размер'' весов параметризируется посредством переменной <tex>h</tex>, называемой ''шириной окна''. Нормализация весов <tex>\hat{f}_{h_n}(x)</tex> позволяет адаптироваться к локальной интенсивности переменной <tex>x</tex> и, кроме того, гарантирует, что сумма весов равна еденице. Вообще говоря, можно брать различные ядерные функции, нр как практика, так и теория ограничивают выбор. Так, например, ядерные функции, принимающие очень малые значения, могут приводить к машинному нулю компьютера, поэтому разумно рассматривать такие ядерные функции, которые равны нулю вне некоторого фиксированного интервала. | ||

| + | === Пример функции ядра === | ||

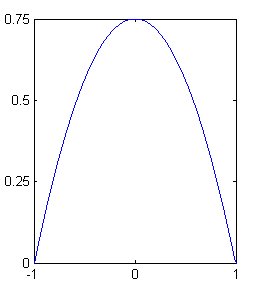

| + | [[Изображение:YepanchikovsKernel.png|thumb|right|260px|Ядро Бпанечникова. Это ядро <tex>K(u)=0.75(1-u^2)I(\| u \| \le 1)</tex> имеет параболическую форму и носитель <tex>[-1,1]</tex>.]] | ||

| + | Обычно используется ядерная функция, обладающая некоторыми свойствами оптимальности [Хардле В п4.5]; это функция | ||

| + | параболического типа (Epanechnikov, 1969; Bartlett, 1963): | ||

| + | ::<tex>K(u)=0.75(1-u^2)I(\| u \| \le 1)</tex>. | ||

| + | '''Замечание.''' Ядро не дифференцируемо при <tex>u = \pm 1</tex>. Ядерная оценка не определена для значения ширины окна с <tex>\hat{f}_{h_n}(x)=0</tex>. Если такой случай <tex>0/0</tex> возникает, то <tex>\hat{m}_h(x)</tex> определяется как <tex>0</tex>. | ||

| + | === Зависимость от ширины окна === | ||

| + | Допустим, что ядерная оценка вычисляется только в точках наблюдений <tex>\{ X_i\}_{i=1}^n</tex>. Тогда при <tex>h\rightarrow0</tex>, | ||

| + | ::<tex>\hat{m}_h(x)\rightarrow\frac{K(0)Y_i}{K(0)}=Y_i</tex>; | ||

| + | следовательно, малая ширина окна воспроизводит данные. Исследуем теперь, что происходит при <tex>h\rightarrow\infty</tex>. Допустим, что <tex>K</tex> имеет носитель <tex>[-1,1]</tex>, как на рис. Тогда <tex>K(x\;-\;X_i/h)\rightarrow K(0)</tex> и, следовательно, | ||

| + | ::<tex>\hat{m}_h(x)=\frac{n^{-1}\sum_{i=1}^n K(0)Y_i}{n^{-1}\sum_{i=1}^n K(0)}\;=\;n^{-1}\sum_{i=1}^n Y_i</tex> | ||

| + | Слишком большое значение ширины окна приводит таким образом к чрезмерному сглаживанию кривой — среднему арифметическому значений переменной отклика. | ||

| + | |||

| + | |||

| + | ==Литература== | ||

| + | # {{книга | ||

| + | |автор = Хардле В. | ||

| + | |заглавие = Прикладная непараметрическая регрессия | ||

| + | |год = 1989 | ||

| + | |ссылка = http://optimization.nlprog.ru/read/ru/8776859F6322A5AF21D45220A9B5B57E110C2E84/index.htm | ||

| + | }} | ||

| + | |||

| + | ==См. также== | ||

| + | * [[Ядерное сглаживание]] | ||

| + | * [[Регрессионный анализ]] | ||

| + | |||

| + | [[Категория:Регрессионный анализ]] | ||

Версия 22:27, 11 января 2009

| | Статья в настоящий момент дорабатывается. SL 01:27, 12 января 2009 (MSK) |

Ядерное сглаживание - один из простейших видов непараметрической регрессии.

Содержание |

Принцип

Используйщий идейно простой подход к представлению последовательности весов состоит в описании формы весовой функции

посредством функции плотности со скалярным параметром, который регулирует размер и форму весов около х. Эту функцию формы принято называть ядром

.

Последовательность весов

Определение ядра

Ядро — это непрерывная ограниченная симметричная вещественная функция с единичным интегралом

Последовательность весов для ядерных оценок (для одномерного

) определяется как

,

где

,

a

представляет собой ядро с параметром масштаба . Подчеркнув

зависимость

от объема выборки

, условимся сокращен-

но обозначать последовательность весов

.

Функция ядра

Функция является ядерной оценкой плотности Розенблата — Парзена (Rosenblatt, 1956; Parzen, 1962) для (маргинальной) плотности переменной

. Данный вид ядерных весов

был предложен в работах (Nadaraya, 1964) и (Watson, 1964), и, как следствие,

часто называют оценкой Надарая — Ватсона. форма ядерных весов определяется ядром в то время как размер весов параметризируется посредством переменной

, называемой шириной окна. Нормализация весов

позволяет адаптироваться к локальной интенсивности переменной

и, кроме того, гарантирует, что сумма весов равна еденице. Вообще говоря, можно брать различные ядерные функции, нр как практика, так и теория ограничивают выбор. Так, например, ядерные функции, принимающие очень малые значения, могут приводить к машинному нулю компьютера, поэтому разумно рассматривать такие ядерные функции, которые равны нулю вне некоторого фиксированного интервала.

Пример функции ядра

Обычно используется ядерная функция, обладающая некоторыми свойствами оптимальности [Хардле В п4.5]; это функция параболического типа (Epanechnikov, 1969; Bartlett, 1963):

.

Замечание. Ядро не дифференцируемо при . Ядерная оценка не определена для значения ширины окна с

. Если такой случай

возникает, то

определяется как

.

Зависимость от ширины окна

Допустим, что ядерная оценка вычисляется только в точках наблюдений . Тогда при

,

;

следовательно, малая ширина окна воспроизводит данные. Исследуем теперь, что происходит при . Допустим, что

имеет носитель

, как на рис. Тогда

и, следовательно,

Слишком большое значение ширины окна приводит таким образом к чрезмерному сглаживанию кривой — среднему арифметическому значений переменной отклика.

Литература

- Хардле В. Прикладная непараметрическая регрессия. — 1989.