Адаптивный линейный элемент

Материал из MachineLearning.

| Строка 7: | Строка 7: | ||

<br> | <br> | ||

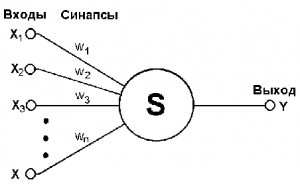

[[Изображение:Mat_model_neirona.png|300px|thumb|модель работы нейрона<ref>[http://mechanoid.narod.ru/nns/base/index.html#SECTION00042000000000000000 Основные модели и методы теории искусственных нейронных сетей, Е.С.Борисов, 2005-10-19]</ref>]] | [[Изображение:Mat_model_neirona.png|300px|thumb|модель работы нейрона<ref>[http://mechanoid.narod.ru/nns/base/index.html#SECTION00042000000000000000 Основные модели и методы теории искусственных нейронных сетей, Е.С.Борисов, 2005-10-19]</ref>]] | ||

| - | На вход подаётся вектор импульсов ''' | + | На вход подаётся вектор импульсов '''x<sub>n</sub>''' ,состоящий из '''n''' числовых признаков. Внутри нейрона импульсы складываются с некоторыми весами '''w<sub>j</sub>, j = 1..n''' и, если суммарный импульс '''S(x) =<tex>\textstyle\sum_{j=1}^n w_jx_j</tex>''' превысит ''порог активации'' '''w<sub>0</sub>''', то нейрон возбуждается и выдаёт некоторое значение '''a(x) = S(x) - w<sub>0</sub>'''. |

| + | <br><br> | ||

| + | Если добавить фиктивный импульс-признак '''x<sub>0</sub> ≡ -1''' и ему сопоставить вес '''w<sub>0</sub>''' - порог активации, то формулу выхода '''Y(x)''' можно выписать более компактно: | ||

| + | <br> | ||

| + | '''a(x) =(w,x) ''', где '''(w,x)''' - скалярное произведение, '''w''' и '''x''' - векторы весов и импульсов-признаков соответственно. | ||

| + | === Схема обучения ADALINE === | ||

| + | Пусть дана обучающая выборка: множество входных значений '''X''' и множество выходящих значений '''Y''', такие что каждому входу '''x<sub>j</sub>''' соответствует '''y<sub>j</sub>''' - выход, '''j = 1..l'''. Необходимо по этим данным построить ADALINE, которая допускает наименьшее количество ошибок на этой обучающей выборке. | ||

| + | Обучение ADALINE заключается в подборе "наилучших" значений вектора весов '''w'''. Какие значение весов лучше определяет | ||

| + | ''функционал потерь''.В ADALINE используется функционал, предложенный Видроу и Хоффом, '''L(a,x) = (a - y)<sup>2</sup>'''. Необходимо минимизировать | ||

| + | |||

| + | === Связь обучения ADALINE с Stochastic Gradient === | ||

| + | Схема обучения ADALINE соответствует схеме обучения линейного классификатора методом [[Метод стохастического градиента|стохастического градиента]] c линейной функцией активации '''φ(z) = z''' и квадратичной функцией потерь '''L(a,x) = (a - y)<sup>2</sup>'''. | ||

Версия 18:52, 5 января 2010

| | Данная статья является непроверенным учебным заданием.

До указанного срока статья не должна редактироваться другими участниками проекта MachineLearning.ru. По его окончании любой участник вправе исправить данную статью по своему усмотрению и удалить данное предупреждение, выводимое с помощью шаблона {{Задание}}. См. также методические указания по использованию Ресурса MachineLearning.ru в учебном процессе. |

Адаптивный линейный элемент(Адаптивный линейный нейрон или ADALINE) - частный случай линейного классификатора или искусственной нейронной сети с одним слоем. Был предложен Видроу и Хоффом в 1960 году, развивая математическую модель нейрона МакКаллока–Питтса.

Общая схема работы ADALINE

Схема работы ADALINE несколько напоминает работу биологического нейрона:

На вход подаётся вектор импульсов xn ,состоящий из n числовых признаков. Внутри нейрона импульсы складываются с некоторыми весами wj, j = 1..n и, если суммарный импульс S(x) = превысит порог активации w0, то нейрон возбуждается и выдаёт некоторое значение a(x) = S(x) - w0.

Если добавить фиктивный импульс-признак x0 ≡ -1 и ему сопоставить вес w0 - порог активации, то формулу выхода Y(x) можно выписать более компактно:

a(x) =(w,x) , где (w,x) - скалярное произведение, w и x - векторы весов и импульсов-признаков соответственно.

Схема обучения ADALINE

Пусть дана обучающая выборка: множество входных значений X и множество выходящих значений Y, такие что каждому входу xj соответствует yj - выход, j = 1..l. Необходимо по этим данным построить ADALINE, которая допускает наименьшее количество ошибок на этой обучающей выборке. Обучение ADALINE заключается в подборе "наилучших" значений вектора весов w. Какие значение весов лучше определяет функционал потерь.В ADALINE используется функционал, предложенный Видроу и Хоффом, L(a,x) = (a - y)2. Необходимо минимизировать

Связь обучения ADALINE с Stochastic Gradient

Схема обучения ADALINE соответствует схеме обучения линейного классификатора методом стохастического градиента c линейной функцией активации φ(z) = z и квадратичной функцией потерь L(a,x) = (a - y)2.