Стохастический градиентный спуск

Материал из MachineLearning.

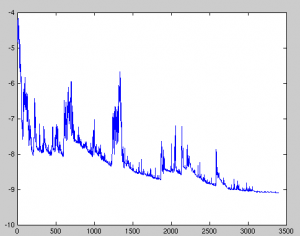

(Новая: Колебания целевой функции при компромиссном градиентном спуске '''...) |

(поправил ссылку) |

||

| (3 промежуточные версии не показаны) | |||

| Строка 17: | Строка 17: | ||

Стохастический градиентный спуск является одной из форм стохастического приближения. Теория стохастических приближений даёт условия сходимости метода стохастического градиентного спуска. | Стохастический градиентный спуск является одной из форм стохастического приближения. Теория стохастических приближений даёт условия сходимости метода стохастического градиентного спуска. | ||

| - | Одними из самых популярных алгоритмов стохастического градиентного спуска являются адаптивный фильтр [[Метод наименьших квадратов|наименьшей среднеквадратичной ошибки]] и алгоритм обратного распространения ошибок. | + | Одними из самых популярных алгоритмов стохастического градиентного спуска являются адаптивный фильтр [[Метод наименьших квадратов|наименьшей среднеквадратичной ошибки]] и [[алгоритм обратного распространения ошибок]]. |

==См. также== | ==См. также== | ||

| - | *[[Метод покоординатного спуска]] | + | *[[Метод покоординатного спуска|Покоординатный спуск]] |

*[[Метод наименьших квадратов]] | *[[Метод наименьших квадратов]] | ||

Текущая версия

Стохастический градиентный спуск относится к оптимизационным алгоритмам и нередко используется для настройки параметров модели машинного обучения.

При стандартном (или «пакетном», «batch») градиентном спуске для корректировки параметров модели используется градиент. Градиент обычно считается как сумма градиентов, вызванных каждым элементом обучения. Вектор параметров изменяется в направлении антиградиента с заданным шагом. Поэтому стандартному градиентному спуску требуется один проход по обучающим данным до того, как он сможет менять параметры.

При стохастическом (или «оперативном») градиентном спуске значение градиента аппроксимируются градиентом функции стоимости, вычисленном только на одном элементе обучения. Затем параметры изменяются пропорционально приближенному градиенту. Таким образом параметры модели изменяются после каждого объекта обучения. Для больших массивов данных стохастический градиентный спуск может дать значительное преимущество в скорости по сравнению со стандартным градиентным спуском.

Между этими двумя видами градиентного спуска существует компромисс, называемый иногда «mini-batch». В этом случае градиент аппроксимируется суммой для небольшого количества обучающих образцов.

Стохастический градиентный спуск является одной из форм стохастического приближения. Теория стохастических приближений даёт условия сходимости метода стохастического градиентного спуска.

Одними из самых популярных алгоритмов стохастического градиентного спуска являются адаптивный фильтр наименьшей среднеквадратичной ошибки и алгоритм обратного распространения ошибок.