Алгоритм LOWESS

Материал из MachineLearning.

(→Пример) |

(→Пример) |

||

| Строка 58: | Строка 58: | ||

!22 | !22 | ||

!23 | !23 | ||

| - | !24 !25 !26 !27 !28 !29 !30 | + | !24 |

| + | !25 | ||

| + | !26 | ||

| + | !27 | ||

| + | !28 | ||

| + | !29 | ||

| + | !30 | ||

|- | |- | ||

|X | |X | ||

| - | |130 |225 |95 |100 |170 |65 |175| 130| 80| 150| 150| 107 |122| 110| 52 | + | |130 |

| - | + | |225 | |

| + | |95 | ||

| + | |100 | ||

| + | |170 | ||

| + | |65 | ||

| + | |175 | ||

| + | |130 | ||

| + | |80 | ||

| + | |150 | ||

| + | |150 | ||

| + | |107 | ||

| + | |122 | ||

| + | |110 | ||

| + | |52 | ||

| + | |72 | ||

| + | |110 | ||

| + | |97 | ||

| + | |92 | ||

| + | |90 | ||

| + | |70 | ||

| + | |130 | ||

| + | |130 | ||

| + | |88 | ||

| + | |48 | ||

| + | |85 | ||

| + | |139 | ||

| + | |103 | ||

| + | |110 | ||

| + | |65 | ||

|- | |- | ||

| - | |Y | 18| 14| 25| 19| 13| 31 |14 |13| 28| 14| 11| 21| 20| 16| 31 | + | |Y |

| - | + | |18 | |

| - | + | |14 | |

| - | |} | + | |25 |

| + | |19 | ||

| + | |13 | ||

| + | |31 | ||

| + | |14 | ||

| + | |13 | ||

| + | |28 | ||

| + | |14 | ||

| + | |11 | ||

| + | |21 | ||

| + | |20 | ||

| + | |16 | ||

| + | |31 | ||

| + | |15 | ||

| + | |21 | ||

| + | |18 | ||

| + | |25 | ||

| + | |23 | ||

| + | |32 | ||

| + | |13 | ||

| + | |15 | ||

| + | |25 | ||

| + | |43 | ||

| + | |20 | ||

| + | |18 | ||

| + | |20 | ||

| + | |21 | ||

| + | |34 | ||

| + | } | ||

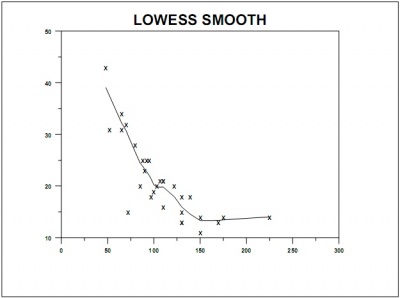

[[Изображение:Loess_smooth.jpg||Рис. 1. Пример применения loess-сглаживания|400px]] | [[Изображение:Loess_smooth.jpg||Рис. 1. Пример применения loess-сглаживания|400px]] | ||

Версия 20:59, 4 января 2010

| | Статья плохо доработана. |

Алгоритм LOWESS (locally weighted scatter plot smoothing) - локально взвешенное сглаживание.

Содержание |

Введение

- Данная методика была предложена Кливлендом(Cleveland) в 1979 году для моделирования и сглаживания двумерных данных

.

Эта техника предоставляет общий и гибкий подход для приближения двумерных данных.

- Локально линейная модель loess(lowess) можеть быть записана в виде:

- Эта модель может быть расширена на случай локально-квадратичной зависимости и на модель с больши'м числом независимых переменных.

- Параметры

и

локально линейной модели оцениваются, с помощью локально взвешенной регрессии, которая присваивает объекту тем больший вес, чем более близок он близким к объекту

. Характер

взвешивания определяется с помощью параметра сглаживания , который выбирает пользователь.

- Параметр

какая указывает доля данных используется в процедуре. Если

, то только половина данных используется для оценки и влияет на результат, и тогда мы получим умеренное сглаживание. С другой стороны, если

, то используются восемьдесят процентов данных, и сглаживание намного сильнее. Во всех случаях веса данных

тем больше чем они ближе к объекту .

- Процедура оценки использует не метод наименьших квадратов, а более устойчивый(робастный) метод, который принимает меры против выбросов.

График приближенных значений

против полезен для подведения итогов о связи между

и

. Для проверки качества приближения полученного с помощью процедуры устойчивого loess полезно посмотреть на график остатков обычной регресссии, то есть в осях (i) остатки против числа наблюдения (ii) остатки против приближенных значений, (iii) остатки против значений независимой переменной. Как показал Кливленд, может быть предпочтительно использовать график в осях модули остатков против полученных приближенных значений вместо графика (ii) для устойчивого loess сглаживания, чтобы проверить наличие тренда или других систематических особенностей.

Когда вычисления могут быть слишком долгими, в этом случае можно сократить количество вычислений оценивая

и

только в

точках отстоящих друг от друга как минимум на

единиц, где параметр

может задаваться либо приниматься по умолчанию. Рекомендуемые значения

.

С такими параметрами вычисления будут выполнены для примерно 100 точек.

Пример

| Переменная | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 | 13 | 14 | 15 | 16 | 17 | 18 | 19 | 20 | 21 | 22 | 23 | 24 | 25 | 26 | 27 | 28 | 29 | 30 | ||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| X | 130 | 225 | 95 | 100 | 170 | 65 | 175 | 130 | 80 | 150 | 150 | 107 | 122 | 110 | 52 | 72 | 110 | 97 | 92 | 90 | 70 | 130 | 130 | 88 | 48 | 85 | 139 | 103 | 110 | 65 | ||

| Y | 18 | 14 | 25 | 19 | 13 | 31 | 14 | 13 | 28 | 14 | 11 | 21 | 20 | 16 | 31 | 15 | 21 | 18 | 25 | 23 | 32 | 13 | 15 | 25 | 43 | 20 | 18 | 20 | 21 | 34

Решается задача восстановления регрессии. Задано пространство объектов Непараметрическая регрессия

для каждого объекта В формуле Надарая–Ватсона для учета близости объектов Параметр Оптимизация ширины окнаЧтобы оценить при данном Проблема выбросов

крайне чувствительна к большим одиночным выбросам. На практике легко идентифицируются только грубые ошибки, возникающие, например, в результате сбоя оборудования или невнимательности персонала при подготовке данных. В общем случае можно лишь утверждать, что чем больше величина ошибки тем в большей степени прецедент Алгоритм LOWESSВход

ВыходКоэффициенты Алгоритм

Коэффициенты Выбор ядра

Пусть Более простой вариант, состоит в отбросе где Примеры примененияЛитература

См. также

|