Аппроксимация Лапласа (пример)

Материал из MachineLearning.

(→Вычислительный эксперимент) |

(→Вычислительный эксперимент) |

||

| Строка 17: | Строка 17: | ||

==Вычислительный эксперимент== | ==Вычислительный эксперимент== | ||

| - | Обозначим плоность распределения SSE как <tex> p_{SSE}</tex>, а его апроксимация лапласса <tex> p_{ | + | Обозначим плоность распределения SSE как <tex> p_{SSE}</tex>, а его апроксимация лапласса <tex> p_{laplas}</tex> |

===Пример 1=== | ===Пример 1=== | ||

| Строка 25: | Строка 25: | ||

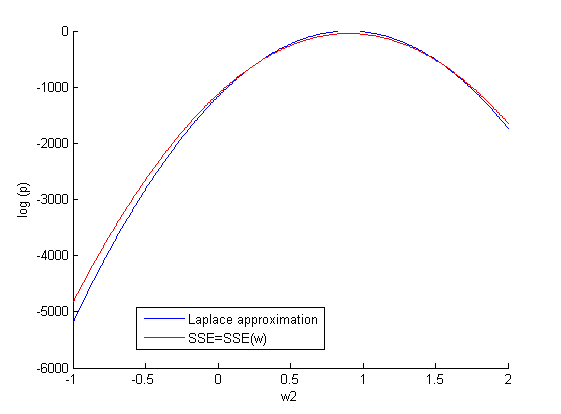

'''При фиксированном''' <tex>w_1=w_1_{opt}</tex> задем произвольное значение <tex>w_2</tex> (500 значений на отрезке [-1;2]) и строим зависимость: | '''При фиксированном''' <tex>w_1=w_1_{opt}</tex> задем произвольное значение <tex>w_2</tex> (500 значений на отрезке [-1;2]) и строим зависимость: | ||

| - | [[Изображение:Sse(w2)_1.png|center | + | [[Изображение:Sse(w2)_1.png|center]] |

| - | '''Повторим | + | <tex>D_{kl}(p_{SSE},p_{laplas})=0.0085</tex> |

| + | |||

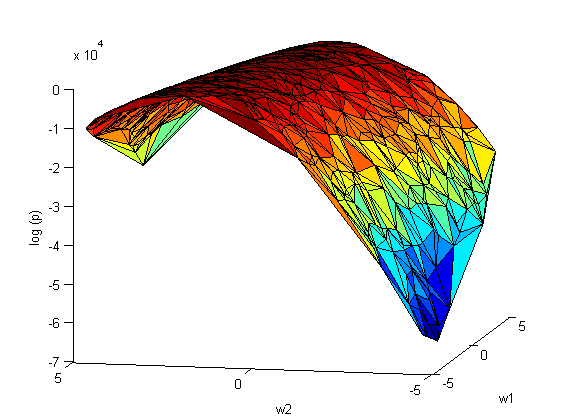

| + | '''Повторим эксперимент''', только теперь варируем сразу оба параметра <tex>w_1</tex> и <tex>w_2</tex> | ||

[[Изображение:Sse(w1,w2).png|center]] | [[Изображение:Sse(w1,w2).png|center]] | ||

| Строка 35: | Строка 37: | ||

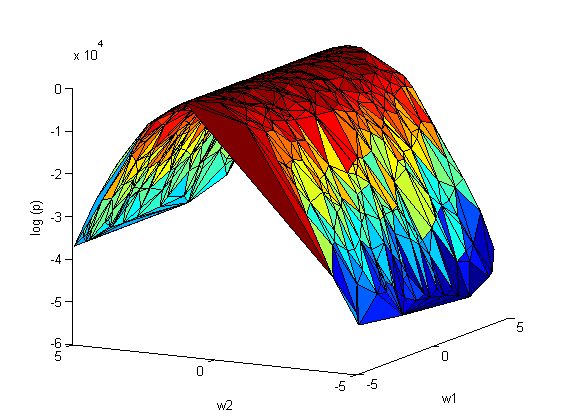

[[Изображение:Sse(w1,w2)_laplas.png|center]] | [[Изображение:Sse(w1,w2)_laplas.png|center]] | ||

| - | + | <tex>D_{kl}(p_{SSE},p_{laplas})=1.4616</tex> | |

Версия 19:23, 16 ноября 2010

Аппроксимация Лапласа - простой, но широко используемый способ нахождения нормального (Гауссово) распределения для апроксимации заданой плотности вероятности.

Содержание |

Сэмплирование

Сэмплирование – процесс выбора подмножества наблюдаемых величин из данного множества, для дальнейшего его анализа.

Одно из основных приминений методов сэмплирования заключается в оценке мат. ожидания сложных вероятностных распределений: , для которых тяжело делать выборку непосредственно из распределения p(z). Однако, можно подсчитать значение p(z) в любой точке z. Один из наиболее простых методов подсчета мат. ожидаия – разбить ось z на равномерную сетку и подсчитать интеграл как сумму

≅

. Существует несколько методов сэмплирования для создания подходящей выборки длинны L ???.

Постановка задачи

Задана выборка — множество значений свободных переменных и множество

соответствующих им значений зависимой переменной.

Необходимо для выбранной регрессионной модели

показать зависимость среднеквадратичной ошибки от значений параметров модели:

; построить график и сделать апроксимацию Лапласа для него; найти расстояния между получиными зависимостями, используя метрику Кульбака - Лейблера.

Описание алгоритма

метрика Кульбака - Лейблера:

Вычислительный эксперимент

Обозначим плоность распределения SSE как , а его апроксимация лапласса

Пример 1

Задуманная функция . Берем линейную регрессионную модель с 2-мя параметрами:

.

Используя МНК находим оптимальное значение

и

(при которых SSE минимально).

При фиксированном задем произвольное значение

(500 значений на отрезке [-1;2]) и строим зависимость:

Повторим эксперимент, только теперь варируем сразу оба параметра и

и его апроксимация лапласса