Графические модели (курс лекций)/2014/Задание 2

Материал из MachineLearning.

(→Задача помехоустойчивого кодирования) |

м |

||

| (11 промежуточных версий не показаны.) | |||

| Строка 1: | Строка 1: | ||

| - | |||

| - | |||

{{Main|Графические модели (курс лекций)}} | {{Main|Графические модели (курс лекций)}} | ||

| Строка 8: | Строка 6: | ||

|} | |} | ||

| - | '''Начало выполнения задания''': | + | '''Начало выполнения задания''': 5 марта 2014 г.<br> |

'''Срок сдачи''': {{важно|18 марта 2014 г., 23:59.}} | '''Срок сдачи''': {{важно|18 марта 2014 г., 23:59.}} | ||

| Строка 19: | Строка 17: | ||

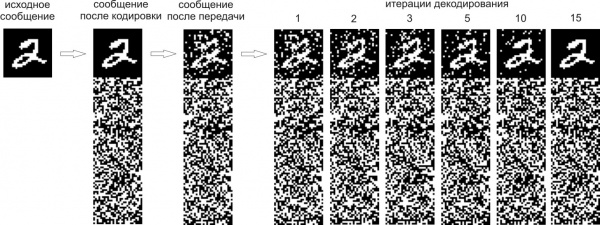

Рассмотрим решение задачи безошибочной передачи потока битовой информации по каналу с шумом с помощью кодов, исправляющих ошибки. При ''блоковом'' кодировании входящий поток информации разбивается на блоки фиксированной длины <tex>k</tex>, и каждый блок кодируется/декодируется независимо. Обозначим один такой блок через <tex>u\in\{0,1\}^k</tex>. Предположим, что во входном потоке данных, вообще говоря, нет избыточности. Поэтому для реализации схемы, способной исправлять ошибки, необходимо закодировать блок <tex>u</tex> в некоторое кодовое слово большей длины путем добавления избыточности в передаваемые данные. Обозначим кодовое слово через <tex>v\in\{0,1\}^n</tex>, <tex>n>k</tex>. Для кодирования всевозможных блоков <tex>u</tex> необходимо использовать <tex>2^k</tex> кодовых слов длины <tex>n</tex>. Назовём множество <tex>2^k</tex> кодовых слов длины <tex>n</tex> ''(n,k)-блоковым кодом'', а величину <tex>r=k/n</tex> — ''скоростью кода''. При передаче по каналу с шумом кодовое слово <tex>v</tex> превращается в принятое слово <tex>w</tex>, которое, вообще говоря, отличается от <tex>v</tex>. Предположим, что при передаче по каналу длина сообщения не изменяется, т.е. <tex>w\in\{0,1\}^n</tex>, а происходит лишь инверсия некоторых бит. Задача алгоритма декодирования состоит в восстановлении по <tex>w</tex> переданного слова <tex>v</tex> (например, путем поиска среди всевозможных кодовых слов ближайшего к <tex>w</tex>). Обозначим результат работы алгоритма декодирования через <tex>\hat{v}</tex>. На последнем этапе декодированное слово <tex>\hat{v}</tex> переводится в декодированное слово исходного сообщения <tex>\hat{u}</tex>. | Рассмотрим решение задачи безошибочной передачи потока битовой информации по каналу с шумом с помощью кодов, исправляющих ошибки. При ''блоковом'' кодировании входящий поток информации разбивается на блоки фиксированной длины <tex>k</tex>, и каждый блок кодируется/декодируется независимо. Обозначим один такой блок через <tex>u\in\{0,1\}^k</tex>. Предположим, что во входном потоке данных, вообще говоря, нет избыточности. Поэтому для реализации схемы, способной исправлять ошибки, необходимо закодировать блок <tex>u</tex> в некоторое кодовое слово большей длины путем добавления избыточности в передаваемые данные. Обозначим кодовое слово через <tex>v\in\{0,1\}^n</tex>, <tex>n>k</tex>. Для кодирования всевозможных блоков <tex>u</tex> необходимо использовать <tex>2^k</tex> кодовых слов длины <tex>n</tex>. Назовём множество <tex>2^k</tex> кодовых слов длины <tex>n</tex> ''(n,k)-блоковым кодом'', а величину <tex>r=k/n</tex> — ''скоростью кода''. При передаче по каналу с шумом кодовое слово <tex>v</tex> превращается в принятое слово <tex>w</tex>, которое, вообще говоря, отличается от <tex>v</tex>. Предположим, что при передаче по каналу длина сообщения не изменяется, т.е. <tex>w\in\{0,1\}^n</tex>, а происходит лишь инверсия некоторых бит. Задача алгоритма декодирования состоит в восстановлении по <tex>w</tex> переданного слова <tex>v</tex> (например, путем поиска среди всевозможных кодовых слов ближайшего к <tex>w</tex>). Обозначим результат работы алгоритма декодирования через <tex>\hat{v}</tex>. На последнем этапе декодированное слово <tex>\hat{v}</tex> переводится в декодированное слово исходного сообщения <tex>\hat{u}</tex>. | ||

| - | === Кодирование с помощью ( | + | === Кодирование с помощью (n,k)-линейного блокового кода === |

| - | Множество <tex>\{0,1\}^ | + | Множество <tex>\{0,1\}^n</tex> с операциями суммы и произведения по модулю 2 образует линейное пространство над конечным полем из двух элементов <tex>\{0,1\}</tex>. (n,k)-блоковый код называется ''линейным'', если множество его кодовых слов образует линейное подпространство размерности <tex>k</tex> общего линейного пространства <tex>\{0,1\}^n</tex>. Одним из способов задания <tex>k</tex>-мерного линейного подпространства является рассмотрение множества решений следующей системы линейных уравнений: |

| - | :<tex> | + | :<tex>Hv=0</tex>, |

| - | где <tex>H\in\{0,1\}^{( | + | где <tex>H\in\{0,1\}^{(n-k){\times}n}</tex> — матрица ранга <tex>m=n-k</tex> (эта матрица задаёт базис линейного подпространства, ортогонального к рассматриваемому (n,k)-коду). Матрица <tex>H</tex> называется ''проверочной матрицей'' кода, т.к. с её помощью можно проверить, является ли слово <tex>v</tex> кодовым словом путём проверки соотношения <tex>Hv=0</tex> (здесь и далее все операции проводятся по модулю 2). |

| - | Рассмотрим задачу кодирования слов исходного сообщения <tex> | + | Рассмотрим задачу кодирования слов исходного сообщения <tex>u</tex> в кодовые слова <tex>v</tex> (n,k)-линейного блокового кода, заданного своей проверочной матрицей <tex>H</tex>. Для этого можно найти базис <tex>k</tex>-мерного линейного подпространства <tex>g_1,\dots,g_k\in\{0,1\}^n</tex>. Тогда, рассматривая базисные вектора как столбцы общей матрицы <tex>G\in\{0,1\}^{n{\times}k}</tex>, операция кодирования может быть представлена как <tex>v=Gu</tex>. Матрица <tex>G</tex> называется ''порождающей матрицей'' кода. Кодирование называется ''систематическим'', если все биты слова <tex>u</tex> копируются в некоторые биты кодового слова <tex>v</tex>, т.е. в матрице <tex>G</tex> некоторое подмножество строк образует единичную матрицу размера <tex>k{\times}k</tex>. При систематическом кодировании обратный процесс преобразования из декодированного кодового слова <tex>\hat{v}</tex> в декодированное сообщение <tex>\hat{u}</tex> становится тривиальным. |

| - | Одним из способов построения порождающей матрицы кода по заданной проверочной матрице является преобразование проверочной матрицы к [http://ru.wikipedia.org/wiki/Ступенчатый_вид_по_строкам каноническому ступенчатому виду]. Такое преобразование всегда может быть сделано с помощью [http://en.wikipedia.org/wiki/Gaussian_elimination гауссовских исключений]. С точностью до перестановки столбцов канонический ступенчатый вид матрицы <tex>H</tex> эквивалентен её представлению в виде <tex>\begin{bmatrix} I_{ | + | Одним из способов построения порождающей матрицы кода по заданной проверочной матрице является преобразование проверочной матрицы к [http://ru.wikipedia.org/wiki/Ступенчатый_вид_по_строкам каноническому ступенчатому виду]. Такое преобразование всегда может быть сделано с помощью [http://en.wikipedia.org/wiki/Gaussian_elimination гауссовских исключений]. С точностью до перестановки столбцов канонический ступенчатый вид матрицы <tex>H</tex> эквивалентен её представлению в виде <tex>\begin{bmatrix} I_{m} & P\end{bmatrix}</tex>, где <tex>I_{m}</tex> — единичная матрица размера <tex>m{\times}m</tex>. Тогда в качестве порождающей матрицы, обеспечивающей систематическое кодирование, можно выбрать матрицу |

| - | :<tex>G = \begin{bmatrix}P\\ | + | :<tex>G = \begin{bmatrix}P\\ I_k\end{bmatrix}</tex>. |

| - | Действительно, в этом случае <tex> | + | Действительно, в этом случае <tex>HGu = (P+P)u = 0</tex>. |

=== Декодирование низкоплотностного кода === | === Декодирование низкоплотностного кода === | ||

| Строка 35: | Строка 33: | ||

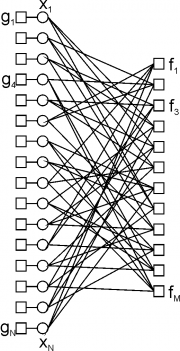

[[Image:GM13_task2_fg.png|thumb|Фактор-граф для (16,4)-низкоплотностного кода, в проверочной матрице которого в каждом столбце по 3 единицы, а в каждой строке - по 4 единицы.]] | [[Image:GM13_task2_fg.png|thumb|Фактор-граф для (16,4)-низкоплотностного кода, в проверочной матрице которого в каждом столбце по 3 единицы, а в каждой строке - по 4 единицы.]] | ||

| - | ''Низкоплотностным кодом'' (или кодом с малой плотностью проверок на чётность) называется бинарный ( | + | ''Низкоплотностным кодом'' (или кодом с малой плотностью проверок на чётность) называется бинарный (n,k)-линейный блоковый код, в котором проверочная матрица <tex>H\in\{0,1\}^{m{\times}n}</tex> является сильно разреженной. |

| - | Рассмотрим бинарный симметричный канал для передачи данных. Здесь при передаче каждый бит независимо инвертируется с некоторой вероятностью q. В результате бинарный симметричный канал задает распределение <tex>p( | + | Рассмотрим бинарный симметричный канал для передачи данных. Здесь при передаче каждый бит независимо инвертируется с некоторой вероятностью <tex>q</tex>. В результате бинарный симметричный канал задает распределение <tex>p(w|v)</tex> для передаваемого кодового слова <tex>v\in\{0,1\}^n</tex> и полученного на выходе слова <tex>w\in\{0,1\}^n</tex> как |

| - | :<tex>p( | + | :<tex>p(w|v) = \prod_{i=1}^np(w_i|v_i) = \prod_{i=1}^nq^{w_i+v_i}(1-q)^{w_i+v_i+1}</tex>. |

[http://en.wikipedia.org/wiki/Channel_capacity Пропускная способность] данного канала определяется величиной <tex>1+q\log_2q+(1-q)\log_2(1-q)</tex>. | [http://en.wikipedia.org/wiki/Channel_capacity Пропускная способность] данного канала определяется величиной <tex>1+q\log_2q+(1-q)\log_2(1-q)</tex>. | ||

| - | Объединяя низкоплотностный код с бинарным симметричным каналом, получаем следующую вероятностную модель для пары <tex> | + | Объединяя низкоплотностный код с бинарным симметричным каналом, получаем следующую вероятностную модель для пары <tex>w,v</tex>: |

| - | :<tex>p( | + | :<tex>p(v|w)\propto p(w|v)I[Hv=0] \propto \prod_{i=1}^np(w_i|v_i)\prod_{j=1}^mI[h_j^Tv = 0]</tex>. |

| - | Здесь | + | Здесь <tex>m=n-k</tex> — количество проверок на чётность, <tex>h_j^T</tex> — j-ая строка матрицы H, а <tex>I[\cdot]</tex> — индикаторная функция. Фактор-граф введённой модели показан на рис. справа. |

| - | + | Назовём ''синдромом'' принятого слова <tex>w</tex> вектор <tex>s\in\{0,1\}^m</tex>, определяемый как <tex>s=Hw</tex>. Процесс передачи кодового слова по бинарному симметричному каналу можно представить как <tex>w=v+e</tex>, где <tex>e\in\{0,1\}^n</tex> — вектор ошибок (<tex>e_i=1</tex>, если в позиции <tex>i</tex> произошла ошибка). Тогда <tex>s = Hw = H(v+e) = Hv+He = He</tex>. Далее можно перейти от вероятностной модели для переменных <tex>v,w</tex> к аналогичной для переменных <tex>e,s</tex>: | |

| - | <tex> | + | :<tex>p(e|s)\propto p(e)p(s|e) \propto\prod_{i=1}^np(e_i)\prod_{j=1}^mI[h_j^Te=s_j]</tex>. |

| - | Введём обозначения <tex>N( | + | Здесь <tex>p(e_i)=q^{e_i}(1-q)^{1-e_i}</tex>. Зная значение вектора ошибок <tex>\hat{e}</tex>, результат декодирования вычисляется как <tex>\hat{v}=w+\hat{e}</tex>. При использовании вероятностной модели для <tex>e,s</tex> тестирование алгоритма декодирования можно проводить без предварительной реализации процедуры кодирования. |

| + | |||

| + | При использовании побитовой функции потерь <tex>\lambda(e,\tilde{e}) = \sum_{i=1}^nI[e_i\neq \tilde{e}_i]</tex> оптимальная процедура декодирования связана с максимизацией маргиналов отдельных переменных, т.е. <tex>\hat{e}_n = \arg\max p(e_n|s)</tex>. Для поиска маргинальных распределений <tex>p(e_n|s)</tex> воспользуемся циклическим алгоритмом передачи сообщений (sum-product loopy BP) на фактор-графе. Введём обозначения <tex>N(i)=\{j:H_{ji}=1\}</tex> — множество факторов, в которых участвует переменная <tex>e_i</tex>, и <tex>N(j)=\{i:H_{ji}=1\}</tex> — множество переменных, которые входят в фактор <tex>h_j</tex>. Тогда общая схема алгоритма декодирования выглядит следующим образом: | ||

1. Инициализация: | 1. Инициализация: | ||

| - | : <tex>\mu_{ | + | : <tex>\mu_{e_i\rightarrow h_j}(e_i) = p(e_i)</tex>; |

2. Пересчет сообщений от факторов: | 2. Пересчет сообщений от факторов: | ||

| - | : <tex>\mu_{ | + | : <tex>\mu_{h_j\rightarrow e_i}(e_i) = \sum_{e_k:k\in N(j)\backslash i}I[e_i+\sum_{k}e_{k}=s_j]\prod_{k\in N(j)\backslash i}\mu_{e_{k}\rightarrow h_j}(e_{k})</tex>; |

| - | 3. Пересчет сообщений от переменных: | + | 3. Пересчет сообщений от переменных и вычисление beliefs (оценок на маргинальные распределения): |

| - | : <tex>\mu_{ | + | : <tex>\mu_{e_i\rightarrow h_j}(e_i) \propto p(e_i)\prod_{k\in N(i)\backslash j}\mu_{h_{k}\rightarrow e_i}(e_i)</tex>;<br> |

| - | : <tex> | + | : <tex>b_i(e_i)\propto p(e_i)\prod_{k\in N(i)}\mu_{h_{k}\rightarrow e_i}(e_i)</tex>; |

| - | + | 4. Оценка вектора ошибок: | |

| - | 4. Оценка | + | : <tex>\hat{e}_i=\arg\max b_i(e_i)</tex>; |

| - | : <tex>\hat{ | + | |

5. Критерий остановки: | 5. Критерий остановки: | ||

| - | : Если <tex>H\hat{ | + | : Если <tex>H\hat{e}=s</tex>, то выход алгоритма со статусом 0; |

| - | : Если | + | : Если произошла стабилизация по всем <tex>b_i</tex>, то выход алгоритма со статусом 1; |

| + | : Если достигнуто максимальное число итераций, то выход алгоритма со статусом 2; | ||

: Переход к шагу 2. | : Переход к шагу 2. | ||

| - | + | === Оптимизации в процедуре декодирования === | |

| - | + | ==== Пересчёт сообщений от факторов ==== | |

| - | + | При прямой реализации шага 2 общего алгоритма декодирования требуется рассмотрение для каждого фактора <tex>2^{|N(j)|-1}</tex> различных конфигураций значений переменных <tex>e_k</tex>. Это может приводить как к низкой скорости пересчета сообщений, так и к большим требованиям по памяти. | |

| - | + | Рассмотрим более эффективную схему реализации шага 2. Пусть нам необходимо вычислить сообщение <tex>\mu_{h_j\rightarrow e_i}(e_i)</tex>. Перенумеруем все переменные, входящие в j-ый фактор (кроме переменной <tex>e_i</tex>), как <tex>e_{(1)},e_{(2)},\dots,e_{(l)}</tex>, где <tex>l=|N(j)|-1</tex>. Тогда вычисление сообщения <tex>\mu_{h_j\rightarrow e_i}(e_i)</tex> можно записать как | |

| - | + | :<tex>\mu_{h_j\rightarrow e_i}(e_i)\propto\sum_{e_{(k)}}I[\sum_{k=1}^le_{(k)} = s_j+e_i]\prod_{k=1}^l\mu_{e_{(k)}\rightarrow h_j}(e_{(k)})</tex>. | |

| - | + | Данный результат можно интерпретировать как вычисление вероятности <tex>p(\sum_{k=1}^le_{(k)}=s_j+e_i)</tex> для набора независимых бинарных переменных <tex>e_{(k)}</tex> с распределением <tex>p_{(k)}(e_{(k)}) = \mu_{e_{(k)}\rightarrow h_j}(e_{(k)}).</tex> Обозначим через <tex>e^k</tex> сумму первых <tex>k</tex> переменных <tex>e_{(k)}</tex>, т.е. <tex>e^k=e_{(1)}+e_{(2)}+\dots+e_{(k)}</tex>. Тогда распределение на <tex>e^k</tex> можно итерационно пересчитывать по формуле | |

| + | :<tex>p_k(e^k) = \sum_{e^{k-1}}p_{k-1}(e^{k-1})p_{(k)}(e^k-e^{k-1})</tex>. | ||

| - | + | В результате вычисление <tex>p_l(e^l)</tex> имеет линейную по <tex>l</tex> сложность. | |

| - | + | ||

| - | + | ||

| - | + | ||

| - | + | Дальнейшее повышение эффективности реализации шага 2 связано с рассмотрением разностей вероятностей <tex>\delta p_{(k)} = p_{(k)}(0) - p_{(k)}(1)</tex> и <tex>\delta p_k = p_k(0)-p_k(1)</tex>. Нетрудно показать, что | |

| + | :<tex>\delta p_l = \prod_{k=1}^l\delta p_{(k)}</tex>. (*) | ||

| - | + | Зная значение <tex>\delta p_l</tex> и учитывая условие нормировки <tex>p_l(0)+p_l(1)=1</tex>, сами вероятности могут быть вычислены как <tex>p_l(0)=\frac{1}{2}(1+\delta p_l)</tex>, <tex>p_l(1)=\frac{1}{2}(1-\delta p_l)</tex>. Таким образом, <tex>\mu_{h_j\rightarrow e_i}(e_i) = p_l(s_j+e_i)</tex>. Основное преимущество условия (*) по сравнению с последовательным пересчётом распределений <tex>p_k(e^k)</tex> связано с тем, что формула (*) может быть реализована с помощью векторных операций в MATLAB. | |

| - | :<tex>\ | + | |

| - | + | ==== Расписание пересчёта сообщений и дэмпфирование ==== | |

| - | + | ||

| - | + | Общая схема циклического алгоритма передачи сообщений оставляет определённый произвол в выборе расписания пересчёта сообщений. Обычно здесь рассматриваются следующие подходы: | |

| + | * ''Параллельное расписание''. В данном случае сначала все вершины посылают сообщения во все факторы, а затем все факторы посылают сообщения во все вершины. | ||

| + | * ''Последовательное расписание''. Здесь выбирается некоторый (например, случайный) порядок последовательного пересчёта всех сообщений (и от вершин к факторам, и от факторов к вершинам). При этом данный порядок может меняться от итерации к итерации. | ||

| + | |||

| + | При использовании дэмпфирования с параметром <tex>\lambda\in(0,1]</tex> сообщения на итерации <tex>t</tex> пересчитываются как | ||

| + | :<tex>\mu^t_{h_j\rightarrow e_i}(e_i) = \lambda\mu_{h_j\rightarrow e_i}(e_i) + (1-\lambda)\mu^{t-1}_{h_j\rightarrow e_i}(e_i)</tex>; | ||

| + | :<tex>\mu^t_{e_i\rightarrow h_j}(e_i) = \lambda\mu_{e_i\rightarrow h_j}(e_i) + (1-\lambda)\mu^{t-1}_{e_i\rightarrow h_j}(e_i)</tex>. | ||

| + | |||

| + | Здесь <tex>\mu_{h_j\rightarrow e_i}(e_i)</tex> и <tex>\mu_{e_i\rightarrow h_j}(e_i)</tex> — сообщения, вычисляемые на шагах 2 и 3 общего алгоритма декодирования. | ||

== Формулировка задания == | == Формулировка задания == | ||

# Реализовать алгоритм построения по заданной проверочной матрице чётности H порождающей матрицы кода G для систематического кодирования; | # Реализовать алгоритм построения по заданной проверочной матрице чётности H порождающей матрицы кода G для систематического кодирования; | ||

| - | # Реализовать алгоритм декодирования низкоплотностного кода на основе loopy BP; при реализации шага 2 пересчета сообщений от факторов | + | # Реализовать алгоритм декодирования низкоплотностного кода на основе loopy BP; при реализации шага 2 пересчета сообщений от факторов к переменным необходимо использовать эффективные схемы, обозначенные выше; реализовать последовательное и параллельное расписание пересчёта сообщений, а также дэмпфирование сообщений; при реализации на MATLAB одной итерации схемы передачи сообщений использование вложенных циклов является нежелательным; |

| - | # Рассмотрим две характеристики качества кода — вероятность совершить ошибку хотя бы в одном бите при декодировании блока (<tex>p(\hat{ | + | # Провести эксперименты с различными расписаниями пересчёта сообщений и коэффициентами дэмпфирования; в частности, оценить долю стабилизировавшихся beliefs в зависимости от номера итерации алгоритма декодирования (усреднённую по различным запускам); оценить время работы алгоритма декодирования в зависимости от выбранного расписания и коэффициента дэмпфирования; |

| - | # Провести эксперименты по оцениванию битовой и блоковой ошибки низкоплотностного кода для различных значений длины кодового слова | + | # Рассмотрим две характеристики качества кода — вероятность совершить ошибку хотя бы в одном бите при декодировании блока (<tex>p(\hat{e}\neq e)</tex>) и среднюю вероятность совершить ошибку при декодировании в одном бите (<tex>\frac{1}{n}\sum_{i=1}^np(\hat{e}_i\neq e_i)</tex>). Требуется реализовать алгоритм оценки вероятности битовой и блоковой ошибки кода с помощью метода стат. испытаний (многократная случайная генерация вектора ошибок <tex>e</tex> (<tex>e_i=1</tex> с вероятностью <tex>q</tex>), вычисление по нему синдрома <tex>s=He</tex>, восстановление вектора ошибок <tex>\hat{e}</tex> с помощью алгоритма декодирования и подсчет необходимых характеристик); |

| - | #* [http://ru.wikipedia.org/wiki/Теоремы_Шеннона_для_канала_с_шумами Теорема Шеннона] определяет пропускную способность канала как максимально допустимую скорость кода, при которой возможно осуществление надежной коммуникации. Требуется проверить, как меняются характеристики кода при изменении скорости | + | # Провести эксперименты по оцениванию битовой и блоковой ошибки низкоплотностного кода для различных значений длины кодового слова <tex>n</tex>, скорости кода <tex>r</tex>, вероятности инвертирования бита при передаче по каналу связи <tex>q</tex> и среднего количества единиц в столбце проверочной матрицы <tex>j</tex>. В частности, необходимо проанализировать следующие ситуации: |

| - | #* Теорема Шеннона предполагает, что качество кода растет при увеличении длины кодового слова | + | #* [http://ru.wikipedia.org/wiki/Теоремы_Шеннона_для_канала_с_шумами Теорема Шеннона] определяет пропускную способность канала как максимально допустимую скорость кода, при которой возможно осуществление надежной коммуникации. Требуется проверить, как меняются характеристики кода при изменении скорости <tex>r</tex> от минимального значения до пропускной способности канала. |

| - | #* Одно из следствий теоремы Шеннона утверждает, что хорошими кодами являются коды со случайной проверочной матрицей H. В частности, здесь предполагается, что качество кода должно расти при увеличении среднего количества единиц в столбце проверочной матрицы j. Требуется проверить это утверждение для низкоплотностных кодов (путём рассмотрения нескольких значений j, начиная от 3). | + | #* Теорема Шеннона предполагает, что качество кода растет при увеличении длины кодового слова <tex>n</tex>. Требуется проверить это предположение. |

| - | # Составить отчёт в формате PDF с описанием всех проведённых исследований | + | #* Одно из следствий теоремы Шеннона утверждает, что хорошими кодами являются коды со случайной проверочной матрицей H. В частности, здесь предполагается, что качество кода должно расти при увеличении среднего количества единиц в столбце проверочной матрицы <tex>j</tex>. Требуется проверить это утверждение для низкоплотностных кодов (путём рассмотрения нескольких значений <tex>j</tex>, начиная от 3). |

| + | # Провести эксперименты по сравнению низкоплотностного кода [[Практикум на ЭВМ (317)/2013/Коды БЧХ|с кодами БЧХ]]; в частности, провести эксперименты для различных <tex>q</tex> при фиксированной скорости кода <tex>r</tex>, а также для различных <tex>r</tex> при фиксированной <tex>q</tex>; | ||

| + | # Составить отчёт в формате PDF с описанием всех проведённых исследований. | ||

== Рекомендации по выполнению задания == | == Рекомендации по выполнению задания == | ||

| - | 1. Разреженную проверочную матрицу кода заданных размеров можно строить с помощью случайной генерации (с соблюдением условия полноранговости). Однако, здесь рекомендуется воспользоваться [[Media:make_ldpc_mex.zip|готовой реализацией]], которая генерирует проверочную матрицу заданного размера с заданным количеством единиц в каждом столбце. При этом реализованный алгоритм старается сократить количество циклов длины 4 в генерируемой матрице, т.к. наличие коротких циклов в графе, как правило, | + | 1. Разреженную проверочную матрицу кода заданных размеров можно строить с помощью случайной генерации (с соблюдением условия полноранговости). Однако, здесь рекомендуется воспользоваться [[Media:make_ldpc_mex.zip|готовой реализацией]], которая генерирует проверочную матрицу заданного размера с заданным количеством единиц в каждом столбце. При этом реализованный алгоритм старается сократить количество циклов длины 4 в генерируемой матрице, т.к. наличие коротких циклов в графе, как правило, усложняет работу алгоритма loopy BP. |

| - | 2 | + | 2. При тестировании алгоритма декодирования рекомендуется пробовать запускать итерационный процесс из различных начальных приближений для сообщений (не только из значений унарных потенциалов). При корректной реализации метода должна наблюдаться сходимость к одним и тем же финальным сообщениям независимо от начальных приближений. |

| - | + | ||

| - | + | ||

| - | + | ||

| - | + | ||

| - | + | ||

| - | + | ||

== Оформление задания == | == Оформление задания == | ||

| - | Выполненное задание следует отправить письмом по адресу ''bayesml@gmail.com'' с заголовком письма «[ | + | Выполненное задание следует отправить письмом по адресу ''bayesml@gmail.com'' с заголовком письма «[ГМ14] Задание 2 <ФИО>». Убедительная просьба присылать выполненное задание '''только один раз''' с окончательным вариантом. Также убедительная просьба строго придерживаться заданных ниже прототипов реализуемых функций. |

Присланный вариант задания должен содержать в себе: | Присланный вариант задания должен содержать в себе: | ||

| Строка 133: | Строка 136: | ||

| | | | ||

{|border="0" | {|border="0" | ||

| - | |H — проверочная матрица чётности, бинарная матрица размера | + | |H — проверочная матрица чётности, бинарная матрица размера m x n; |

|} | |} | ||

|- | |- | ||

| Строка 140: | Строка 143: | ||

| | | | ||

{| | {| | ||

| - | |G — порождающая матрица кода, бинарная матрица размера | + | |G — порождающая матрица кода, бинарная матрица размера n x k; |

|- | |- | ||

|ind — номера позиций кодового слова, в которые копируются биты исходного сообщения, т.е. G(ind, :) является единичной матрицей. | |ind — номера позиций кодового слова, в которые копируются биты исходного сообщения, т.е. G(ind, :) является единичной матрицей. | ||

| Строка 151: | Строка 154: | ||

!''Алгоритм декодирования LDPC-кода в синдромном представлении'' | !''Алгоритм декодирования LDPC-кода в синдромном представлении'' | ||

|- | |- | ||

| - | |[e, status] = '''ldpc_decoding'''( | + | |[e, status] = '''ldpc_decoding'''(s, H, q, param_name1, param_value1, ...) |

|- | |- | ||

|ВХОД | |ВХОД | ||

| Строка 157: | Строка 160: | ||

| | | | ||

{|border="0" | {|border="0" | ||

| - | | | + | |s — наблюдаемый синдром, бинарный вектор-столбец длины m; |

|- | |- | ||

| - | |H — проверочная матрица чётности, бинарная матрица размера | + | |H — проверочная матрица чётности, бинарная матрица размера m x n; |

|- | |- | ||

|q — вероятность инверсии бита при передаче по каналу связи, число от 0 до 0.5; | |q — вероятность инверсии бита при передаче по каналу связи, число от 0 до 0.5; | ||

| Строка 167: | Строка 170: | ||

| | | | ||

{|border="0" | {|border="0" | ||

| + | |'schedule' — расписание пересчёта сообщений, возможные значения 'parallel' и 'sequential', по умолчанию = 'parallel'; | ||

| + | |- | ||

| + | |'damping' — коэффициент дэмпфирования при пересчёте сообщений, число от 0 до 1, по умолчанию = 1; | ||

| + | |- | ||

|'max_iter' — максимальное число итераций алгоритма декодирования, число, по умолчанию = 200; | |'max_iter' — максимальное число итераций алгоритма декодирования, число, по умолчанию = 200; | ||

|- | |- | ||

| - | |'eps' — порог стабилизации для | + | |'eps' — порог стабилизации для beliefs, число, по умолчанию = 1e-4; |

|- | |- | ||

|'display' — режим отображения, true или false, если true, то отображается промежуточная информация на итерациях, например, номер итерации, текущее число ошибок декодирования, невязка для сообщений и т.д. | |'display' — режим отображения, true или false, если true, то отображается промежуточная информация на итерациях, например, номер итерации, текущее число ошибок декодирования, невязка для сообщений и т.д. | ||

| Строка 180: | Строка 187: | ||

| | | | ||

{| | {| | ||

| - | |e — восстановленный вектор ошибок, бинарный вектор-столбец длины | + | |e — восстановленный вектор ошибок, бинарный вектор-столбец длины n; |

|- | |- | ||

| - | |status — результат декодирования, равен 0, если вектор e | + | |status — результат декодирования, равен 0, если найден вектор e, соответствующий входному синдрому s, равен 1, если произошла стабилизация значений beliefs, равен 2, если произошел выход по максимальному числу итераций. |

|} | |} | ||

|} | |} | ||

| Строка 191: | Строка 198: | ||

!''Оценка характеристик LDPC-кода с помощью метода Монте Карло'' | !''Оценка характеристик LDPC-кода с помощью метода Монте Карло'' | ||

|- | |- | ||

| - | |[err_bit, err_block, diver] = '''ldpc_mc'''(H | + | |[err_bit, err_block, diver] = '''ldpc_mc'''(H, q, num_points) |

|- | |- | ||

|ВХОД | |ВХОД | ||

| Строка 197: | Строка 204: | ||

| | | | ||

{|border="0" | {|border="0" | ||

| - | |H — проверочная матрица чётности, бинарная матрица размера | + | |H — проверочная матрица чётности, бинарная матрица размера m x n; |

| - | + | ||

| - | + | ||

|- | |- | ||

|q — вероятность инверсии бита при передаче по каналу связи, число от 0 до 0.5; | |q — вероятность инверсии бита при передаче по каналу связи, число от 0 до 0.5; | ||

| Строка 210: | Строка 215: | ||

| | | | ||

{| | {| | ||

| - | |err_bit — вероятность битовой ошибки декодирования (относительно | + | |err_bit — вероятность битовой ошибки декодирования (относительно n бит кодового слова), число от 0 до 1, вычисляется по тем ситуациям, когда алгоритм декодирования сошёлся (status < 2); |

|- | |- | ||

| - | |err_block — вероятность блоковой ошибки декодирования, число от 0 до 1 | + | |err_block — вероятность блоковой ошибки декодирования, число от 0 до 1, вычисляется по тем ситуациям, когда алгоритм декодирования сошёлся (status < 2) |

|- | |- | ||

|diver — доля ситуаций расходимости алгоритма декодирования, число от 0 до 1. | |diver — доля ситуаций расходимости алгоритма декодирования, число от 0 до 1. | ||

|} | |} | ||

|} | |} | ||

| + | |||

| + | [[Категория:Учебные задания]] | ||

| + | [[Категория:Байесовские методы]] | ||

Текущая версия

|

Начало выполнения задания: 5 марта 2014 г.

Срок сдачи: 18 марта 2014 г., 23:59.

Среда для выполнения задания — MATLAB.

Низкоплотностные коды

Задача помехоустойчивого кодирования

Рассмотрим решение задачи безошибочной передачи потока битовой информации по каналу с шумом с помощью кодов, исправляющих ошибки. При блоковом кодировании входящий поток информации разбивается на блоки фиксированной длины , и каждый блок кодируется/декодируется независимо. Обозначим один такой блок через

. Предположим, что во входном потоке данных, вообще говоря, нет избыточности. Поэтому для реализации схемы, способной исправлять ошибки, необходимо закодировать блок

в некоторое кодовое слово большей длины путем добавления избыточности в передаваемые данные. Обозначим кодовое слово через

,

. Для кодирования всевозможных блоков

необходимо использовать

кодовых слов длины

. Назовём множество

кодовых слов длины

(n,k)-блоковым кодом, а величину

— скоростью кода. При передаче по каналу с шумом кодовое слово

превращается в принятое слово

, которое, вообще говоря, отличается от

. Предположим, что при передаче по каналу длина сообщения не изменяется, т.е.

, а происходит лишь инверсия некоторых бит. Задача алгоритма декодирования состоит в восстановлении по

переданного слова

(например, путем поиска среди всевозможных кодовых слов ближайшего к

). Обозначим результат работы алгоритма декодирования через

. На последнем этапе декодированное слово

переводится в декодированное слово исходного сообщения

.

Кодирование с помощью (n,k)-линейного блокового кода

Множество с операциями суммы и произведения по модулю 2 образует линейное пространство над конечным полем из двух элементов

. (n,k)-блоковый код называется линейным, если множество его кодовых слов образует линейное подпространство размерности

общего линейного пространства

. Одним из способов задания

-мерного линейного подпространства является рассмотрение множества решений следующей системы линейных уравнений:

,

где — матрица ранга

(эта матрица задаёт базис линейного подпространства, ортогонального к рассматриваемому (n,k)-коду). Матрица

называется проверочной матрицей кода, т.к. с её помощью можно проверить, является ли слово

кодовым словом путём проверки соотношения

(здесь и далее все операции проводятся по модулю 2).

Рассмотрим задачу кодирования слов исходного сообщения в кодовые слова

(n,k)-линейного блокового кода, заданного своей проверочной матрицей

. Для этого можно найти базис

-мерного линейного подпространства

. Тогда, рассматривая базисные вектора как столбцы общей матрицы

, операция кодирования может быть представлена как

. Матрица

называется порождающей матрицей кода. Кодирование называется систематическим, если все биты слова

копируются в некоторые биты кодового слова

, т.е. в матрице

некоторое подмножество строк образует единичную матрицу размера

. При систематическом кодировании обратный процесс преобразования из декодированного кодового слова

в декодированное сообщение

становится тривиальным.

Одним из способов построения порождающей матрицы кода по заданной проверочной матрице является преобразование проверочной матрицы к каноническому ступенчатому виду. Такое преобразование всегда может быть сделано с помощью гауссовских исключений. С точностью до перестановки столбцов канонический ступенчатый вид матрицы эквивалентен её представлению в виде

, где

— единичная матрица размера

. Тогда в качестве порождающей матрицы, обеспечивающей систематическое кодирование, можно выбрать матрицу

.

Действительно, в этом случае .

Декодирование низкоплотностного кода

Низкоплотностным кодом (или кодом с малой плотностью проверок на чётность) называется бинарный (n,k)-линейный блоковый код, в котором проверочная матрица является сильно разреженной.

Рассмотрим бинарный симметричный канал для передачи данных. Здесь при передаче каждый бит независимо инвертируется с некоторой вероятностью . В результате бинарный симметричный канал задает распределение

для передаваемого кодового слова

и полученного на выходе слова

как

.

Пропускная способность данного канала определяется величиной .

Объединяя низкоплотностный код с бинарным симметричным каналом, получаем следующую вероятностную модель для пары :

.

Здесь — количество проверок на чётность,

— j-ая строка матрицы H, а

— индикаторная функция. Фактор-граф введённой модели показан на рис. справа.

Назовём синдромом принятого слова вектор

, определяемый как

. Процесс передачи кодового слова по бинарному симметричному каналу можно представить как

, где

— вектор ошибок (

, если в позиции

произошла ошибка). Тогда

. Далее можно перейти от вероятностной модели для переменных

к аналогичной для переменных

:

.

Здесь . Зная значение вектора ошибок

, результат декодирования вычисляется как

. При использовании вероятностной модели для

тестирование алгоритма декодирования можно проводить без предварительной реализации процедуры кодирования.

При использовании побитовой функции потерь оптимальная процедура декодирования связана с максимизацией маргиналов отдельных переменных, т.е.

. Для поиска маргинальных распределений

воспользуемся циклическим алгоритмом передачи сообщений (sum-product loopy BP) на фактор-графе. Введём обозначения

— множество факторов, в которых участвует переменная

, и

— множество переменных, которые входят в фактор

. Тогда общая схема алгоритма декодирования выглядит следующим образом:

1. Инициализация:

-

;

2. Пересчет сообщений от факторов:

-

;

3. Пересчет сообщений от переменных и вычисление beliefs (оценок на маргинальные распределения):

-

;

-

;

4. Оценка вектора ошибок:

-

;

5. Критерий остановки:

- Если

, то выход алгоритма со статусом 0;

- Если произошла стабилизация по всем

, то выход алгоритма со статусом 1;

- Если достигнуто максимальное число итераций, то выход алгоритма со статусом 2;

- Переход к шагу 2.

Оптимизации в процедуре декодирования

Пересчёт сообщений от факторов

При прямой реализации шага 2 общего алгоритма декодирования требуется рассмотрение для каждого фактора различных конфигураций значений переменных

. Это может приводить как к низкой скорости пересчета сообщений, так и к большим требованиям по памяти.

Рассмотрим более эффективную схему реализации шага 2. Пусть нам необходимо вычислить сообщение . Перенумеруем все переменные, входящие в j-ый фактор (кроме переменной

), как

, где

. Тогда вычисление сообщения

можно записать как

.

Данный результат можно интерпретировать как вычисление вероятности для набора независимых бинарных переменных

с распределением

Обозначим через

сумму первых

переменных

, т.е.

. Тогда распределение на

можно итерационно пересчитывать по формуле

.

В результате вычисление имеет линейную по

сложность.

Дальнейшее повышение эффективности реализации шага 2 связано с рассмотрением разностей вероятностей и

. Нетрудно показать, что

. (*)

Зная значение и учитывая условие нормировки

, сами вероятности могут быть вычислены как

,

. Таким образом,

. Основное преимущество условия (*) по сравнению с последовательным пересчётом распределений

связано с тем, что формула (*) может быть реализована с помощью векторных операций в MATLAB.

Расписание пересчёта сообщений и дэмпфирование

Общая схема циклического алгоритма передачи сообщений оставляет определённый произвол в выборе расписания пересчёта сообщений. Обычно здесь рассматриваются следующие подходы:

- Параллельное расписание. В данном случае сначала все вершины посылают сообщения во все факторы, а затем все факторы посылают сообщения во все вершины.

- Последовательное расписание. Здесь выбирается некоторый (например, случайный) порядок последовательного пересчёта всех сообщений (и от вершин к факторам, и от факторов к вершинам). При этом данный порядок может меняться от итерации к итерации.

При использовании дэмпфирования с параметром сообщения на итерации

пересчитываются как

;

.

Здесь и

— сообщения, вычисляемые на шагах 2 и 3 общего алгоритма декодирования.

Формулировка задания

- Реализовать алгоритм построения по заданной проверочной матрице чётности H порождающей матрицы кода G для систематического кодирования;

- Реализовать алгоритм декодирования низкоплотностного кода на основе loopy BP; при реализации шага 2 пересчета сообщений от факторов к переменным необходимо использовать эффективные схемы, обозначенные выше; реализовать последовательное и параллельное расписание пересчёта сообщений, а также дэмпфирование сообщений; при реализации на MATLAB одной итерации схемы передачи сообщений использование вложенных циклов является нежелательным;

- Провести эксперименты с различными расписаниями пересчёта сообщений и коэффициентами дэмпфирования; в частности, оценить долю стабилизировавшихся beliefs в зависимости от номера итерации алгоритма декодирования (усреднённую по различным запускам); оценить время работы алгоритма декодирования в зависимости от выбранного расписания и коэффициента дэмпфирования;

- Рассмотрим две характеристики качества кода — вероятность совершить ошибку хотя бы в одном бите при декодировании блока (

) и среднюю вероятность совершить ошибку при декодировании в одном бите (

). Требуется реализовать алгоритм оценки вероятности битовой и блоковой ошибки кода с помощью метода стат. испытаний (многократная случайная генерация вектора ошибок

(

с вероятностью

), вычисление по нему синдрома

, восстановление вектора ошибок

с помощью алгоритма декодирования и подсчет необходимых характеристик);

- Провести эксперименты по оцениванию битовой и блоковой ошибки низкоплотностного кода для различных значений длины кодового слова

, скорости кода

, вероятности инвертирования бита при передаче по каналу связи

и среднего количества единиц в столбце проверочной матрицы

. В частности, необходимо проанализировать следующие ситуации:

- Теорема Шеннона определяет пропускную способность канала как максимально допустимую скорость кода, при которой возможно осуществление надежной коммуникации. Требуется проверить, как меняются характеристики кода при изменении скорости

от минимального значения до пропускной способности канала.

- Теорема Шеннона предполагает, что качество кода растет при увеличении длины кодового слова

. Требуется проверить это предположение.

- Одно из следствий теоремы Шеннона утверждает, что хорошими кодами являются коды со случайной проверочной матрицей H. В частности, здесь предполагается, что качество кода должно расти при увеличении среднего количества единиц в столбце проверочной матрицы

. Требуется проверить это утверждение для низкоплотностных кодов (путём рассмотрения нескольких значений

, начиная от 3).

- Теорема Шеннона определяет пропускную способность канала как максимально допустимую скорость кода, при которой возможно осуществление надежной коммуникации. Требуется проверить, как меняются характеристики кода при изменении скорости

- Провести эксперименты по сравнению низкоплотностного кода с кодами БЧХ; в частности, провести эксперименты для различных

при фиксированной скорости кода

, а также для различных

при фиксированной

;

- Составить отчёт в формате PDF с описанием всех проведённых исследований.

Рекомендации по выполнению задания

1. Разреженную проверочную матрицу кода заданных размеров можно строить с помощью случайной генерации (с соблюдением условия полноранговости). Однако, здесь рекомендуется воспользоваться готовой реализацией, которая генерирует проверочную матрицу заданного размера с заданным количеством единиц в каждом столбце. При этом реализованный алгоритм старается сократить количество циклов длины 4 в генерируемой матрице, т.к. наличие коротких циклов в графе, как правило, усложняет работу алгоритма loopy BP.

2. При тестировании алгоритма декодирования рекомендуется пробовать запускать итерационный процесс из различных начальных приближений для сообщений (не только из значений унарных потенциалов). При корректной реализации метода должна наблюдаться сходимость к одним и тем же финальным сообщениям независимо от начальных приближений.

Оформление задания

Выполненное задание следует отправить письмом по адресу bayesml@gmail.com с заголовком письма «[ГМ14] Задание 2 <ФИО>». Убедительная просьба присылать выполненное задание только один раз с окончательным вариантом. Также убедительная просьба строго придерживаться заданных ниже прототипов реализуемых функций.

Присланный вариант задания должен содержать в себе:

- Файл отчёта в формате PDF с указанием ФИО.

- Все исходные коды с необходимыми комментариями.

| Построение порождающей матрицы для систематического кодирования | ||

|---|---|---|

| [G, ind] = ldpc_gen_matrix(H) | ||

| ВХОД | ||

| ||

| ВЫХОД | ||

|

| Алгоритм декодирования LDPC-кода в синдромном представлении | ||||||||||

|---|---|---|---|---|---|---|---|---|---|---|

| [e, status] = ldpc_decoding(s, H, q, param_name1, param_value1, ...) | ||||||||||

| ВХОД | ||||||||||

| ||||||||||

| ВЫХОД | ||||||||||

|

| Оценка характеристик LDPC-кода с помощью метода Монте Карло | |||

|---|---|---|---|

| [err_bit, err_block, diver] = ldpc_mc(H, q, num_points) | |||

| ВХОД | |||

| |||

| ВЫХОД | |||

|