Использование технологий NVIDIA для решения задач глубокого обучения

Материал из MachineLearning.

| Строка 1: | Строка 1: | ||

Ниже приведен обзор методов построения сетей глубокого обучения на графических ускорителях. Решаются задачи машинного обучения: распознавания образов, речи, классификация сигналов. Для решения задач используются программные пакеты Torch, Theano, Caffe, cuDNN, предназначенные для работы с графическими ускорителями NVIDIA. Сравнивается работа ускорителей, Tesla X и [наш], на серверах mvr.jmlda.org и Amazon S3. | Ниже приведен обзор методов построения сетей глубокого обучения на графических ускорителях. Решаются задачи машинного обучения: распознавания образов, речи, классификация сигналов. Для решения задач используются программные пакеты Torch, Theano, Caffe, cuDNN, предназначенные для работы с графическими ускорителями NVIDIA. Сравнивается работа ускорителей, Tesla X и [наш], на серверах mvr.jmlda.org и Amazon S3. | ||

| + | |||

| + | Глубокое обучение – быстро развивающийся сегмент области знания, связанной с искусственным интеллектом, - является катализатором развития самых разных отраслей, начиная от медицины и фармакологии и заканчивая автопилотируемыми автомобилями. Глубокое обучение (глубокое структурное обучение, или иерархическое обучение) -- это область машинного обучения, заключающаяся в построении нелинейной модели распознавания, каждый элемент которой описывает соответствующий уровень признакового агрегирования данных. | ||

| + | |||

| + | На конференции "GPU Technology Conference" [http://www.gputechconf.com/] в 2015 г. генеральным директором NVIDIA Дженсоном Хуангом было представлено три новые технологии, которые используются для развития области глубокого обучения: TITAN X, DIGITS и DIGITS DevBox. | ||

| + | |||

| + | === NVIDIA GeForce GTX TITAN X === | ||

| + | TITAN X [http://www.nvidia.ru/object/geforce-gtx-titan-x-ru.html] – графический процессор для быстрого обучения глубоких нейронных сетей. Построенный на графической архитектуре NVIDIA Maxwell, TITAN X обладает вдвое большей производительностью и энергоэффективностью по сравнению с предшественником. TITAN X – это 12ГБ памяти и 3072 ядра, которые обеспечивают 7 терафлопс в вычислениях одинарной точности. Благодаря производительности и полосе пропускания памяти 336.5 ГБ/с, ускоритель рекомендуется использовать для построения сетей глубокого обучения с числом параметров до сотен миллионов. В частности, для обучения сети AlexNet [http://www.cs.toronto.edu/~fritz/absps/imagenet.pdf] с помощью набора из 1.2 миллиона изображений ImageNet TITAN X понадобилось менее трех дней, тогда как 16-ядерный CPU справляется с этой задачей за 40 дней. | ||

| + | |||

| + | === DIGITS Deep Learning GPU Training System === | ||

| + | DIGITS [https://developer.nvidia.com/digits] – программное обеспечение, предназначенное для выполнения исследовательских работ по построению и конфигурации глубоких нейронных сетей. Интуитивно понятный пользовательский интерфейс и возможности управления DIGITS обеспечивают подготовку обучающих наборов данных локально и из сети. | ||

| + | |||

| + | === DIGITS DevBox === | ||

| + | [[Изображение:Nvidia_box.png|thumb]] | ||

| + | |||

| + | DIGITS DevBox [https://developer.nvidia.com/devbox] – специализированная рабочая станция для работы с задачами глубокого обучения, построенная на базе четырех TITAN X GPU, поставляемое с предустановленной системой обучения DIGITS. Система DIGITS DevBox является ядром комплексной платформы для ускорения исследований глубокого обучения. DevBox состоит из четырех карт GPU TITAN X, памяти и интерфейсов. Система поставляется с предустановленным программным обеспечением, которое необходимо ученым и исследователей для создания собственных глубоких нейронных сетей. В список приложений входят пакет программ DIGITS, самые популярные платформы глубокого обучения Caffe, Theano и Torch, а также cuDNN 2.0 – GPU-ускоренная библиотека для задач глубокого обучения от NVIDIA [https://developer.nvidia.com/cuDNN]. Первые результаты многопроцессорного обучения показывают, что DIGITS DevBox обеспечивает производительность почти в четыре раза выше по сравнению с одним TITAN X в тестах глубокого обучения. С помощью DIGITS DevBox обучить сеть AlexNet можно всего за 13 часов, тогда как обычному ПК на базе самого быстрого GPU потребовалось бы более двух суток, а системе на базе CPU - больше месяца. | ||

| + | |||

| + | Система DIGITS DevBox состоит из следующих компонентов. | ||

| + | * Четыре TITAN X GPU, обеспечивающие 7 тетрафлопс в ординарной точности, 12 Гб памяти и 336.5 Гб/с полосы пропускания памяти. В комплект DIGITS DevBox входят до четырех GPUs, до 64 GB DDR4, материнская плата ASUS X99 (8 PCIe slots) + Core i7, 2 x 48 port gen3 PCIe (PEX8748) + CPU for PCIe, накопитель, до 3x3 TB RAID 5 + M2 SATA + SSD, блок питания 1500W, операционная система Ubuntu 14.04, драйвера, NVIDIA® CUDA® Toolkit 7.0. | ||

| + | * Программное обеспечение NVIDIA DIGITS, предоставляющее интерфейсы для обучения и визуализации нейронных сетей для классификации изображений. | ||

| + | * Система Ubuntu 14.04 с предустановленными Caffe, Torch, Theano, BIDMach, cuDNN v2, and CUDA 7.0. | ||

| + | |||

| + | == С чего начать == | ||

| + | [[Изображение:Caffe_theano_screenshot.png|thumb]] | ||

| + | [[Изображение:Theano_console_screenshot.png|thumb]] | ||

| + | |||

| + | # Посмотреть вебинар по сверточным нейронным сетям [http://on-demand.gputechconf.com/gtc/2014/webinar/gtc-express-convolutional-networks-webinar.mp4] и Caffe для глубокого обучения [http://on-demand.gputechconf.com/gtc/2014/webinar/gtc-express-deep-learning-caffee-evan-shelhamer.mp4]. | ||

| + | # Установить фреймворк по выбору: Caffe, Torch или Theano. | ||

| + | # Загрузить и установить cuDNN [https://developer.nvidia.com/cuDNN], ускоренную на GPU библиотеку NVIDIA, содержащую примитивы для глубоких нейронных сетей. | ||

| + | |||

| + | == Первая программа на CUDA == | ||

| + | Чтобы написать первую программу на CUDA, надо установить: | ||

| + | # Microsoft Visual Studio (на MVR стоит версия Professional 2012), | ||

| + | # CUDA SDK (на MVR стоит версия 7.0) [https://developer.nvidia.com/cuda-downloads]. | ||

| + | После установки SDK стоит посмотреть полезные примеры от NVIDIA, которые по умолчанию распаковываются в C:\ProgramData\NVIDIA Corporation\CUDA Samples\v7.0. | ||

| + | Кроме того, появится возможность компилировать .cu файлы командой nvcc из командной строки, например, | ||

| + | <source lang="bash"> | ||

| + | nvcc -ptx myfun.cu | ||

| + | </source> | ||

| + | Это нужно, например, для того, чтобы использовать CudaKernel в Matlab для запуска своих CUDA-функций, см. [http://www.mathworks.com/help/distcomp/run-cuda-or-ptx-code-on-gpu.html]. | ||

| + | |||

| + | Руководство по установке Caffe на Windows: [https://initialneil.wordpress.com/2015/01/11/build-caffe-in-windows-with-visual-studio-2013-cuda-6-5-opencv-2-4-9/]. | ||

| + | Highlights: нужно поставить и прописать зависимости для OpenCV, Boost, OpenBLAS, GFlags, GLog, ProtoBuf, LevelDB, HDF5, LMDB. Кроме того, для облегчения процесса сборки понадобится установить [http://www.cmake.org/ CMake]. | ||

| + | |||

| + | Руководство по установке Theano на Windows: [http://deeplearning.net/software/theano/install.html#windows]. | ||

| + | |||

| + | |||

| + | == Работа с Theano на Amazon Web Services == | ||

| + | При отсутствии устройства GPU на локальной машине можно воспользоваться платным удаленным фреймворком, например, Amazon Web Services [http://aws.amazon.com/]. | ||

| + | |||

| + | Подробные инструкции по инициализации удаленных вычислений на GPU, а также по удаленному использованию библиотек глубокого обучения можно прочитать в [https://www.kaggle.com/c/facial-keypoints-detection/details/deep-learning-tutorial], [http://markus.com/install-theano-on-aws], [http://deeplearning.net/tutorial/mlp.html#nonlinearity]. | ||

| + | |||

| + | == Список библиотек высокого уровня для работы с GPU == | ||

| + | |||

| + | * [http://caffe.berkeleyvision.org/ Caffe: Framework for convolutional neural network algorithms] | ||

| + | * [https://github.com/dnouri/cuda-convnet cuda-convnet: High performance C++/CUDA implementation of convolutional neural networks] | ||

| + | * [http://deeplearning.net/software/theano/ Theano: Python library to define, optimize, and evaluate mathematical expressions] | ||

| + | * [http://torch.ch/ Torch7: Scientific computing framework for machine learning algorithms] | ||

| + | * [https://developer.nvidia.com/cuBLAS cuBLAS: GPU-accelerated version of the complete standard BLAS library] | ||

| + | * [http://www.mathworks.com/discovery/matlab-gpu.html MATLAB: Easy-to-use HPC language integrating computation, visualization, and programming cxxnet: Neural network toolkit] | ||

| + | * [http://developer.download.nvidia.com/compute/cuda/6_5/rel/docs/CUDA_6.5_Performance_Report.pdf Отчет о производительности CUDA 6.5 и библиотек] | ||

== Matlab Parallel Computing Toolbox == | == Matlab Parallel Computing Toolbox == | ||

Версия 17:53, 21 апреля 2015

Ниже приведен обзор методов построения сетей глубокого обучения на графических ускорителях. Решаются задачи машинного обучения: распознавания образов, речи, классификация сигналов. Для решения задач используются программные пакеты Torch, Theano, Caffe, cuDNN, предназначенные для работы с графическими ускорителями NVIDIA. Сравнивается работа ускорителей, Tesla X и [наш], на серверах mvr.jmlda.org и Amazon S3.

Глубокое обучение – быстро развивающийся сегмент области знания, связанной с искусственным интеллектом, - является катализатором развития самых разных отраслей, начиная от медицины и фармакологии и заканчивая автопилотируемыми автомобилями. Глубокое обучение (глубокое структурное обучение, или иерархическое обучение) -- это область машинного обучения, заключающаяся в построении нелинейной модели распознавания, каждый элемент которой описывает соответствующий уровень признакового агрегирования данных.

На конференции "GPU Technology Conference" [1] в 2015 г. генеральным директором NVIDIA Дженсоном Хуангом было представлено три новые технологии, которые используются для развития области глубокого обучения: TITAN X, DIGITS и DIGITS DevBox.

Содержание |

NVIDIA GeForce GTX TITAN X

TITAN X [2] – графический процессор для быстрого обучения глубоких нейронных сетей. Построенный на графической архитектуре NVIDIA Maxwell, TITAN X обладает вдвое большей производительностью и энергоэффективностью по сравнению с предшественником. TITAN X – это 12ГБ памяти и 3072 ядра, которые обеспечивают 7 терафлопс в вычислениях одинарной точности. Благодаря производительности и полосе пропускания памяти 336.5 ГБ/с, ускоритель рекомендуется использовать для построения сетей глубокого обучения с числом параметров до сотен миллионов. В частности, для обучения сети AlexNet [3] с помощью набора из 1.2 миллиона изображений ImageNet TITAN X понадобилось менее трех дней, тогда как 16-ядерный CPU справляется с этой задачей за 40 дней.

DIGITS Deep Learning GPU Training System

DIGITS [4] – программное обеспечение, предназначенное для выполнения исследовательских работ по построению и конфигурации глубоких нейронных сетей. Интуитивно понятный пользовательский интерфейс и возможности управления DIGITS обеспечивают подготовку обучающих наборов данных локально и из сети.

DIGITS DevBox

DIGITS DevBox [5] – специализированная рабочая станция для работы с задачами глубокого обучения, построенная на базе четырех TITAN X GPU, поставляемое с предустановленной системой обучения DIGITS. Система DIGITS DevBox является ядром комплексной платформы для ускорения исследований глубокого обучения. DevBox состоит из четырех карт GPU TITAN X, памяти и интерфейсов. Система поставляется с предустановленным программным обеспечением, которое необходимо ученым и исследователей для создания собственных глубоких нейронных сетей. В список приложений входят пакет программ DIGITS, самые популярные платформы глубокого обучения Caffe, Theano и Torch, а также cuDNN 2.0 – GPU-ускоренная библиотека для задач глубокого обучения от NVIDIA [6]. Первые результаты многопроцессорного обучения показывают, что DIGITS DevBox обеспечивает производительность почти в четыре раза выше по сравнению с одним TITAN X в тестах глубокого обучения. С помощью DIGITS DevBox обучить сеть AlexNet можно всего за 13 часов, тогда как обычному ПК на базе самого быстрого GPU потребовалось бы более двух суток, а системе на базе CPU - больше месяца.

Система DIGITS DevBox состоит из следующих компонентов.

- Четыре TITAN X GPU, обеспечивающие 7 тетрафлопс в ординарной точности, 12 Гб памяти и 336.5 Гб/с полосы пропускания памяти. В комплект DIGITS DevBox входят до четырех GPUs, до 64 GB DDR4, материнская плата ASUS X99 (8 PCIe slots) + Core i7, 2 x 48 port gen3 PCIe (PEX8748) + CPU for PCIe, накопитель, до 3x3 TB RAID 5 + M2 SATA + SSD, блок питания 1500W, операционная система Ubuntu 14.04, драйвера, NVIDIA® CUDA® Toolkit 7.0.

- Программное обеспечение NVIDIA DIGITS, предоставляющее интерфейсы для обучения и визуализации нейронных сетей для классификации изображений.

- Система Ubuntu 14.04 с предустановленными Caffe, Torch, Theano, BIDMach, cuDNN v2, and CUDA 7.0.

С чего начать

- Посмотреть вебинар по сверточным нейронным сетям [7] и Caffe для глубокого обучения [8].

- Установить фреймворк по выбору: Caffe, Torch или Theano.

- Загрузить и установить cuDNN [9], ускоренную на GPU библиотеку NVIDIA, содержащую примитивы для глубоких нейронных сетей.

Первая программа на CUDA

Чтобы написать первую программу на CUDA, надо установить:

- Microsoft Visual Studio (на MVR стоит версия Professional 2012),

- CUDA SDK (на MVR стоит версия 7.0) [10].

После установки SDK стоит посмотреть полезные примеры от NVIDIA, которые по умолчанию распаковываются в C:\ProgramData\NVIDIA Corporation\CUDA Samples\v7.0. Кроме того, появится возможность компилировать .cu файлы командой nvcc из командной строки, например,

nvcc -ptx myfun.cu

Это нужно, например, для того, чтобы использовать CudaKernel в Matlab для запуска своих CUDA-функций, см. [11].

Руководство по установке Caffe на Windows: [12]. Highlights: нужно поставить и прописать зависимости для OpenCV, Boost, OpenBLAS, GFlags, GLog, ProtoBuf, LevelDB, HDF5, LMDB. Кроме того, для облегчения процесса сборки понадобится установить CMake.

Руководство по установке Theano на Windows: [13].

Работа с Theano на Amazon Web Services

При отсутствии устройства GPU на локальной машине можно воспользоваться платным удаленным фреймворком, например, Amazon Web Services [14].

Подробные инструкции по инициализации удаленных вычислений на GPU, а также по удаленному использованию библиотек глубокого обучения можно прочитать в [15], [16], [17].

Список библиотек высокого уровня для работы с GPU

- Caffe: Framework for convolutional neural network algorithms

- cuda-convnet: High performance C++/CUDA implementation of convolutional neural networks

- Theano: Python library to define, optimize, and evaluate mathematical expressions

- Torch7: Scientific computing framework for machine learning algorithms

- cuBLAS: GPU-accelerated version of the complete standard BLAS library

- MATLAB: Easy-to-use HPC language integrating computation, visualization, and programming cxxnet: Neural network toolkit

- Отчет о производительности CUDA 6.5 и библиотек

Matlab Parallel Computing Toolbox

| | Статья наполняется. Категория: Инструменты и технологии. --Strijov 15:57, 20 апреля 2015 (MSD) |

Запуск функций CUDA в Matlab

Parallel Computing Toolbox в Matlab предоставляет фреймворк для вычислений на GPU.

Для того, чтобы разместить структуру данных Matlab (массив или матрицу численного типа) в памяти GPU, используется функция gpuArray(). Вызов этой функции создает объект Matlab в памяти GPU:

N = 6; M = magic(N); G = gpuArray(M);

Для того, чтобы вернуть массив из памяти GPU в Matlab workspace, используется функция gather():

G = gpuArray(ones(100,'uint32')); D = gather(G);

Для работы со структурами данных gpuArray в Matlab предусмотрено несколько вариантов. Одним из вариантов (наиболее низкоуровневом) является запуск предварительно скомпилированной функции ядра CUDA с расширением .cu. Для запуска функции в Matlab необходимо создать объект CUDAKernel и выполнить следующую последовательность действий:

1. Скомпилировать файл с расширением .ptx для функции ядра myfun.cu с помощью, например, компилятора nvcc в NVIDIA CUDA Toolkit:

nvcc -ptx myfun.cu

2. Создать объект CUDAKernel с аргументами .ptx, .cu:

k = parallel.gpu.CUDAKernel('myfun.ptx','myfun.cu');

3. Присвоить объекту CUDAKernel параметры, необходимые для выполнения на GPU:

k.GridSize = [8 1]; k.ThreadBlockSize = [16 1];

4. Вызвать функцию feval для выполнения CUDAKernel:

g1 = gpuArray(in1); % Input gpuArray. g2 = gpuArray(in2); % Input gpuArray. result = feval(k,g1,g2);

Функции Matlab с реализацией под GpuArray

Помимо запуска функций, написанных на CUDA, в Matlab реализована перегрузка некоторых встроенных функций, принимающих в качестве аргумента массив в памяти GPU gpuArray. Их полный список приведен в [18]. В частности, для работы с gpuArray реализованы следующие функции, выполняющие простейшие алгебраические и статистические операции:

conv, eig, fft, filter, median, mean, rand, std, svd, inv, pinv

Реализация этих функций позволяет работать напрямую с массивами GpuArray:

Ga = rand(1000,'single','gpuArray'); Gfft = fft(Ga); Gb = (real(Gfft) + Ga) * 6; G = gather(Gb);

Однако список этих функций и, как следствие, его применимость в реальных задачах, является крайне ограниченным.

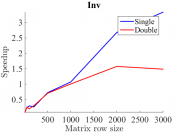

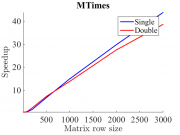

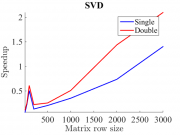

На рис. 1-3 показаны примеры тестирования некоторых встроенных Matlab-функций на GPU. Тестирование производилось на видеокарте GeForce GTX 660 Ti. Приведены примеры тестирования функций обращения матрицы, умножения двух матриц и сингулярного разложения матрицы. По оси абсцисс каждого графика отложен строковый размер матрицы, по оси ординат - скорость выполнения по сравнению с GPU. Синей линией проиллюстрированы результаты для типа данных single, красной -- для типа данных double. Видно, что для алгоритма с простой параллелизацией (MTimes) ускорение достигает порядка 40X на данных большого объема. В то же время для алгоритмов с плохой паралеллизацией (inv, svd) ускорение достигает лишь порядка 1X-2X. Кроме того, замечено, что для типа данных single ускорение в среднем больше.

Реализация arrayFun для массива в памяти GPU

Помимо встроенных функций алгебраических вычислений для работы с массивами gpuArray в Matlab реализовано выполнение функций arrayfun и bsxfun. Выполнение этих функций аналогично выполнению соответствующих функций arrayfun и bsxfun, но происходит с использованием памяти GPU. Эта возможность позволяет вычислять на GPU функции Matlab, написанные разработчиком для поэлементных операций над массивом или матрицей.

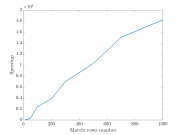

В качестве примера продемонстрируем вычисление матрицы парных евклидовых расстояний между набором точек. Размерность евклидова пространства во всех случаях .

Функция, поступающая в качестве первого аргумента для arrayfun - поэлементная функция расстояния между двумя координатами точек:

distfun = @(a, b) ((a - b) ^ 2);

Результат выполнения функции arrayfun на CPU и GPU показан на рис. 4. Видно, что достигаемое ускорение для "наивного" вычисления расстояний составляет десятки тысяч.

Несмотря на хорошие результаты исследования, существует ряд ограничений на поэлементную функцию при работе с arrayfun на GPU, что делает применение этой функциональности достаточно узким. Наиболее полный список этих ограничений приведен в [19]. Ниже приведен список основных ограничений.

- Внутри поэлементной функции запрещено использовать операции изменения формы входного или выходного массивов (cat, reshape etc.). Это связано с тем, что массивы размещаются в памяти GPU.

- Функции arrayfun и bsxfun не могут обращаться к переменным вне области видимости, а также к переменным, которые были созданы до начала вычисления функции на GPU. Это ограничение делает невозможным вычисление функции расстояния произвольного вида. Возможным оказывается считать только те расстояния, которые могут быть вычислены независимо по координатам (например, евклидово).

- Поэлементные анонимные функции не имеют доступа к области видимости их родительского окружения.