Математические основы теории прогнозирования (курс лекций)/2012/Задание СФ

Материал из MachineLearning.

(→Рекомендации по выполнению задания) |

|||

| (30 промежуточных версий не показаны.) | |||

| Строка 1: | Строка 1: | ||

| - | |||

| - | |||

{{TOCright|300px}} | {{TOCright|300px}} | ||

| Строка 7: | Строка 5: | ||

'''Срок сдачи задания''': {{ins|30 августа 2012, 23:59}} | '''Срок сдачи задания''': {{ins|30 августа 2012, 23:59}} | ||

| - | Данное практическое задание предназначено, в первую очередь, для студентов Севастопольского филиала, которые имеют задолженность по курсу [[МОТП]] и не имеют возможности присутствовать в Москве на пересдачах осенью. Тем не менее, это задание могут выполнять и московские студенты ВМиК, которые имеют задолженность по курсу МОТП. Оценка за это задание будет итоговой оценкой по курсу | + | Данное практическое задание предназначено, в первую очередь, для студентов Севастопольского филиала, которые имеют задолженность по курсу [[МОТП]] и не имеют возможности присутствовать в Москве на пересдачах осенью. Тем не менее, это задание могут выполнять и московские студенты ВМиК, которые имеют задолженность по курсу МОТП. Оценка за это задание будет итоговой оценкой по курсу. |

| + | |||

| + | Цель данного задания состоит в том, чтобы студенты познакомились на практике с популярными методами решения задач классификации и кластеризации — [[Машина опорных векторов|методом опорных векторов]] и методом к-средних, а также с базовыми аспектами, с которыми приходится сталкиваться при решении задач машинного обучения — проблемой переобучения и проблемой подбора структурных параметров алгоритма (таких как коэффициент С и параметры ядровых функций). | ||

| + | |||

| + | Задание выполняется в среде [[MATLAB]]. | ||

| - | + | Вопросы по заданию можно оставлять на вкладке «обсуждение» к этой странице, либо адресовать письмом на ''bayesml@gmail.com''. В название письма просьба добавлять [МОТП12]. | |

== Необходимая теория == | == Необходимая теория == | ||

| - | === | + | === Метод опорных векторов === |

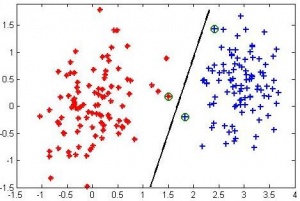

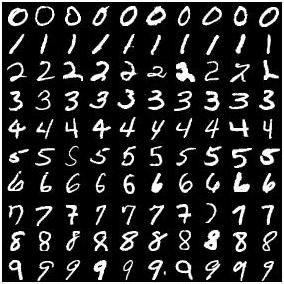

[[Изображение:MOTP12_svm_linear.jpg|300px|thumb|Иллюстрация линейного разделения выборки с помощью метода опорных векторов, зелеными кружками отмечены опорные объекты]] | [[Изображение:MOTP12_svm_linear.jpg|300px|thumb|Иллюстрация линейного разделения выборки с помощью метода опорных векторов, зелеными кружками отмечены опорные объекты]] | ||

Рассматривается задача классификации на два класса. Имеется обучающая выборка <tex>\{\vec{x}_n,t_n\}_{n=1}^N</tex>, где <tex>\vec{x}_n\in\mathbb{R}^d</tex> — вектор признаков для объекта <tex>n</tex>, а <tex>t_n\in\{-1,+1\}</tex> — его метка класса. Задача заключается в предсказании метки класса <tex>t_{new}</tex> для объекта, представленного своим вектором признаков <tex>\vec{x}_{new}</tex>. | Рассматривается задача классификации на два класса. Имеется обучающая выборка <tex>\{\vec{x}_n,t_n\}_{n=1}^N</tex>, где <tex>\vec{x}_n\in\mathbb{R}^d</tex> — вектор признаков для объекта <tex>n</tex>, а <tex>t_n\in\{-1,+1\}</tex> — его метка класса. Задача заключается в предсказании метки класса <tex>t_{new}</tex> для объекта, представленного своим вектором признаков <tex>\vec{x}_{new}</tex>. | ||

| Строка 29: | Строка 31: | ||

<tex>0\le\lambda_n\le C.</tex> | <tex>0\le\lambda_n\le C.</tex> | ||

| - | Здесь <tex>C>0</tex> — параметр алгоритма, который задает компромисс между точностью распознавания обучающей выборки и величиной зазора между данными и гиперплоскостью. | + | Здесь <tex>C>0</tex> — параметр алгоритма, который задает компромисс между точностью распознавания обучающей выборки и величиной зазора между данными и гиперплоскостью (надежностью классификации). |

После решения задачи квадратичного программирования оптимальный вектор весов вычисляется как | После решения задачи квадратичного программирования оптимальный вектор весов вычисляется как | ||

| Строка 35: | Строка 37: | ||

<tex>\vec{w} = \sum_{n=1}^N\lambda_nt_n\vec{x}_n</tex>. | <tex>\vec{w} = \sum_{n=1}^N\lambda_nt_n\vec{x}_n</tex>. | ||

| - | Очевидно, что только те объекты обучающей выборки, для которых <tex>\lambda_n\neq 0</tex>, влияют на оптимальный вектор весов. Такие объекты получили название ''опорных''. Пусть <tex>\exist | + | Очевидно, что только те объекты обучающей выборки, для которых <tex>\lambda_n\neq 0</tex>, влияют на оптимальный вектор весов. Такие объекты получили название ''опорных''. Пусть <tex>\exist n_*:\ 0<\lambda_{n_*}<C</tex>. Тогда оптимальная величина сдвига гиперплоскости <tex>b</tex> определяется как |

| - | <tex>b = | + | <tex>b = t_{n_*} - \vec{w}^T\vec{x}_{n_*}</tex>. |

На практике здесь лучше проводить усреднение по всем <tex>n:\ 0<\lambda_n<C</tex>. Если в оптимальном <tex>\vec{\lambda}</tex> все коэффициенты равны только нулю и <tex>C</tex>, то тогда коэффициент <tex>b</tex> может быть найден перебором путем минимизации ошибки распознавания обучающей выборки. | На практике здесь лучше проводить усреднение по всем <tex>n:\ 0<\lambda_n<C</tex>. Если в оптимальном <tex>\vec{\lambda}</tex> все коэффициенты равны только нулю и <tex>C</tex>, то тогда коэффициент <tex>b</tex> может быть найден перебором путем минимизации ошибки распознавания обучающей выборки. | ||

=== Использование ядровых функций === | === Использование ядровых функций === | ||

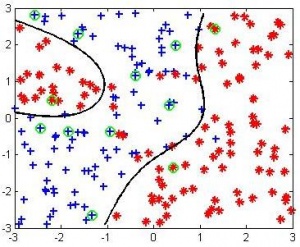

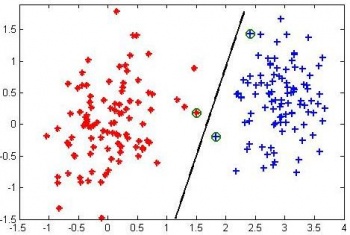

| - | [[Изображение:MOTP12_svm_rbf.jpg|300px|thumb|Иллюстрация нелинейного разделения выборки с помощью метода опорных векторов с | + | [[Изображение:MOTP12_svm_rbf.jpg|300px|thumb|Иллюстрация нелинейного разделения выборки с помощью метода опорных векторов с радиальной ядровой функцией, зелеными кружками отмечены опорные объекты]] |

| - | + | Для построения нелинейных решающих правил с помощью метода опорных векторов вводится понятие ядровой функции. Пусть имеется преобразование из исходного признакового пространства <tex>\mathbb{R}^d</tex> в новое пространство <tex>H</tex>, задаваемое функцией <tex>\phi:\mathbb{R}^d\rightarrow H</tex>. Пусть также имеется ядровая функция <tex>K</tex>, которая задает скалярное произведение в новом пространстве <tex>H</tex>: | |

| - | + | <tex>K(\vec{x},\vec{y}) = \phi(\vec{x})^T\phi(\vec{y}),\ \forall\vec{x},\vec{y}.</tex> | |

| - | <tex> | + | Тогда для построения линейной разделяющей гиперплоскости в новом пространстве <tex>H</tex> достаточно знать лишь ядровую функцию <tex>K</tex> и не требуется знать само преобразование <tex>\phi</tex>. В этом случае на этапе обучения метода решается следующая задача квадратичного программирования: |

| - | + | <tex>\sum_{n=1}^N\lambda_n - \frac{1}{2}\sum_{n,m=1}^N\lambda_n\lambda_mt_nt_mK(\vec{x}_n,\vec{x}_m)\rightarrow\max_{\vec{\lambda}},</tex> | |

| - | <tex> | + | <tex>\sum_n\lambda_nt_n = 0,</tex> |

| - | + | <tex>0\le \lambda_n\le C.</tex> | |

| + | |||

| + | При этом скалярное произведение оптимального вектора весов <tex>\vec{w}</tex> и произвольного объекта <tex>\vec{x}</tex> определяется как | ||

| + | |||

| + | <tex>\vec{w}^T\vec{x} = \sum_{n=1}^N\lambda_nt_nK(\vec{x}_n,\vec{x}).</tex> | ||

| + | |||

| + | По-прежнему, только опорные объекты (для которых <tex>\lambda_n\neq 0</tex>) вносят вклад в значение данного скалярного произведения. Величина сдвига гиперплоскости, как и раньше, определяется как | ||

| + | |||

| + | <tex>b = \frac{\sum_{n:0<\lambda_n<C}(t_n - \vec{w}^T\vec{x}_n)}{\sum_{n:0<\lambda_n<C}1}.</tex> | ||

| + | |||

| + | Если все коэффициенты <tex>\lambda_n</tex> принимают только крайние значения, то оптимальный сдвиг <tex>b</tex> находится путем минимизации числа ошибок на обучающей выборке. | ||

| + | |||

| + | Ядровая функция, как правило, выбирается в одном из следующих параметрических семейств: | ||

| + | # ''Линейная'': <tex>K(\vec{x},\vec{y}) = \vec{x}^T\vec{y}</tex>, | ||

| + | # ''Степенная'': <tex>K(\vec{x},\vec{y}) = (\vec{x}^T\vec{y}+1)^r,\ r\in\mathbb{N}</tex>. | ||

| + | # ''Радиальная'': <tex>K(\vec{x},\vec{y}) = \exp\left(-\frac{||\vec{x}-\vec{y}||^2}{2\gamma^2}\right),\ \gamma>0</tex>. | ||

| + | |||

| + | В случае степенной ядровой функции делается неявное предположение о том, что данные отнормированы на нулевой центр и единичную дисперсию. В этом случае, по неравенству Коши-Буняковского, величина <tex>\vec{x}^T\vec{y}+1</tex> всегда будет неотрицательной. | ||

=== Скользящий контроль === | === Скользящий контроль === | ||

| - | В | + | В методе опорных векторов параметр регуляризации <tex>C</tex>, а также параметры ядровых функций (например, параметр <tex>\gamma</tex> в радиальной ядровой функции) являются структурными параметрами, которые |

| - | не могут быть настроены путем минимизации | + | не могут быть настроены путем минимизации числа ошибок на обучающей выборке. Для их настройки используются ''критерии выбора модели'', например, [[Скользящий контроль|скользящий контроль]]. |

| - | Обозначим обучающую выборку через <tex>Y=(X,\vec{t})</tex>, а через <tex>a(\vec{x},Y)</tex> результат прогноза | + | Обозначим обучающую выборку через <tex>Y=(X,\vec{t})</tex>, а через <tex>a(\vec{x},Y)</tex> — результат прогноза метки класса для объекта <tex>\vec{x}</tex>, полученный с помощью алгоритма <tex>a</tex>, обученного по выборке <tex>Y</tex>. |

При <tex>K</tex>-кратном скользящем контроле обучающая выборка <tex>Y</tex> разбивается на <tex>K</tex> равных частей <tex>Y=Y_1\sqcup Y_2\sqcup\dots\sqcup Y_K</tex>. Общая величина ошибки на <tex>K</tex>-кратном скользящем контроле вычисляется как | При <tex>K</tex>-кратном скользящем контроле обучающая выборка <tex>Y</tex> разбивается на <tex>K</tex> равных частей <tex>Y=Y_1\sqcup Y_2\sqcup\dots\sqcup Y_K</tex>. Общая величина ошибки на <tex>K</tex>-кратном скользящем контроле вычисляется как | ||

| - | <tex>Error_{cv} = \frac{1}{N}\sum_{k=1}^K\ \sum_{n:\vec{x}_n\in Y_k} | + | <tex>Error_{cv} = \frac{1}{N}\sum_{k=1}^K\ \sum_{n:\vec{x}_n\in Y_k}I[t_n \neq a(\vec{x}_n, Y_{\backslash k})]</tex>. |

| - | Здесь через <tex>Y_{\backslash k}</tex> обозначена обучающая выборка без части <tex>Y_k</tex>, а через <tex> | + | Здесь через <tex>Y_{\backslash k}</tex> обозначена обучающая выборка без части <tex>Y_k</tex>, а через <tex>I[t \neq y]</tex> — индикаторная функция, равная единице при выполнении условия <tex>t \neq y</tex>. |

| - | + | ||

| - | + | ||

Наиболее популярная версия скользящего контроля — усреднение <tex>Error_{cv}</tex> по пяти независимым запускам 2-кратного скользящего контроля. При таком подходе необходимо обучать алгоритм только по половине обучающей выборки (что происходит быстрее, чем обучение, например, по 9/10 от объема обучающей выборки). Во-вторых, здесь требуется всего 10 различных обучений (что гораздо меньше, чем, например, объем обучающей выборки <tex>N</tex> при разбиении выборки на <tex>K=N</tex> частей). | Наиболее популярная версия скользящего контроля — усреднение <tex>Error_{cv}</tex> по пяти независимым запускам 2-кратного скользящего контроля. При таком подходе необходимо обучать алгоритм только по половине обучающей выборки (что происходит быстрее, чем обучение, например, по 9/10 от объема обучающей выборки). Во-вторых, здесь требуется всего 10 различных обучений (что гораздо меньше, чем, например, объем обучающей выборки <tex>N</tex> при разбиении выборки на <tex>K=N</tex> частей). | ||

| - | Настройка параметра регуляризации <tex> | + | Настройка параметра регуляризации <tex>C</tex> с помощью скользящего контроля производится следующим образом. Выбирается набор возможных значений <tex>C</tex>, например, <tex>2^{-5},2^{-4},\dots,2^{4},2^{5}</tex>. Для каждого из этих значений вычисляется величина ошибки скользящего контроля (например, с помощью усреднения по пяти запускам 2-кратного скользящего контроля). В результате выбирается такое значение <tex>C</tex>, для которого величина ошибки скользящего контроля является наименьшей. В том случае, если требуется настроить два параметра, например <tex>C</tex> и <tex>\gamma</tex> в радиальных базисных функциях, то выбирается двухмерная сетка значений параметров и находится та пара, для которой ошибка на скользящем контроле является наименьшей. |

| - | === Схема решения задач классификации | + | === Схема решения задач классификации === |

| - | В простейшем случае для решения задачи классификации | + | В простейшем случае для решения задачи классификации имеющаяся в распоряжении выборка разбивается на три подвыборки: обучающую, валидационную и тестовую. Сначала выбирается некоторая модель алгоритмов, например, метод опорных векторов с радиальной ядровой функцией. По обучающей выборке в скользящем контроле настраиваются все структурные параметры выбранной модели (для метода опорных векторов с радиальной ядровой функцией в качестве таковых выступают коэффициент регуляризации <tex>C</tex> и параметр <tex>\gamma</tex>). Затем с выбранными значениями структурных параметров производится обучение модели алгоритмов по обучающей выборке. Полученный алгоритм тестируется на обучающей и валидационной выборке. В том случае, если значения обеих ошибок значимо отличаются друг от друга (следовательно, есть переобучение) или их значения близки между собой и достаточно большие (значит, есть недообучение), то выбранная модель алгоритмов признается неудачной и выбирается другая модель алгоритмов (более простая, если ранее было обнаружено переобучение, или более сложная, если ранее было обнаружено недообучение). После того, как удается найти хорошую модель алгоритмов (у которой нет переобучения и недообучения), обучающая и валидационная выборка объединяются между собой и используются в качестве обучающей для настройки структурных параметров по скользящему контролю и последующего обучения в найденной хорошей модели алгоритмов. Затем полученный алгоритм тестируется на обучающей и тестовой выборке. Если обе ошибки близки между собой и достаточно маленькие по значению, то такой алгоритм признается оптимальным для решения задачи классификации. |

| - | + | === Метод K средних === | |

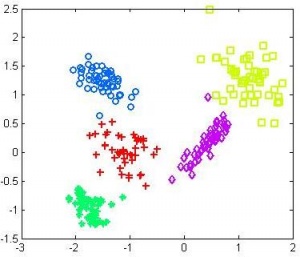

| + | [[Изображение:MOTP12_kmeans.jpg|300px|thumb|Кластеризация выборки на 5 кластеров с помощью метода К средних]] | ||

| + | Рассматривается задача кластеризации. Имеется выборка <tex>\{\vec{x}_n\}_{n=1}^N</tex>, где <tex>\vec{x}_n\in\mathbb{R}^d</tex> — вектор признаков для объекта <tex>n</tex>. Задача состоит в разбиении этой выборки на <tex>K</tex> непересекающихся групп (кластеров) <tex>C_1,\dots,C_k</tex> так, чтобы объекты одной группы были похожи друг на друга, а объекты разных групп — отличались друг от друга. | ||

| + | |||

| + | Введем критерий качества кластеризации следующим образом: | ||

| + | |||

| + | <tex>J = \sum_{k=1}^K\sum_{n:\vec{x}_n\in C_k}{||}\vec{x}_n - \vec{m}_k||^2</tex>, где <tex>m_k = \frac{1}{|C_k|}\sum_{n:\vec{x}_n\in C_k}\vec{x}_n</tex>. | ||

| + | |||

| + | Метод K средних представляет собой жадный алгоритм минимизации критерия <tex>J</tex>. Пусть имеется некоторое текущее разбиение выборки на кластеры <tex>C_1,\dots,C_K</tex>. Тогда одна итерация метода К средних выглядит следующим образом: | ||

| + | # Найти центры текущих кластеров <tex>\vec{m}_1,\dots,\vec{m}_K</tex>: <tex>\vec{m}_k=\frac{1}{|C_k|}\sum_{n:\vec{x}_n\in C_k}\vec{x}_n</tex>; | ||

| + | # Перераспределить объекты по кластерам путем отнесения к ближайшему центру: <tex>\vec{x}_n\in C_k</tex>, если <tex>k = \arg\min_k ||\vec{x}_n-\vec{m}_k||^2</tex>. | ||

| + | |||

| + | Итерационный процесс продолжается до стабилизации значения <tex>J</tex>. Заметим, что в ходе итераций возможна ситуация, когда объекты перераспределяются не по всем <tex>K</tex> кластерам. В результате значение <tex>K</tex> может сократиться. | ||

| + | |||

| + | Очевидно, что представленный алгоритм позволяет найти лишь локальный минимум критерия <tex>J</tex>. Поэтому на практике алгоритм минимизации запускается из нескольких случайных начальных кластеризаций, а в качестве итоговой кластеризации признается та, для которой значение <tex>J</tex> оказалось наименьшим. | ||

== Формулировка задания == | == Формулировка задания == | ||

| - | Для выполнения задания необходимо выполнить следующие пункты: | + | Для выполнения задания на оценку «удовлетворительно» необходимо выполнить следующие пункты: |

| - | + | # Реализовать процедуру обучения/тестирования/подбора структурных параметров метода опорных векторов по описанному ниже прототипу; | |

| - | + | # Продемонстрировать на модельных данных для метода опорных векторов эффект переобучения (маленькая ошибка на обучении, большая ошибка на тесте), эффект недообучения (ошибки на обучении и тесте близки между собой и большие по величине) и ситуацию нормальной работы (ошибки на обучении и тесте близки между собой и маленькие по величине); | |

| - | + | # Решить с помощью метода опорных векторов практическую задачу распознавания рукописных цифр (описание задачи см. ниже) для нескольких пар цифр; желательно рассмотреть как похожие по начертанию цифры, например, 5 и 6, так и сильно непохожие, например, 2 и 4; | |

| - | + | # Составить отчет в формате PDF обо всех проведенных исследованиях; данный отчет должен содержать необходимые графики и описание экспериментов, выводы необходимых формул, описание полученных результатов решения практических задач, общие выводы по исследованию. | |

| - | + | ||

| - | + | Для выполнения задания на оценку «хорошо» необходимо дополнительно к вышеуказанным пунктам выполнить: | |

| - | + | # Реализовать процедуру кластеризации по методу к-средних по описанному ниже прототипу; | |

| - | + | # Продемонстрировать на модельных данных для метода к-средних результаты адекватной и неадекватной кластеризации при условии, что истинное количество кластеров известно (под неадекватной кластеризацией понимается принципиальная негодность метода к-средних для данной выборки, а не локальный минимум функционала <tex>J</tex>); | |

| - | + | # Применить метод кластеризации к-средних для задачи распознавания рукописных цифр; сравнить результаты с аналогичными для метода опорных векторов; | |

| - | + | # Результаты всех проведенных исследований добавить в отчет. | |

| - | + | ||

| - | + | ||

| - | + | ||

| - | + | ||

| - | + | ||

| - | + | ||

| - | + | ||

| - | Для выполнения задания на оценку | + | Для выполнения задания на оценку «отлично» необходимо дополнительно к вышеуказанным пунктам выполнить: |

| + | # Предложить и реализовать процедуру обучения/тестирования/подбора структурных параметров метода опорных векторов для случая многих классов; некоторые идеи обобщения метода опорных векторов на многоклассовый случай изложены [[Media:SMAIS11_SSVM.pdf|здесь]] и [http://users.stat.umn.edu/~xshen/paper/One-Against-All-Zheng.pdf здесь]; | ||

| + | # Применить многоклассовый метод опорных векторов для практической задачи распознавания рукописных цифр; | ||

| + | # Применить метод К средних для задачи распознавания рукописных цифр и сравнить его результаты с аналогичными для многоклассового метода опорных векторов; | ||

| + | # Результаты всех проведенных исследований добавить в отчет. | ||

=== Спецификация реализуемых функций === | === Спецификация реализуемых функций === | ||

| - | + | Задание выполняется в среде [[MATLAB]]. Необходимые алгоритмы должны быть реализованы по прототипам, указанным ниже. | |

{|class="standard" | {|class="standard" | ||

| - | !''Обучение | + | !''Обучение метода опорных векторов'' |

|- | |- | ||

| - | |a = | + | |a = '''svm_train'''(X, t, options) |

|- | |- | ||

|ВХОД | |ВХОД | ||

| Строка 115: | Строка 143: | ||

| | | | ||

{|border="0" | {|border="0" | ||

| - | |X — обучающая выборка, матрица типа double размера N x | + | |X — обучающая выборка, матрица типа double размера N x D, где N — число объектов, D — число признаков. |

|- | |- | ||

| - | |t — | + | |t — метки классов для объектов обучения (+1 и -1), вектор типа double размера 1 x N; |

|- | |- | ||

| - | |options — (необязательный аргумент) набор дополнительных параметров, структура размера 1 x 1, названия полей | + | |options — (необязательный аргумент) набор дополнительных параметров, структура размера 1 x 1, возможны следующие названия полей и их значения: |

|- | |- | ||

| - | | ' | + | | 'С' — значение коэффициента регуляризации (по умолчанию = 1); |

|- | |- | ||

| - | | ' | + | | 'С_tuning' — флаг использования скользящего контроля для настройки коэффициента регуляризации, тип logical, если false, то используется значение для С (по умолчанию = false); |

|- | |- | ||

| - | | ' | + | | 'kernel' — семейство используемых ядровых функций, тип char размера 1 x S, возможные значения 'linear', 'polynomial', 'rbf' (по умолчанию = 'linear'); |

|- | |- | ||

| - | | ' | + | | 'kernel_param' — значение параметра для ядровой функции, тип double размера 1 x 1, для семейства 'rbf' здесь задается значение параметра gamma, для семейства 'polynomial' — значение степени (по умолчанию = 1); |

|- | |- | ||

| - | | ' | + | | 'kernel_tuning' — флаг использования скользящего контроля для подбора параметров ядровых функций, тип logical, если false, то используется значение из kernel_param (по умолчанию = false); |

|- | |- | ||

| 'display' — параметр отображения, тип logical, если false, то на экране ничего не отображается, если true, то отображается текущий статус вычислений в произвольной форме (какие значения параметров пробуются, какие ошибки на скользящем контроле получаются, какие итоговые значения параметров оказались наилучшими и т.д.); | | 'display' — параметр отображения, тип logical, если false, то на экране ничего не отображается, если true, то отображается текущий статус вычислений в произвольной форме (какие значения параметров пробуются, какие ошибки на скользящем контроле получаются, какие итоговые значения параметров оказались наилучшими и т.д.); | ||

| Строка 138: | Строка 166: | ||

| | | | ||

{| | {| | ||

| - | |a — | + | |a — обученный метод опорных векторов, структура размера 1 x 1, поля структуры имеют следующие имена и значения: |

{|border="0" | {|border="0" | ||

| - | |' | + | |'lambdat' — вектор из произведений коэффициентов lambda на метки классов t, вектор типа double размер 1 x M, где M — количество опорных векторов; |

|- | |- | ||

| - | |' | + | |'b' — коэффициент сдвига, число; |

|- | |- | ||

| - | |' | + | |'support_objects' — опорных объекты, матрица типа double размера M x D; |

|- | |- | ||

| - | |' | + | |'kernel' — семейство используемых ядровых функций, совпадает с входным значением 'kernel'; |

|- | |- | ||

| - | |' | + | |'kernel_param' — параметр ядровой функции, совпадает с входным значением 'kernel_param'; |

|- | |- | ||

| - | |||

|} | |} | ||

|} | |} | ||

|} | |} | ||

| - | Обратите внимание: параметры N и | + | Обратите внимание: параметры N и D определяются неявно по размеру соответствующих элементов. |

{|class="standard" | {|class="standard" | ||

| - | !''Тестирование | + | !''Тестирование метода опорных векторов'' |

|- | |- | ||

| - | |[ | + | |[ErrorRate, Answers, Outputs] = '''svm_test'''(a, X, t) |

|- | |- | ||

|ВХОД | |ВХОД | ||

| Строка 165: | Строка 192: | ||

| | | | ||

{|border="0" | {|border="0" | ||

| - | |a — | + | |a — обученный метод опорных векторов, структура, которую возвращает функция svm_train; |

|- | |- | ||

| - | |X — тестовая выборка, матрица типа double размера N_test x | + | |X — тестовая выборка, матрица типа double размера N_test x D; |

|- | |- | ||

| - | |t — (необязательный аргумент), истинные значения | + | |t — (необязательный аргумент), истинные значения меток класса для тестовой выборки, вектор типа double размера 1 x N_test. |

|} | |} | ||

|- | |- | ||

| Строка 176: | Строка 203: | ||

| | | | ||

{|border="0" | {|border="0" | ||

| - | |Outputs — | + | |ErrorRate — процент допущенных ошибок классификации, если вектор t задан, и -1 в обратном случае. |

| + | |- | ||

| + | |Answers — спрогнозированные метки класса для объектов тестовой выборки, вектор типа double размера 1 x N_test; | ||

| + | |- | ||

| + | |Outputs — значения линейной функции <tex>f(\vec{x})</tex> для объектов тестовой выборки, вектор типа double размера 1 x N_test; | ||

|- | |- | ||

| - | |||

|} | |} | ||

|} | |} | ||

| - | + | | |

{|class="standard" | {|class="standard" | ||

| - | !'' | + | !''Кластеризация по методу К средних'' |

|- | |- | ||

| - | |[ | + | |[idx, C] = '''k_means'''(X, K, options) |

|- | |- | ||

|ВХОД | |ВХОД | ||

| Строка 193: | Строка 223: | ||

| | | | ||

{|border="0" | {|border="0" | ||

| - | | | + | |X — входная выборка, матрица типа double размера N x D, где N — число объектов, D — число признаков. |

|- | |- | ||

| - | | | + | |K — количество кластеров, число; |

|- | |- | ||

| - | | | + | |options — (необязательный аргумент) набор дополнительных параметров, структура размера 1 x 1, возможны следующие названия полей и их значения: |

| + | |- | ||

| + | | 'num_start' — количество случайных начальных кластеризаций, число (по умолчанию = 10); | ||

| + | |- | ||

| + | | 'max_iter' — максимальное число итераций, число (по умолчанию = 100); | ||

| + | |- | ||

| + | | 'display' — параметр отображения, тип logical, если false, то на экране ничего не отображается, если true, то отображается текущий статус вычислений в произвольной форме (значения J на каждой итерации, значение J для каждой случайной начальной кластеризации и т.д.); | ||

|} | |} | ||

|- | |- | ||

| Строка 203: | Строка 239: | ||

|- | |- | ||

| | | | ||

| - | {| | + | {| |

| - | | | + | |idx — метки кластеров для каждого объекта входной выборки, вектор типа double размера 1 x N; |

| - | + | ||

| - | + | ||

|- | |- | ||

| - | | | + | |C — центры найденных кластеров, матрица типа double размера M x D, где M равно или меньше K. |

|} | |} | ||

| - | + | |} | |

| + | Внимание! Запрещается пользоваться встроенной в MATLAB функцией kmeans. | ||

=== Рекомендации по выполнению задания === | === Рекомендации по выполнению задания === | ||

| Строка 218: | Строка 253: | ||

normX = sum(X.^2,2); | normX = sum(X.^2,2); | ||

normY = sum(Y.^2,2); | normY = sum(Y.^2,2); | ||

| - | diffXY = bsxfun(@plus, bsxfun(@plus, -2*X*Y', normX), normY'); | + | diffXY = bsxfun(@plus, bsxfun(@plus, -2*(X*Y'), normX), normY'); |

</pre> | </pre> | ||

| + | Для быстрого ознакомления со средой MATLAB и особенностью программирования в ней рекомендуется глава 15 [http://www.machinelearning.ru/wiki/images/7/7e/Dj2010up.pdf учебного пособия]. | ||

2. При работе с выборками для устойчивости всех производимых вычислений рекомендуется осуществлять нормировку выборки независимо для каждого признака таким образом, чтобы среднее значение по выборке равнялось нулю, а выборочная дисперсия — единице. При этом следует иметь в виду, что для тестовых выборок нужно использовать нормировочные коэффициенты, полученные для обучающих выборок. | 2. При работе с выборками для устойчивости всех производимых вычислений рекомендуется осуществлять нормировку выборки независимо для каждого признака таким образом, чтобы среднее значение по выборке равнялось нулю, а выборочная дисперсия — единице. При этом следует иметь в виду, что для тестовых выборок нужно использовать нормировочные коэффициенты, полученные для обучающих выборок. | ||

| - | 3. | + | 3. Задача квадратичного программирования в среде MATLAB решается с помощью функции ''quadprog'' (рекомендуется пользоваться последней версией MATLAB R2012a). При этом в качестве алгоритма решения задачи квадратичного программирования рекомендуется выбирать ''interior-point-convex'' (метод внутренней точки), а также уменьшать значение параметра точности по удовлетворению ограничениям 'TolCon' до 1e-15, чтобы точнее находить множество опорных объектов. |

| - | + | 4. Проверять корректность реализации обучения и тестирования метода опорных векторов следует, в первую очередь, на модельных данных. Например, можно сгенерировать линейно разделимые данные в двухмерном пространстве и визуально отобразить разделяющую поверхность и опорные объекты. Результат должен выглядеть как на картинке внизу, слева. Обучение метода опорных векторов с радиальной ядровой функцией и параметрами <tex>C=4,\ \gamma=0.6</tex> для [[Media:MOTP12_svm_example.rar|этих данных]] должно приводить к результату, показанному на картинке внизу, справа. | |

| - | + | ||

| - | + | ||

| - | + | ||

| - | + | ||

{|align="left" | {|align="left" | ||

| - | + | |[[Изображение:MOTP12_svm_linear.jpg|350px]] | |

| - | |[[Изображение: | + | |[[Изображение:MOTP12_svm_example.jpg|350px]] |

| - | |[[Изображение: | + | |

|}<br clear="all" /> | |}<br clear="all" /> | ||

| - | + | 5. Эффекты переобучения/недообучения для метода опорных векторов можно продемонстрировать следующим образом: сгенерировать двухмерные данные с существенно нелинейной разделяющей поверхностью и обучить метод опорных векторов с радиальной ядровой функцией с различными значениями параметра <tex>\gamma</tex>. Тогда большие значения <tex>\gamma</tex> должны приводить к недообучению, маленькие значения <tex>\gamma</tex> — к переобучению, а некоторое среднее значение <tex>\gamma</tex> будет соответствовать адекватной разделяющей поверхности. | |

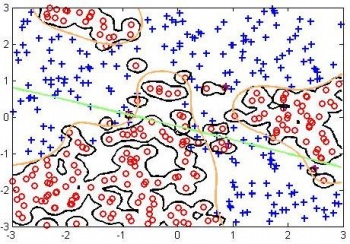

| - | + | [[Изображение:MOTP12_svm_underoverfit.jpg|мини|left|350px|Различные решающие правила, полученные с помощью метода опорных векторов. Зеленое решающее правило — недообучение, черное решающее правило — переобучение, оранжевое решающее правило — адекватное разделение данных.]] | |

| - | + | <br clear="all" /> | |

| - | + | ||

| - | + | === Описание практической задачи === | |

| - | + | ||

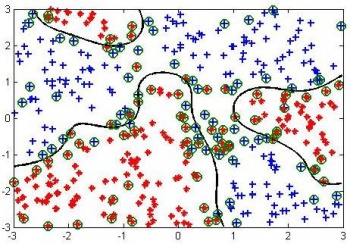

| + | [[Изображение:Mnist.jpg|thumb|300px|Примеры изображений рукописных цифр для задачи MNIST]] | ||

| + | Рассматривается задача распознавания рукописных цифр MNIST. Исходные данные можно скачать [http://yann.lecun.com/exdb/mnist/ здесь]. В этой задаче объектами являются черно-белые изображения размера <tex>28{\times}28</tex>, на каждом из которых представлена одна рукописная цифра, а метками класса являются сами цифры. Таким образом, в данном случае рассматривается задача классификации на 10 классов. Признаковым описанием одного объекта (изображения) являются интенсивности пикселов, вытянутые в вектор. Для устойчивости всех вычислений рекомендуется разделить интенсивности пикселей на 255, чтобы получить значения в диапазоне [0,1]. | ||

| + | |||

| + | При решении данной задачи с помощью двухклассового метода опорных векторов следует выбрать несколько пар классов, например, четверки и девятки или пятерки и шестерки. Также для ускорения вычислений в качестве обучающей выборки можно брать не все имеющиеся данные, а только часть из них, выбранных случайно с сохранением пропорций между классами. В качестве результата классификации на тестовой выборке помимо доли правильно распознанных объектов рекомендуется приводить матрицу точности, в которой в позиции ''(i,j)'' находится количество объектов, отнесенных классификатором к классу ''j'' при том, что на самом деле они принадлежат классу ''i''. | ||

| + | |||

| + | При решении задачи с помощью метода К средних также следует выбрать несколько пар классов и приводить результаты с помощью матрицы точности. При этом необходимо привести примеры пар классов, для которых метод К средних дает хороший результат, и примеры пар классов, для которых кластеризация сильно отличается от истинной классификации. | ||

== Процедура сдачи задания == | == Процедура сдачи задания == | ||

| Строка 249: | Строка 286: | ||

=== Оформление задания === | === Оформление задания === | ||

| - | Необходимо {{важно|в срок до | + | Необходимо {{важно|в срок до 30 августа 2012}} прислать выполненный вариант задания письмом по адресу ''bayesml@gmail.com'' с темой «[МОТП12] Задание СФ, ФИО, номер группы». Убедительная просьба строго придерживаться заданной выше спецификации реализуемых функций. Очень трудно проверять большое количество заданий, если у каждого будет свой формат реализации. |

Письмо должно содержать: | Письмо должно содержать: | ||

| - | *PDF-файл с описанием проведенных исследований (отчет должен включать в себя описание выполнения каждого пункта задания с приведением соответствующих графиков, изображений, чисел) | + | *PDF-файл с описанием проведенных исследований (отчет должен включать в себя описание выполнения каждого пункта задания с приведением соответствующих графиков, изображений, чисел); |

| - | *Файлы | + | *Файлы svm_train.m, svm_test.m, k_means.m; |

| - | *Набор | + | *Файлы, с помощью которых осуществлялось построение всех графиков в отчете; |

| + | *Набор дополнительных файлов при необходимости. | ||

=== Защита задания === | === Защита задания === | ||

Текущая версия

|

Срок сдачи задания: 30 августа 2012, 23:59

Данное практическое задание предназначено, в первую очередь, для студентов Севастопольского филиала, которые имеют задолженность по курсу МОТП и не имеют возможности присутствовать в Москве на пересдачах осенью. Тем не менее, это задание могут выполнять и московские студенты ВМиК, которые имеют задолженность по курсу МОТП. Оценка за это задание будет итоговой оценкой по курсу.

Цель данного задания состоит в том, чтобы студенты познакомились на практике с популярными методами решения задач классификации и кластеризации — методом опорных векторов и методом к-средних, а также с базовыми аспектами, с которыми приходится сталкиваться при решении задач машинного обучения — проблемой переобучения и проблемой подбора структурных параметров алгоритма (таких как коэффициент С и параметры ядровых функций).

Задание выполняется в среде MATLAB.

Вопросы по заданию можно оставлять на вкладке «обсуждение» к этой странице, либо адресовать письмом на bayesml@gmail.com. В название письма просьба добавлять [МОТП12].

Необходимая теория

Метод опорных векторов

Рассматривается задача классификации на два класса. Имеется обучающая выборка , где

— вектор признаков для объекта

, а

— его метка класса. Задача заключается в предсказании метки класса

для объекта, представленного своим вектором признаков

.

В методе опорных векторов предсказание метки класса осуществляется по знаку линейной функции:

Для поиска весов и величины сдвига

решается следующая задача квадратичного программирования:

Здесь — параметр алгоритма, который задает компромисс между точностью распознавания обучающей выборки и величиной зазора между данными и гиперплоскостью (надежностью классификации).

После решения задачи квадратичного программирования оптимальный вектор весов вычисляется как

.

Очевидно, что только те объекты обучающей выборки, для которых , влияют на оптимальный вектор весов. Такие объекты получили название опорных. Пусть

. Тогда оптимальная величина сдвига гиперплоскости

определяется как

.

На практике здесь лучше проводить усреднение по всем . Если в оптимальном

все коэффициенты равны только нулю и

, то тогда коэффициент

может быть найден перебором путем минимизации ошибки распознавания обучающей выборки.

Использование ядровых функций

Для построения нелинейных решающих правил с помощью метода опорных векторов вводится понятие ядровой функции. Пусть имеется преобразование из исходного признакового пространства в новое пространство

, задаваемое функцией

. Пусть также имеется ядровая функция

, которая задает скалярное произведение в новом пространстве

:

Тогда для построения линейной разделяющей гиперплоскости в новом пространстве достаточно знать лишь ядровую функцию

и не требуется знать само преобразование

. В этом случае на этапе обучения метода решается следующая задача квадратичного программирования:

При этом скалярное произведение оптимального вектора весов и произвольного объекта

определяется как

По-прежнему, только опорные объекты (для которых ) вносят вклад в значение данного скалярного произведения. Величина сдвига гиперплоскости, как и раньше, определяется как

Если все коэффициенты принимают только крайние значения, то оптимальный сдвиг

находится путем минимизации числа ошибок на обучающей выборке.

Ядровая функция, как правило, выбирается в одном из следующих параметрических семейств:

- Линейная:

,

- Степенная:

.

- Радиальная:

.

В случае степенной ядровой функции делается неявное предположение о том, что данные отнормированы на нулевой центр и единичную дисперсию. В этом случае, по неравенству Коши-Буняковского, величина всегда будет неотрицательной.

Скользящий контроль

В методе опорных векторов параметр регуляризации , а также параметры ядровых функций (например, параметр

в радиальной ядровой функции) являются структурными параметрами, которые

не могут быть настроены путем минимизации числа ошибок на обучающей выборке. Для их настройки используются критерии выбора модели, например, скользящий контроль.

Обозначим обучающую выборку через , а через

— результат прогноза метки класса для объекта

, полученный с помощью алгоритма

, обученного по выборке

.

При

-кратном скользящем контроле обучающая выборка

разбивается на

равных частей

. Общая величина ошибки на

-кратном скользящем контроле вычисляется как

.

Здесь через обозначена обучающая выборка без части

, а через

— индикаторная функция, равная единице при выполнении условия

.

Наиболее популярная версия скользящего контроля — усреднение по пяти независимым запускам 2-кратного скользящего контроля. При таком подходе необходимо обучать алгоритм только по половине обучающей выборки (что происходит быстрее, чем обучение, например, по 9/10 от объема обучающей выборки). Во-вторых, здесь требуется всего 10 различных обучений (что гораздо меньше, чем, например, объем обучающей выборки

при разбиении выборки на

частей).

Настройка параметра регуляризации с помощью скользящего контроля производится следующим образом. Выбирается набор возможных значений

, например,

. Для каждого из этих значений вычисляется величина ошибки скользящего контроля (например, с помощью усреднения по пяти запускам 2-кратного скользящего контроля). В результате выбирается такое значение

, для которого величина ошибки скользящего контроля является наименьшей. В том случае, если требуется настроить два параметра, например

и

в радиальных базисных функциях, то выбирается двухмерная сетка значений параметров и находится та пара, для которой ошибка на скользящем контроле является наименьшей.

Схема решения задач классификации

В простейшем случае для решения задачи классификации имеющаяся в распоряжении выборка разбивается на три подвыборки: обучающую, валидационную и тестовую. Сначала выбирается некоторая модель алгоритмов, например, метод опорных векторов с радиальной ядровой функцией. По обучающей выборке в скользящем контроле настраиваются все структурные параметры выбранной модели (для метода опорных векторов с радиальной ядровой функцией в качестве таковых выступают коэффициент регуляризации и параметр

). Затем с выбранными значениями структурных параметров производится обучение модели алгоритмов по обучающей выборке. Полученный алгоритм тестируется на обучающей и валидационной выборке. В том случае, если значения обеих ошибок значимо отличаются друг от друга (следовательно, есть переобучение) или их значения близки между собой и достаточно большие (значит, есть недообучение), то выбранная модель алгоритмов признается неудачной и выбирается другая модель алгоритмов (более простая, если ранее было обнаружено переобучение, или более сложная, если ранее было обнаружено недообучение). После того, как удается найти хорошую модель алгоритмов (у которой нет переобучения и недообучения), обучающая и валидационная выборка объединяются между собой и используются в качестве обучающей для настройки структурных параметров по скользящему контролю и последующего обучения в найденной хорошей модели алгоритмов. Затем полученный алгоритм тестируется на обучающей и тестовой выборке. Если обе ошибки близки между собой и достаточно маленькие по значению, то такой алгоритм признается оптимальным для решения задачи классификации.

Метод K средних

Рассматривается задача кластеризации. Имеется выборка , где

— вектор признаков для объекта

. Задача состоит в разбиении этой выборки на

непересекающихся групп (кластеров)

так, чтобы объекты одной группы были похожи друг на друга, а объекты разных групп — отличались друг от друга.

Введем критерий качества кластеризации следующим образом:

, где

.

Метод K средних представляет собой жадный алгоритм минимизации критерия . Пусть имеется некоторое текущее разбиение выборки на кластеры

. Тогда одна итерация метода К средних выглядит следующим образом:

- Найти центры текущих кластеров

:

;

- Перераспределить объекты по кластерам путем отнесения к ближайшему центру:

, если

.

Итерационный процесс продолжается до стабилизации значения . Заметим, что в ходе итераций возможна ситуация, когда объекты перераспределяются не по всем

кластерам. В результате значение

может сократиться.

Очевидно, что представленный алгоритм позволяет найти лишь локальный минимум критерия . Поэтому на практике алгоритм минимизации запускается из нескольких случайных начальных кластеризаций, а в качестве итоговой кластеризации признается та, для которой значение

оказалось наименьшим.

Формулировка задания

Для выполнения задания на оценку «удовлетворительно» необходимо выполнить следующие пункты:

- Реализовать процедуру обучения/тестирования/подбора структурных параметров метода опорных векторов по описанному ниже прототипу;

- Продемонстрировать на модельных данных для метода опорных векторов эффект переобучения (маленькая ошибка на обучении, большая ошибка на тесте), эффект недообучения (ошибки на обучении и тесте близки между собой и большие по величине) и ситуацию нормальной работы (ошибки на обучении и тесте близки между собой и маленькие по величине);

- Решить с помощью метода опорных векторов практическую задачу распознавания рукописных цифр (описание задачи см. ниже) для нескольких пар цифр; желательно рассмотреть как похожие по начертанию цифры, например, 5 и 6, так и сильно непохожие, например, 2 и 4;

- Составить отчет в формате PDF обо всех проведенных исследованиях; данный отчет должен содержать необходимые графики и описание экспериментов, выводы необходимых формул, описание полученных результатов решения практических задач, общие выводы по исследованию.

Для выполнения задания на оценку «хорошо» необходимо дополнительно к вышеуказанным пунктам выполнить:

- Реализовать процедуру кластеризации по методу к-средних по описанному ниже прототипу;

- Продемонстрировать на модельных данных для метода к-средних результаты адекватной и неадекватной кластеризации при условии, что истинное количество кластеров известно (под неадекватной кластеризацией понимается принципиальная негодность метода к-средних для данной выборки, а не локальный минимум функционала

);

- Применить метод кластеризации к-средних для задачи распознавания рукописных цифр; сравнить результаты с аналогичными для метода опорных векторов;

- Результаты всех проведенных исследований добавить в отчет.

Для выполнения задания на оценку «отлично» необходимо дополнительно к вышеуказанным пунктам выполнить:

- Предложить и реализовать процедуру обучения/тестирования/подбора структурных параметров метода опорных векторов для случая многих классов; некоторые идеи обобщения метода опорных векторов на многоклассовый случай изложены здесь и здесь;

- Применить многоклассовый метод опорных векторов для практической задачи распознавания рукописных цифр;

- Применить метод К средних для задачи распознавания рукописных цифр и сравнить его результаты с аналогичными для многоклассового метода опорных векторов;

- Результаты всех проведенных исследований добавить в отчет.

Спецификация реализуемых функций

Задание выполняется в среде MATLAB. Необходимые алгоритмы должны быть реализованы по прототипам, указанным ниже.

| Обучение метода опорных векторов | |||||||||

|---|---|---|---|---|---|---|---|---|---|

| a = svm_train(X, t, options) | |||||||||

| ВХОД | |||||||||

| |||||||||

| ВЫХОД | |||||||||

|

Обратите внимание: параметры N и D определяются неявно по размеру соответствующих элементов.

| Тестирование метода опорных векторов | |||

|---|---|---|---|

| [ErrorRate, Answers, Outputs] = svm_test(a, X, t) | |||

| ВХОД | |||

| |||

| ВЫХОД | |||

|

| Кластеризация по методу К средних | ||||||

|---|---|---|---|---|---|---|

| [idx, C] = k_means(X, K, options) | ||||||

| ВХОД | ||||||

| ||||||

| ВЫХОД | ||||||

|

Внимание! Запрещается пользоваться встроенной в MATLAB функцией kmeans.

Рекомендации по выполнению задания

1. Эффективное программирование под MATLAB предполагает активнейшее использование векторных и матричных операций. В частности, по возможности следует избегать любых циклов. Например, для вычисления матрицы попарных расстояний между набором объектов, задаваемых матрицами и

, можно воспользоваться свойством

, что в MATLAB может быть реализовано как

normX = sum(X.^2,2);

normY = sum(Y.^2,2);

diffXY = bsxfun(@plus, bsxfun(@plus, -2*(X*Y'), normX), normY');

Для быстрого ознакомления со средой MATLAB и особенностью программирования в ней рекомендуется глава 15 учебного пособия.

2. При работе с выборками для устойчивости всех производимых вычислений рекомендуется осуществлять нормировку выборки независимо для каждого признака таким образом, чтобы среднее значение по выборке равнялось нулю, а выборочная дисперсия — единице. При этом следует иметь в виду, что для тестовых выборок нужно использовать нормировочные коэффициенты, полученные для обучающих выборок.

3. Задача квадратичного программирования в среде MATLAB решается с помощью функции quadprog (рекомендуется пользоваться последней версией MATLAB R2012a). При этом в качестве алгоритма решения задачи квадратичного программирования рекомендуется выбирать interior-point-convex (метод внутренней точки), а также уменьшать значение параметра точности по удовлетворению ограничениям 'TolCon' до 1e-15, чтобы точнее находить множество опорных объектов.

4. Проверять корректность реализации обучения и тестирования метода опорных векторов следует, в первую очередь, на модельных данных. Например, можно сгенерировать линейно разделимые данные в двухмерном пространстве и визуально отобразить разделяющую поверхность и опорные объекты. Результат должен выглядеть как на картинке внизу, слева. Обучение метода опорных векторов с радиальной ядровой функцией и параметрами для этих данных должно приводить к результату, показанному на картинке внизу, справа.

|

|

5. Эффекты переобучения/недообучения для метода опорных векторов можно продемонстрировать следующим образом: сгенерировать двухмерные данные с существенно нелинейной разделяющей поверхностью и обучить метод опорных векторов с радиальной ядровой функцией с различными значениями параметра . Тогда большие значения

должны приводить к недообучению, маленькие значения

— к переобучению, а некоторое среднее значение

будет соответствовать адекватной разделяющей поверхности.

Описание практической задачи

Рассматривается задача распознавания рукописных цифр MNIST. Исходные данные можно скачать здесь. В этой задаче объектами являются черно-белые изображения размера , на каждом из которых представлена одна рукописная цифра, а метками класса являются сами цифры. Таким образом, в данном случае рассматривается задача классификации на 10 классов. Признаковым описанием одного объекта (изображения) являются интенсивности пикселов, вытянутые в вектор. Для устойчивости всех вычислений рекомендуется разделить интенсивности пикселей на 255, чтобы получить значения в диапазоне [0,1].

При решении данной задачи с помощью двухклассового метода опорных векторов следует выбрать несколько пар классов, например, четверки и девятки или пятерки и шестерки. Также для ускорения вычислений в качестве обучающей выборки можно брать не все имеющиеся данные, а только часть из них, выбранных случайно с сохранением пропорций между классами. В качестве результата классификации на тестовой выборке помимо доли правильно распознанных объектов рекомендуется приводить матрицу точности, в которой в позиции (i,j) находится количество объектов, отнесенных классификатором к классу j при том, что на самом деле они принадлежат классу i.

При решении задачи с помощью метода К средних также следует выбрать несколько пар классов и приводить результаты с помощью матрицы точности. При этом необходимо привести примеры пар классов, для которых метод К средних дает хороший результат, и примеры пар классов, для которых кластеризация сильно отличается от истинной классификации.

Процедура сдачи задания

Оформление задания

Необходимо в срок до 30 августа 2012 прислать выполненный вариант задания письмом по адресу bayesml@gmail.com с темой «[МОТП12] Задание СФ, ФИО, номер группы». Убедительная просьба строго придерживаться заданной выше спецификации реализуемых функций. Очень трудно проверять большое количество заданий, если у каждого будет свой формат реализации.

Письмо должно содержать:

- PDF-файл с описанием проведенных исследований (отчет должен включать в себя описание выполнения каждого пункта задания с приведением соответствующих графиков, изображений, чисел);

- Файлы svm_train.m, svm_test.m, k_means.m;

- Файлы, с помощью которых осуществлялось построение всех графиков в отчете;

- Набор дополнительных файлов при необходимости.

Защита задания

После сдачи выполненного задания и его проверки необходимо будет защитить свое задание. В том случае, если в какой-то части выполненного задания будет обнаружен плагиат с заданием другого студента, то задание не будет засчитано для обоих студентов! Защита задания будет осуществляться с помощью видео-чата для студентов СФ и во время осенних пересдач для московских студентов. Студенту будет предложен ряд вопросов по присланному коду и проведенным исследованиям. Кроме того, возможны задания по небольшой модификации кода в режиме онлайн.