Проведение поверхностей наилучшего приближения

Материал из MachineLearning.

(→Пример) |

(→Список литературы: переименовал раздел) |

||

| (5 промежуточных версий не показаны.) | |||

| Строка 24: | Строка 24: | ||

|} | |} | ||

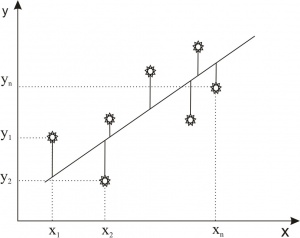

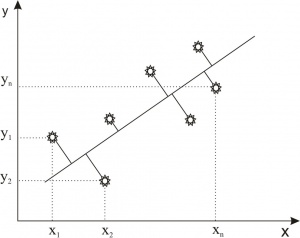

| - | Требуется наилучшим образом сгладить экспериментальную | + | Требуется наилучшим образом сгладить экспериментальную зависимость между переменными <tex>x</tex> и <tex>y</tex>, т.е. по возможности точно отразить общую тенденцию зависимости <tex>y</tex> от <tex>x</tex>, исключив при этом случайные отклонения, связанные с неизбежными погрешностями измерений или статистических наблюдений. Такую сглаженную зависимость стремятся представить в виде формулы <tex>y = f(x)</tex>. |

Формулы, служащие для аналитического представления опытных данных, получили название ''эмпирических формул''. | Формулы, служащие для аналитического представления опытных данных, получили название ''эмпирических формул''. | ||

| Строка 35: | Строка 35: | ||

=== Метод наименьших квадратов === | === Метод наименьших квадратов === | ||

| - | + | {{main|Метод наименьших квадратов}} | |

Пусть функция <tex>y = f(x)</tex> задана таблицей своих значений: <tex>y_i = f(x_i), i = 0,1,...,n</tex>. Требуется найти многочлен фиксированной степени <tex>m</tex>, для которого среднеквадратичное отклонение (СКО) <tex>\sigma = \sqrt{\frac{1}{n + 1}\sum^{n}_{i=0}{(P_m(x_i)-y_i)^2}}</tex> минимально. | Пусть функция <tex>y = f(x)</tex> задана таблицей своих значений: <tex>y_i = f(x_i), i = 0,1,...,n</tex>. Требуется найти многочлен фиксированной степени <tex>m</tex>, для которого среднеквадратичное отклонение (СКО) <tex>\sigma = \sqrt{\frac{1}{n + 1}\sum^{n}_{i=0}{(P_m(x_i)-y_i)^2}}</tex> минимально. | ||

| - | Так как многочлен <tex>P_m(x) = a_0+a_1x+a_2x^2+...+a_mx^m</tex> определяется своими коэффициентами, то фактически нужно подобрать набор | + | Так как многочлен <tex>P_m(x) = a_0+a_1x+a_2x^2+...+a_mx^m</tex> определяется своими коэффициентами, то фактически нужно подобрать набор коэффициентов <tex>a_0,a_1,...,a_m</tex>, минимизирующий функцию <tex>\Psi(a_0,a_1,...,a_m) = \sum^{n}_{i=0}{(P_m(x_i)-y_i)^2} = \sum^{n}_{i=0}({\sum^{m}_{j=0}{a_jx_i^j}-y_i)^2}</tex>. |

Используя необходимое условие экстремума, <tex>\frac{\partial\Psi}{\partial a_k} = 0, k = 0,1,...,m</tex> получаем так называемую нормальную систему метода наименьших квадратов: <tex>\sum^{m}_{j=0}{(\sum^{n}_{i=0}{x_i^{j+k}})a_j} = \sum^{n}_{i=0}{y_ix_i^k}, k = 0,1,...,m</tex>. | Используя необходимое условие экстремума, <tex>\frac{\partial\Psi}{\partial a_k} = 0, k = 0,1,...,m</tex> получаем так называемую нормальную систему метода наименьших квадратов: <tex>\sum^{m}_{j=0}{(\sum^{n}_{i=0}{x_i^{j+k}})a_j} = \sum^{n}_{i=0}{y_ix_i^k}, k = 0,1,...,m</tex>. | ||

| Строка 97: | Строка 97: | ||

== Методы, минимизирующие расстояния до объектов == | == Методы, минимизирующие расстояния до объектов == | ||

=== Метод наименьших расстояний === | === Метод наименьших расстояний === | ||

| - | Другой метод сглаживания экспериментальных зависимостей отличается от метода | + | Другой метод сглаживания экспериментальных зависимостей отличается от метода наименьших квадратов лишь расстоянием от точки до прямой, которой мы приближаем данную функцию. |

Если в МНК минимизировалось среднее квадратичное отклонение (СКО) <tex>\sigma = \sqrt{\frac{1}{n + 1}\sum^{n}_{i=0}{(P_m(x_i)-y_i)^2}}</tex>,то в методе наименьших расстояний берется наименьшее расстояние от объекта до прямой <tex>\sigma = \sqrt{\frac{1}{n + 1}\sum^{n}_{i=0}{\rho^2(M_i,L)}}</tex>, где <tex>M_i</tex> - точка <tex>(x_i,y_i)</tex>, а <tex>L</tex> - прямая,приближающая данную функцию. | Если в МНК минимизировалось среднее квадратичное отклонение (СКО) <tex>\sigma = \sqrt{\frac{1}{n + 1}\sum^{n}_{i=0}{(P_m(x_i)-y_i)^2}}</tex>,то в методе наименьших расстояний берется наименьшее расстояние от объекта до прямой <tex>\sigma = \sqrt{\frac{1}{n + 1}\sum^{n}_{i=0}{\rho^2(M_i,L)}}</tex>, где <tex>M_i</tex> - точка <tex>(x_i,y_i)</tex>, а <tex>L</tex> - прямая,приближающая данную функцию. | ||

| Строка 158: | Строка 158: | ||

<tex>\sum^{4}_{i=0}{x_i}=0 ,\sum^{4}_{i=0}{x_i^2}=20 ,\sum^{4}_{i=0}{y_i^2}=26.74</tex> | <tex>\sum^{4}_{i=0}{x_i}=0 ,\sum^{4}_{i=0}{x_i^2}=20 ,\sum^{4}_{i=0}{y_i^2}=26.74</tex> | ||

| - | <tex>\sum^{4}_{i=0}{y_i}=0.6 ,\sum^{4}_{i=0}{y_ix_i}=19.6 | + | <tex>\sum^{4}_{i=0}{y_i}=0.6 ,\sum^{4}_{i=0}{y_ix_i}=19.6</tex> |

=== МНК === | === МНК === | ||

| Строка 192: | Строка 192: | ||

=== Пример программы === | === Пример программы === | ||

| - | * [[Media: | + | * [[Media:CSAB.zip|Исходный текст программы]] |

== Заключение == | == Заключение == | ||

| Строка 198: | Строка 198: | ||

В процессе сравнения метода наименьших квадратов и метода наименьших расстояний можно сделать следующие выводы: оба метода дают результаты, мало отличающиеся друг от друга. МНК и МНР достаточно хорошо справляются с задачей построения поверхностей наилучшего приближения, о чем можно судить по результатам для линейного случая. В пространствах более высокого порядка это может быть не так. И вообще МНК в них предпочтительней только потому, что выписать нормальную систему для МНР является нетривиальной задачей (даже для линейного случая порядок уравнений в МНР у нас 3, а в МНК - 2). | В процессе сравнения метода наименьших квадратов и метода наименьших расстояний можно сделать следующие выводы: оба метода дают результаты, мало отличающиеся друг от друга. МНК и МНР достаточно хорошо справляются с задачей построения поверхностей наилучшего приближения, о чем можно судить по результатам для линейного случая. В пространствах более высокого порядка это может быть не так. И вообще МНК в них предпочтительней только потому, что выписать нормальную систему для МНР является нетривиальной задачей (даже для линейного случая порядок уравнений в МНР у нас 3, а в МНК - 2). | ||

| - | == Список | + | == Список источников == |

| - | *http://algolist.manual.ru/ | + | * http://algolist.manual.ru/ |

| - | *http://detc.usu.ru/ | + | * http://detc.usu.ru/ |

| - | *http://www.exponenta.ru/ | + | * http://www.exponenta.ru/ |

| - | *http://ru.wikipedia.org/ | + | * http://ru.wikipedia.org/ |

| + | |||

| + | [[Категория:Регрессионный анализ]] | ||

Текущая версия

Содержание |

Введение

На практике мы часто сталкиваемся с задачей о сглаживании экспериментальных зависимостей.

Пусть зависимость между двумя переменными и

выражается в виде таблицы, полученной опытным путем. Это могут быть результаты опыта или наблюдений, статистической обработки материала и т.п.

| x | x1 | x2 | ... | xi | ... | xn |

|---|---|---|---|---|---|---|

| y | y1 | y2 | ... | yi | ... | yn |

Требуется наилучшим образом сгладить экспериментальную зависимость между переменными и

, т.е. по возможности точно отразить общую тенденцию зависимости

от

, исключив при этом случайные отклонения, связанные с неизбежными погрешностями измерений или статистических наблюдений. Такую сглаженную зависимость стремятся представить в виде формулы

.

Формулы, служащие для аналитического представления опытных данных, получили название эмпирических формул.

Задача нахождения эмпирических формул разбивается на два этапа. На первом этапе нужно установить вид зависимости , т.е. решить, является ли она линейной, квадратичной, логарифмической или какой-либо другой. Второй этап – определение неизвестных параметров этой функции.

Часто вид эмпирической зависимости известен, но числовые параметры неизвестны. Будем считать, что зависимость полиномиальная, а для определения параметров полинома рассмотрим следующие методы.

Методы восстановления регрессии, минимизирующие невязку ответов

Метод наименьших квадратов

Пусть функция задана таблицей своих значений:

. Требуется найти многочлен фиксированной степени

, для которого среднеквадратичное отклонение (СКО)

минимально.

Так как многочлен определяется своими коэффициентами, то фактически нужно подобрать набор коэффициентов

, минимизирующий функцию

.

Используя необходимое условие экстремума, получаем так называемую нормальную систему метода наименьших квадратов:

.

Полученная система есть система алгебраических уравнений относительно неизвестных . Можно показать, что определитель этой системы отличен от нуля, то есть решение существует и единственно. Однако при высоких степенях m система является плохо обусловленной. Поэтому метод наименьших квадратов применяют для нахождения многочленов, степень которых не выше 5. Решение нормальной системы можно найти, например, методом Гаусса.

Запишем нормальную систему наименьших квадратов для двух простых случаев: и

. При

многочлен примет вид:

. Для нахождения неизвестного коэффициента

имеем уравнение:

. Получаем, что коэффициент

есть среднее арифметическое значений функции в заданных точках.

Если же используется многочлен второй степени , то нормальная система уравнений примет вид:

Пример

Пусть функция задана таблицей своих значений:

| x | -3 | -1 | 0 | 1 | 3 |

|---|---|---|---|---|---|

| y | -4 | -0.8 | 1.6 | 2.3 | 1.5 |

Приблизим функцию многочленом 2-ой степени. Для этого вычислим коэффициенты нормальной системы уравнений:

Составим нормальную систему наименьших квадратов, которая имеет вид:

Решение системы легко находится:.

Таким образом, многочлен 2-ой степени найден: .

Нахождение оптимальной степени многочлена

Предположим, что функцию можно с высокой точностью аппроксимировать многочленом

некоторой степени

. Если эта степень заранее неизвестна, то возникает проблема выбора оптимальной степени аппроксимирующего многочлена в условиях, когда исходные данные

содержат случайные ошибки. Для решения этой задачи можно принять следующий алгоритм: для каждого

вычисляется величина

. За оптимальное значение степени многочлена следует принять то значение

, начиная с которого величина

стабилизируется или начинает возрастать.

Определение параметров эмпирической зависимости

Часто из физических соображений следует, что зависимость между величинами хорошо описывается моделью вида

, где вид зависимости

известен. Тогда применение критерия наименьших квадратов приводит к задаче определения искомых параметров

из условия минимума функции:

.

Если зависимость от параметров нелинейна, то экстремум функции

ищут методами минимизации функций нескольких переменных.

Методы, минимизирующие расстояния до объектов

Метод наименьших расстояний

Другой метод сглаживания экспериментальных зависимостей отличается от метода наименьших квадратов лишь расстоянием от точки до прямой, которой мы приближаем данную функцию.

Если в МНК минимизировалось среднее квадратичное отклонение (СКО) ,то в методе наименьших расстояний берется наименьшее расстояние от объекта до прямой

, где

- точка

, а

- прямая,приближающая данную функцию.

И аналогично МНК производятся все вычисления.

Вычисление расстояния между точкой и прямой

Когда прямая задана формулой то для любой точки

расстояние

может быть получено прямо из уравнения:

.

Сравнение

Рассмотрим линейную функцию

МНК

В методе наименьших квадратов подбираются коэффициенты, минимизирующие функцию

Используя необходимое условие экстремума, получаем так называемую нормальную систему метода наименьших квадратов:

МНР

Метод наименьших расстояний для линейного случая отличается функцией, которую минимизируем.

Также из условия экстремума получаем нормальную систему для данного метода.

Пример

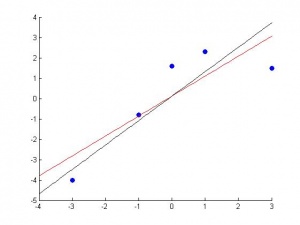

Рассмотрим применение данных методов на реальном примере. Пусть имеются точки, координаты которых представлены в таблице.

| x | -3 | -1 | 0 | 1 | 3 |

|---|---|---|---|---|---|

| y | -4 | -0.8 | 1.6 | 2.3 | 1.5 |

Суммы,необходимые для решения нормальных систем, будут такими:

МНК

Считаем оптимальные параметры a и b.

Прямая будет иметь вид:

МНР

Аналогично считаем методом наименьших расстояний.

Получили два уравнения прямых. Вторая соответствует локальному максимуму и поэтому не представляет собой поверхность наилучшего приближения.

Для наглядности результаты представлены на рисунке.

Пример программы

Заключение

В процессе сравнения метода наименьших квадратов и метода наименьших расстояний можно сделать следующие выводы: оба метода дают результаты, мало отличающиеся друг от друга. МНК и МНР достаточно хорошо справляются с задачей построения поверхностей наилучшего приближения, о чем можно судить по результатам для линейного случая. В пространствах более высокого порядка это может быть не так. И вообще МНК в них предпочтительней только потому, что выписать нормальную систему для МНР является нетривиальной задачей (даже для линейного случая порядок уравнений в МНР у нас 3, а в МНК - 2).