Статистический отчет при создании моделей

Материал из MachineLearning.

|

В данной работе приведен обзор статистических методов оценивания качества регрессионных моделей, используемых популярными программами машинного обучения и статистической обработки данных. Приведены примеры вычисления и анализа полученных оценок.

Постановка задачи

Имеется пространство объектов-строк и

пространство ответов

.

Задана выборка

.

Обозначеним:

-

— матрица информации или матрица плана;

-

— вектор параметров;

-

— целевой вектор.

Будем считать, что зависимость имеет вид

,

где — некоторая неслучайная функция,

— случайная величина,

с нулевым математически ожиданием.

В моделях предполагается, что неслучайная составляющая имеет вид:

-

и

— в логистической регрессии.

Требуется численно оценить качество модели при заданном векторе параметров .

Описание решения

Предполагая,

что матрица ковариации вектора ошибки имеет вид

,

где

(

может быть задана пользователем, иначе выбирается единичная матрица),

получаем выражение для оценки параметров

взвешенным методом наименьших квадратов:

Основными инструментами оценки качества линейной модели является анализ:

- регрессионных остатков;

- матрицы частных и получастных корреляций (условные корреляции);

- корреляции и ковариации коэффициентов регрессии;

- статистики Дарбина-Уотсона;

- расстояния Махаланобиса между исходной и модельной зависимостями;

- расстояния Кука (мера изменения прогноза при удалении одного объекта);

- доверительных интервалов для предсказанных значений.

Для оценки качества модели линейной регрессии в работе рассматривается

- анализ регрессионных остатков, включающий в себя:

- вычисление среднеквадратичной ошибки:

- вычисление коэффициента детерминации:

где

- проверку гипотезы о равенстве нулю математического ожидания регрессионных остатков на основе критерия знаков;

- проверку гипотезы о равенстве дисперсий (пропорциональности с заданными коэффициентами) регрессионных остатков на основе критерия Ансари-Брэдли;

- проверку гипотезы о нормальности распределения регрессионных остатков на основе критерия хи-квадрат и критерия Жарка-Бера;

- вычисление расстояния Махаланобиса и Кука;

- вычисление корреляций признаков, корреляций признаков и значений моделируемой функции и коэффициента множественной регрессии.

Для оценки качества модели логистической регрессии в работе рассматриваются оценки

- дисперсии шума модели;

- корреляции и ковариации коэффициентов регрессии;

- значимости компонент пространства объектов для восстановления ответов;

Вычислительный эксперимент

В данном отчете представлены результаты применения созданного инструмента для анализа модели. Отчет состоит из пяти экспериментов, демонстрирующих работу инструмента на различных по качеству моделях. Модели 1-3 приведены для линейной регрессии, 4-5 — для логистической.

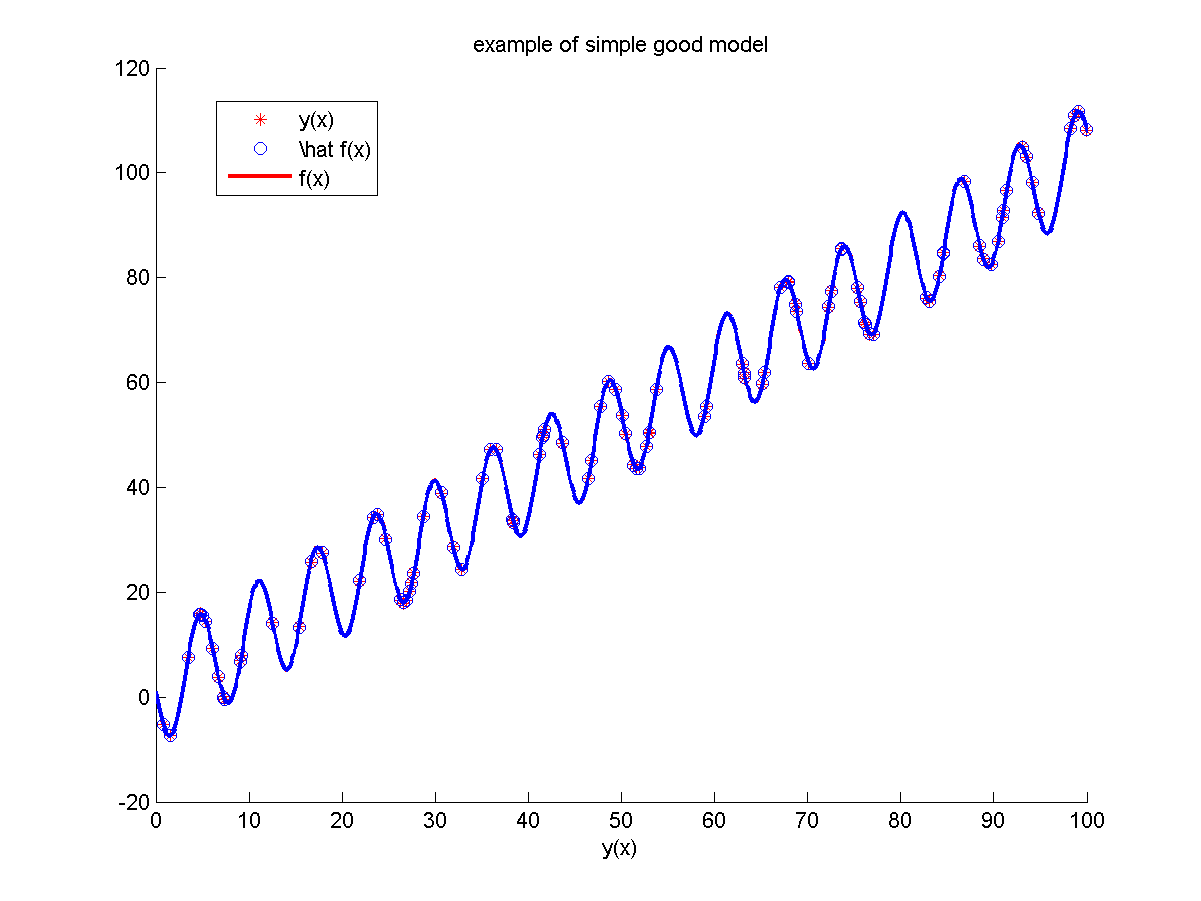

Модель №1

Неизвестная зависимость:

.

Для построения модели использовалось объектов независимо равномерно распределительных на отрезке

В качестве шума использовались независимые случайные величины из распределения

В качестве признаков использовались

.

Параметры модели подбирались с помощью метода наименьших квадратов.

Отчет, построенный программой:

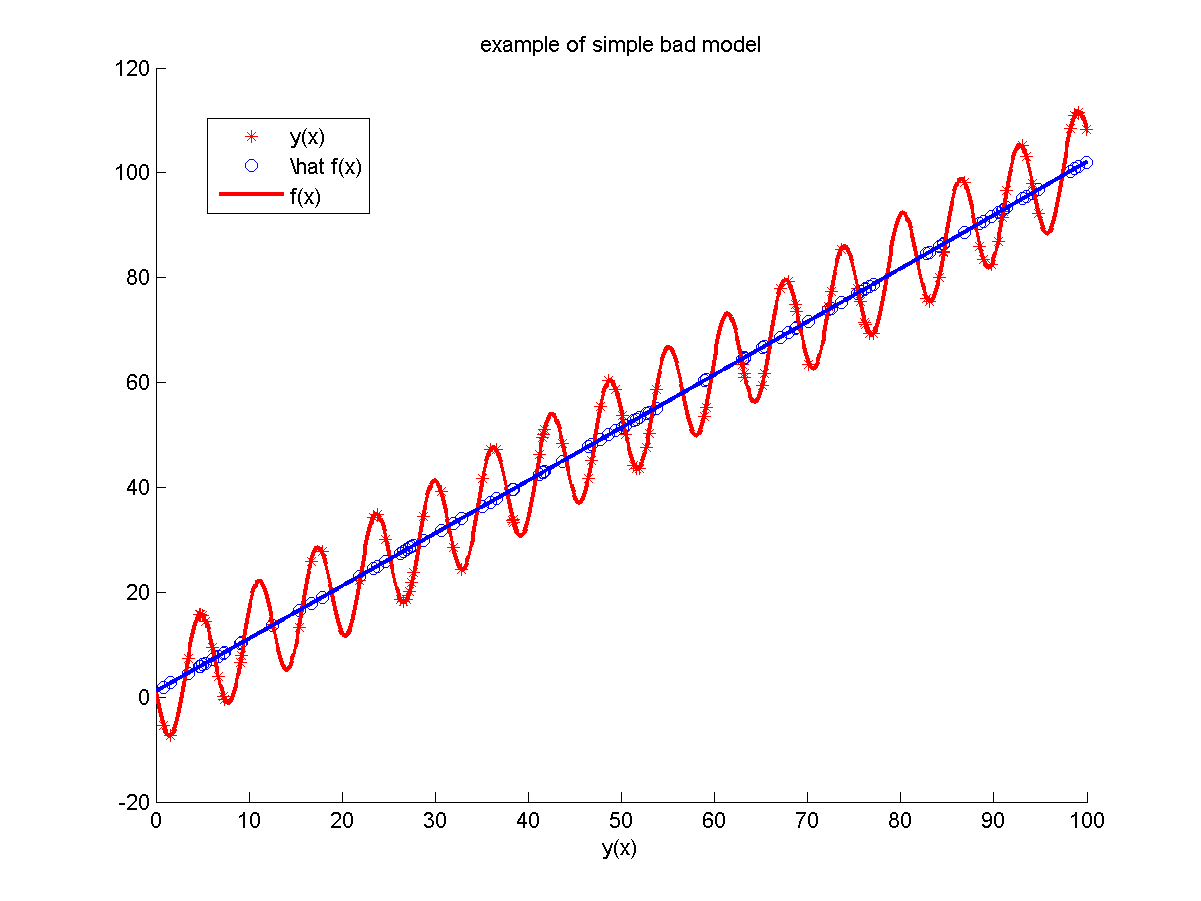

Модель №2

Неизвестная зависимость:

.

Для построения модели использовалось объектов независимо равномерно распределительных на отрезке

В качестве шума использовались независимые случайные величины из распределения

В качестве признаков использовались

.

Параметры модели подбирались с помощью метода наименьших квадратов.

Отчет, построенный программой:

Модель №3

Неизвестная зависимость:

.

Для построения модели использовалось объектов независимо равномерно распределительных на отрезке

В качестве шума использовались независимые случайные величины из распределения

В качестве признаков использовались

.

Параметры модели подбирались с помощью метода наименьших квадратов.

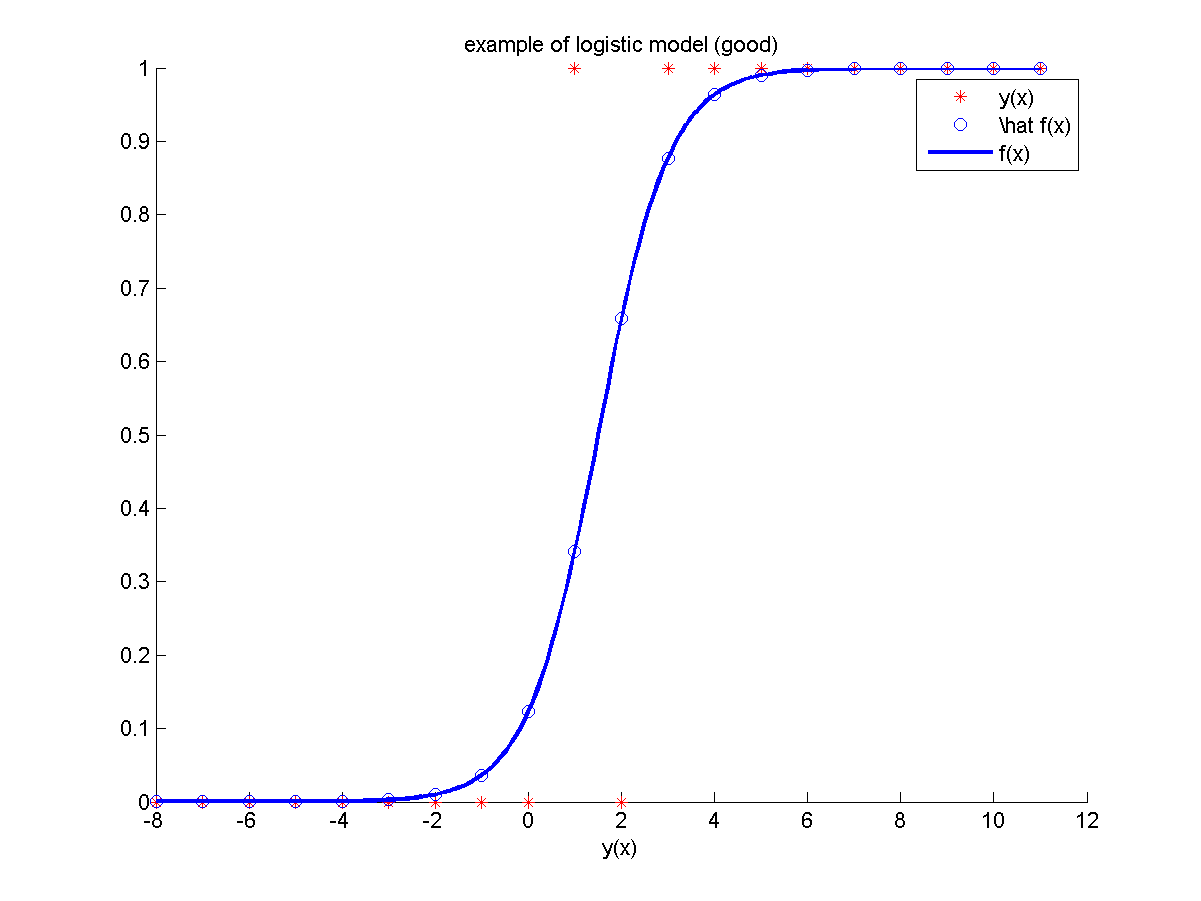

Модель №4

Неизвестная зависимость:

.

где

— индикаторная функция множества

.

Для построения модели использовалось объектов из равномерной сетки.

Значение в одной из обучающих точек сильно зашумлено.

В качестве признаков использовались константа,

.

Отчет, построенный программой:

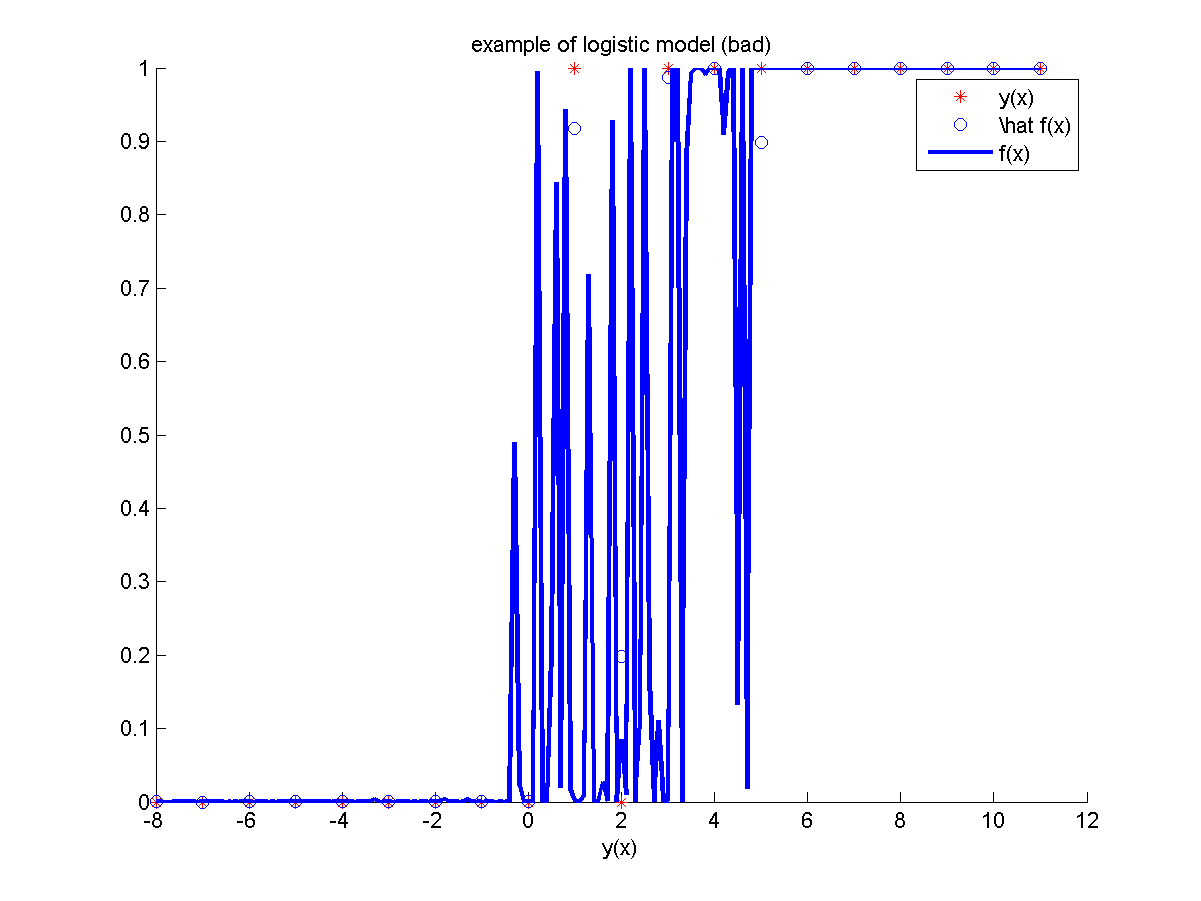

Модель №5

Неизвестная зависимость:

.

где

— индикаторная функция множества

.

Для построения модели использовалось объектов из равномерной сетки.

Значение в одной из обучающих точек сильно зашумлено.

В качестве признаков использовались константа,

и шумовой признак (порожден стандартным нормальным распределением).

Отчет, построенный программой:

Исходный код и полный текст работы

Функция, строящая отчет, и примеры.

Смотри также

Литература

- Bishop, C. Pattern Recognition And Machine Learning. Springer. 2006.

- Кобзарь А. И. Прикладная математическая статистика. — М.: Физматлит, 2006.

- Лагутин М. Б. Наглядная математическая статистика. В двух томах. — М.: П-центр, 2003.

- Hosmer W. D. , Lemeshow S. Applied logistic regression - New York: John Wiley & Sons, 2000.

| | Данная статья была создана в рамках учебного задания.

См. также методические указания по использованию Ресурса MachineLearning.ru в учебном процессе. |