Суммаризация в анализе ДНК-микрочипов

Материал из MachineLearning.

м (терминология) |

м (→fRMA (Frozen Robust Multi-Array Analysis)) |

||

| Строка 34: | Строка 34: | ||

* <tex>n</tex> — номер набора проб <tex> n \in 1, \dots, N </tex>. Также через <tex>n</tex> обозначается номер гена, соответствующего <tex>n</tex>-му набору проб. | * <tex>n</tex> — номер набора проб <tex> n \in 1, \dots, N </tex>. Также через <tex>n</tex> обозначается номер гена, соответствующего <tex>n</tex>-му набору проб. | ||

* <tex>j</tex> — номер пробы <tex> i \in 1, \dots, J_n </tex>. | * <tex>j</tex> — номер пробы <tex> i \in 1, \dots, J_n </tex>. | ||

| - | * <tex>Y_{ijkn}</tex> — предобработанная (с вычтенным фоном и нормализованная) логарифмированная интенсивность пробы <tex>j</tex> из набора проб <tex>n</tex> микрочипа <tex>i</tex> из | + | * <tex>Y_{ijkn}</tex> — предобработанная (с вычтенным фоном и нормализованная) логарифмированная интенсивность пробы <tex>j</tex> из набора проб <tex>n</tex> микрочипа <tex>i</tex> из серии микрочипов <tex>k</tex>. |

* <tex>\theta_{in}</tex> — экспрессия гена <tex>n</tex> на <tex>i</tex>-м микрочипе. | * <tex>\theta_{in}</tex> — экспрессия гена <tex>n</tex> на <tex>i</tex>-м микрочипе. | ||

* <tex>\phi_{jn}</tex> — коэффициент сродства пробы <tex>j</tex> гену <tex>n</tex>. | * <tex>\phi_{jn}</tex> — коэффициент сродства пробы <tex>j</tex> гену <tex>n</tex>. | ||

| - | * <tex>\gamma_{jkn}</tex> — случайная ошибка, вызывающая различия между | + | * <tex>\gamma_{jkn}</tex> — случайная ошибка, вызывающая различия между сериями проб. |

| - | * <tex>\varepsilon_{ijkn}</tex> — случайная ошибка, вызывающая различия между пробами на чипах одной | + | * <tex>\varepsilon_{ijkn}</tex> — случайная ошибка, вызывающая различия между пробами на чипах одной серии. |

В данной модели предполагается, что пробы на разных чипах имеют одинаковую дисперсию случайной ошибки: <tex>\mathbb{D} \varepsilon_{ijkn} = \sigma_{jn}^2</tex>. | В данной модели предполагается, что пробы на разных чипах имеют одинаковую дисперсию случайной ошибки: <tex>\mathbb{D} \varepsilon_{ijkn} = \sigma_{jn}^2</tex>. | ||

Также делается предположение, что <tex>\gamma_{jkn}</tex> — это случайная величина, дисперсия которой не зависит от серии чипов: <tex>\mathbb{D} \gamma_{jkn} = \tau_{jn}^2</tex>. | Также делается предположение, что <tex>\gamma_{jkn}</tex> — это случайная величина, дисперсия которой не зависит от серии чипов: <tex>\mathbb{D} \gamma_{jkn} = \tau_{jn}^2</tex>. | ||

| - | ==== | + | ==== Калибровка модели ==== |

| - | Для | + | Для калибровки необходимы данные с большого числа микрочипов. |

Сначала ко всем микрочипам применяется метод квантильной нормализации, приводящий все данные к одному распределению. | Сначала ко всем микрочипам применяется метод квантильной нормализации, приводящий все данные к одному распределению. | ||

| Строка 64: | Строка 64: | ||

Рассмотрим процесс обработки новых чипов. | Рассмотрим процесс обработки новых чипов. | ||

| - | Сначала делается фоновая поправка всех чипов методом RMA-свертки, затем с помощью квантильной нормализации интенсивности новых чипов приводятся к представительному распределению, полученному на этапе | + | Сначала делается фоновая поправка всех чипов методом RMA-свертки, затем с помощью квантильной нормализации интенсивности новых чипов приводятся к представительному распределению, полученному на этапе калибровки. Последним шагом является суммаризация, которая подробно описана ниже. |

В первую очередь делается поправка интенсивностей проб для учета коэффициента сродства: | В первую очередь делается поправка интенсивностей проб для учета коэффициента сродства: | ||

| Строка 70: | Строка 70: | ||

::<tex> Y_{ijln}^* = Y_{ijln} - \hat \phi_{jn} \approx \theta_{in} + \gamma_{jln} + \varepsilon_{ijln} </tex> | ::<tex> Y_{ijln}^* = Y_{ijln} - \hat \phi_{jn} \approx \theta_{in} + \gamma_{jln} + \varepsilon_{ijln} </tex> | ||

| - | (здесь <tex>l</tex> — это индекс новой | + | (здесь <tex>l</tex> — это индекс новой серии микрочипов). |

Далее из скорректированных интенсивностей нужно получить робастную оценку для <tex>\theta</tex>. | Далее из скорректированных интенсивностей нужно получить робастную оценку для <tex>\theta</tex>. | ||

| Строка 92: | Строка 92: | ||

* <tex> {\mathbf X} = 1_{J_n \times 1} \otimes \mathbf{E}_{I \times I} </tex> — индикаторная матрица (<tex> 1_{m \times n} </tex> — матрица из единиц размера <tex> m \times n </tex>; <tex> {\mathbf E}_{n \times n} </tex> — единичная матрица размера <tex> n \times n </tex>; <tex> \otimes </tex> — [http://ru.wikipedia.org/wiki/Произведение_Кронекера произведение Кронекера]). | * <tex> {\mathbf X} = 1_{J_n \times 1} \otimes \mathbf{E}_{I \times I} </tex> — индикаторная матрица (<tex> 1_{m \times n} </tex> — матрица из единиц размера <tex> m \times n </tex>; <tex> {\mathbf E}_{n \times n} </tex> — единичная матрица размера <tex> n \times n </tex>; <tex> \otimes </tex> — [http://ru.wikipedia.org/wiki/Произведение_Кронекера произведение Кронекера]). | ||

* <tex> {\mathbf \theta} = \left( \theta_{1 n}, \dots, \theta_{I n} \right) </tex> — вектор экспрессий. | * <tex> {\mathbf \theta} = \left( \theta_{1 n}, \dots, \theta_{I n} \right) </tex> — вектор экспрессий. | ||

| - | * <tex> {\mathbf Y_{jn}^*} = \left( Y_{ijn}^* \right)_{i = 1}^{I} \in \mathbb{R}^I </tex> — вектор интенсивностей пробы <tex>j</tex> набора <tex>n</tex> на всех чипах | + | * <tex> {\mathbf Y_{jn}^*} = \left( Y_{ijn}^* \right)_{i = 1}^{I} \in \mathbb{R}^I </tex> — вектор интенсивностей пробы <tex>j</tex> набора <tex>n</tex> на всех чипах серии. |

| - | * <tex> {\mathbf Y_n^*} = \left( {\mathbf Y_{1,n}^*, \dots, Y_{J_n, n}^* } \right)^T \in \mathbb{R}^{I J_n}</tex> — вектор интенсивностей всех проб к гену <tex>n</tex> на всех чипах | + | * <tex> {\mathbf Y_n^*} = \left( {\mathbf Y_{1,n}^*, \dots, Y_{J_n, n}^* } \right)^T \in \mathbb{R}^{I J_n}</tex> — вектор интенсивностей всех проб к гену <tex>n</tex> на всех чипах серии. |

* <tex> {\mathbf \delta} \in \mathbb{R}^{I J_n} </tex> — вектор случайных ошибок, соответствующих интенсивностям из <tex> {\mathbf Y_n^*} </tex>. | * <tex> {\mathbf \delta} \in \mathbb{R}^{I J_n} </tex> — вектор случайных ошибок, соответствующих интенсивностям из <tex> {\mathbf Y_n^*} </tex>. | ||

| Строка 113: | Строка 113: | ||

Решение записывается следующим образом: | Решение записывается следующим образом: | ||

::<tex> {\mathbf \hat \theta} = \left( {\mathbf X^T \Sigma^{-\frac{1}{2}} W \Sigma^{-\frac{1}{2}} X} \right)^{-1} {\mathbf X^T \Sigma^{-\frac{1}{2}} W \Sigma^{-\frac{1}{2}} Y_n^* } </tex>. | ::<tex> {\mathbf \hat \theta} = \left( {\mathbf X^T \Sigma^{-\frac{1}{2}} W \Sigma^{-\frac{1}{2}} X} \right)^{-1} {\mathbf X^T \Sigma^{-\frac{1}{2}} W \Sigma^{-\frac{1}{2}} Y_n^* } </tex>. | ||

| - | |||

== Примечания == | == Примечания == | ||

Версия 10:57, 24 октября 2011

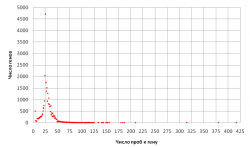

Суммаризация — этап предобработки при анализе ДНК-микрочипов, в ходе которого интенсивности флуоресценции проб, соответствующих одному гену, обобщаются в оценку его экспрессии.

Для обеспечения устойчивости оценки уровня экспрессии к каждому гену на микрочипе имеется несколько проб; их последовательности комплементарны разным участкам последовательности их гена.

Содержание |

Одиночная суммаризация

В данном классе методов оценки экспрессии вычисляются для всех микрочипов независимо друг от друга.

В комплексе методов предобработки MAS 5.0[1] для суммаризации используется взвешенное среднее Тьюки, вычисленное одношаговым методом. Усреднение применяется к логарифмам интенсивностей флуоресценции проб и выполняется независимо для каждого гена на каждом микрочипе.

Множественная суммаризация

К данному классу методов относятся такие, которые для получения оценки экспрессии используют несколько микрочипов.

Интенсивности флуоресценции разных проб к одному и тому же гену могут отличаться на порядки, причём отличия между ними имеют в основном систематический характер. В комплексе методов предобработки RMA[1] делается попытка учесть эти различия в рамках следующей модели:

Здесь — предобработанная (с вычтенным фоном и нормализованная) логирифмированная интенсивность флуоресценции пробы

к гену

на микрочипе

,

— оценка экспрессии гена

на микрочипе

в логарифмической шкале,

— коэффициент аффинитивности

-й пробы

-му гену,

— случайная ошибка с нулевым средним. Для однозначности определения параметров предполагается дополнительно

для каждого гена.

В RMA значения коэффициентов оцениваются при помощи алгоритма median polish[1].

fRMA (Frozen Robust Multi-Array Analysis)

Рассматривается следующая модель уровня экспрессии[1]:

Здесь используются следующие обозначения:

-

— номер серии микрочипов

. Два чипа относятся к одной серии, если эксперименты с ними были проведены в одной лаборатории в одно и то же время.

-

— номер микрочипа

.

-

— номер набора проб

. Также через

обозначается номер гена, соответствующего

-му набору проб.

-

— номер пробы

.

-

— предобработанная (с вычтенным фоном и нормализованная) логарифмированная интенсивность пробы

из набора проб

микрочипа

из серии микрочипов

.

-

— экспрессия гена

на

-м микрочипе.

-

— коэффициент сродства пробы

гену

.

-

— случайная ошибка, вызывающая различия между сериями проб.

-

— случайная ошибка, вызывающая различия между пробами на чипах одной серии.

В данной модели предполагается, что пробы на разных чипах имеют одинаковую дисперсию случайной ошибки: .

Также делается предположение, что

— это случайная величина, дисперсия которой не зависит от серии чипов:

.

Калибровка модели

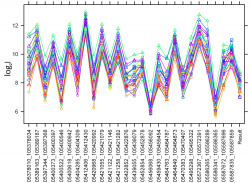

Для калибровки необходимы данные с большого числа микрочипов.

Сначала ко всем микрочипам применяется метод квантильной нормализации, приводящий все данные к одному распределению. В дальнейшем будем называть это распределение «представительным».

Непосредственная настройка модели (1) при наличии выбросов в обучающей выборке крайне сложна, поэтому предлагается перейти к более простой задаче. Рассматривается упрощенная модель

.

По обучающей выборке находятся робастные оценки параметров и

для данной модели.

Затем вычисляются остатки

, с помощью которых оцениваются дисперсии

и

:

;

,

где .

Обработка новых чипов

Рассмотрим процесс обработки новых чипов. Сначала делается фоновая поправка всех чипов методом RMA-свертки, затем с помощью квантильной нормализации интенсивности новых чипов приводятся к представительному распределению, полученному на этапе калибровки. Последним шагом является суммаризация, которая подробно описана ниже.

В первую очередь делается поправка интенсивностей проб для учета коэффициента сродства:

(здесь — это индекс новой серии микрочипов).

Далее из скорректированных интенсивностей нужно получить робастную оценку для .

Это делается разными способами в зависимости от того, из скольких чипов состоит серия.

Один микрочип

В данном случае индексы и

могут быть опущены опущены, так как обрабатывается один микрочип и одна серия.

Логарифмированная концентрация оценивается следующим образом:

,

где — оценка дисперсии скорректированной интенсивности

, а

— веса, соответствующие некоторой M-оценке.

Данная оценка учитывает с низкими весами выбросы (так как им соответствуют маленькие ) и пробы с большой дисперсией шума.

Серия микрочипов

В данном случае индекс может быть опущен, так как обрабатывается одна серия микрочипов. Число чипов в новой серии будем обозначать через

Введем следующие обозначения:

-

— индикаторная матрица (

— матрица из единиц размера

;

— единичная матрица размера

;

— произведение Кронекера).

-

— вектор экспрессий.

-

— вектор интенсивностей пробы

набора

на всех чипах серии.

-

— вектор интенсивностей всех проб к гену

на всех чипах серии.

-

— вектор случайных ошибок, соответствующих интенсивностям из

.

Тогда модель (2) можно записать в матричном виде:

Матрица ковариации вектора случайных ошибок задается следующим образом:

С учетом данного выражения ковариационную матрицу вектора можно записать следующим образом:

Для параметров И

уже получены оценки, поэтому матрицу

можно считать известной.

Значит, с помощью преобразования

можно добиться независимости случайных ошибок.

Тогда робастную оценку для

можно получить из следующей задачи взвешенных наименьших квадратов:

,

где — диагональная матрица весов, соответствующих некоторой M-оценке.

Решение записывается следующим образом:

.