Метод релевантных векторов

Материал из MachineLearning.

(уточнение, викификация, категория) |

м (ссылки) |

||

| Строка 1: | Строка 1: | ||

| - | '''Метод релевантных векторов (RVM, Relevance vector machine)''' — алгоритм [[классификация|классификации]] и восстановления [[регрессия|регрессии]], основанный на [[ | + | '''Метод релевантных векторов (RVM, Relevance vector machine)''' — алгоритм [[классификация|классификации]] и восстановления [[регрессия|регрессии]], основанный на [[Связанный Байесовский вывод|байесовском выводе второго уровня]]. В методе используется [[обобщенная линейная модель]] с введенной [[регуляризация|регуляризацией]], которая, в Байесовкой интерпретации, равносильна введению априорных распределений на вектор параметров. Главной особенностью является то, что все параметры регуляризируются независимо. |

== Решаемая задача == | == Решаемая задача == | ||

| Строка 88: | Строка 88: | ||

[[Категория:Байесовские методы]] | [[Категория:Байесовские методы]] | ||

[[Категория:Линейные классификаторы]] | [[Категория:Линейные классификаторы]] | ||

| - | [[Категория: | + | [[Категория:Регрессионный анализ]] |

Текущая версия

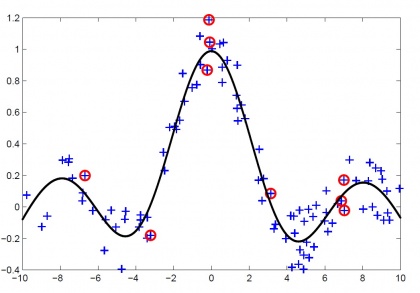

Метод релевантных векторов (RVM, Relevance vector machine) — алгоритм классификации и восстановления регрессии, основанный на байесовском выводе второго уровня. В методе используется обобщенная линейная модель с введенной регуляризацией, которая, в Байесовкой интерпретации, равносильна введению априорных распределений на вектор параметров. Главной особенностью является то, что все параметры регуляризируются независимо.

Содержание |

Решаемая задача

- Имеется выборка

, где вектор признаков

, а целевая переменная

. Требуется для нового объекта

предсказать значение целевой переменной

- Предполагается, что

, где

, а

Подход к решению

- Следуя байесовскому подходу, воспользуемся методом максимума апостериорной плотности:

- Для получения разреженного решения введем в качестве априорного распределения на параметры

нормальное распределение с диагональной матрицей ковариации с различными элементами на диагонали:

- Здесь

. Такое априорное распределение соответствует независимой регуляризации вдоль каждого веса

со своим параметром регуляризации

- Для обучения модели (настройки параметров

) воспользуемся идеей максимизации обоснованности:

Оптимизация обоснованности

- Заметив, что обоснованность является сверткой двух нормальных распределений, можно представить подынтегральную функцию по формуле Тейлора в точке максимума правдоподобия. Обозначив

, после некоторых преобразований получим:

- Обозначив, для удобства,

, и "в лоб" раскрывая предыдущее выражение, получим:

-

,

-

- где

— матрица обобщенных признаков.

- Теперь, приравнивая нулю производные обоснованности по

, получим итерационные формулы для пересчета параметров:

- Здесь

- Параметр

можно интерпретировать как степень, в которой соответствующий вес

определяется данными или регуляризацией. Если

велико, то вес

существенно предопределен априорным распределением,

и

. С другой стороны, для малых значений

значение веса

полностью определяется данными,

.

Принятие решения

- Зная значения

можно вычислить апостериорное распределение целевой переменной:

Обсуждение метода

- На практике процесс обучения обычно требует 20-50 итераций. На каждой итерации вычисляется

(это требует обращения матрицы порядка

), а также пересчитываются значения

(пратктически не требует времени). Как следствие, скорость обучения падает примерно в 20-50 раз по сравнению с линейной регрессией.

- При использовании ядровых функций в качестве обобщенных признаков необходимо проводить скользящий контроль для различных значений параметров ядра. В этом случае время обучения возрастает еще в несколько раз.

- На выходе алгоритма получается разреженное решение, т. е. только небольшое подмножество исходной выборки входит в решающее правило.

- Кроме значения целевой переменной, алгоритм выдает также и дисперсию прогноза.

Псевдокод алгоритма RVM

Вход: Обучающая выборка , матрица обобщенных признаков

Выход: Параметры решающего правила:

- Инициализация:

- для

повторять

- для

повторять

- если

или

, то

- иначе

- если

- Инициализация:

См. также

Литература

- Tipping M. The relevance vector machine // Advances in Neural Information Processing Systems, San Mateo, CA. — Morgan Kaufmann, 2000.

| | Данная статья была создана в рамках учебного задания.

См. также методические указания по использованию Ресурса MachineLearning.ru в учебном процессе. |