Оценка параметров смеси моделей

Материал из MachineLearning.

|

Введение

В случае, когда одной модели для описания данных не хватает, используют смеси моделей. Предполагается, что исходная зависимость выражается формулой:

где --- вероятность принадлежности модели

.

Далее предполагается, что объекты в выборке независимы и плотность совместного распределения преобразуется в произведение плотностей распределения каждого объекта.

Введем функцию правдоподобия как логарифм плотности вероятности данных.

Обозначим через вероятность того, что объект

был порожден компонентой

,

--- вероятность того, что

-объект порожден

-компонентой. Каждый объект был порожден какой-либо моделью, по формуле полной вероятности

Для произвольного объекта вероятность его получения моделью

по формуле условной вероятности равна:

Подставим это равенство в формулу Байеса для

Для определения параметров смеси необходимо решить задачу максимизации правдоподобия , для этого выпишем функцию Лагранжа:

Приравняем производные по и

функции Лагранжа к нулю получим, что:

и оптимизационная задача для нахождения параметров модели имеет вид:

В общем случае задача оптимизации трудна, для её решения используют EM алгоритм, заключающийся в итеративном повторении двух шагов. На

-шаге вычисляются ожидаемые значения вектора скрытых переменных

по текущему приближения параметров моделей

. На

-шаге решается задача максимизации правдоподобия

при начальном приближении параметров моделей и значений

.

-шагу соответствует выражение

-шаг заключается в оптимизации параметров распределений.

Формула на -шаге может упроститься для случая конкретного распределения. Для упрощения дальнейших рассуждений введем обозначения

Оценка параметров смеси линейных моделей

Линейная модель имеет вид:

где --- вектор нормально распределенных ошибок. В данной постановке вектор

является нормальным с математическим ожиданием

, и корреляционной матрицей

.

Шаг алгоритма примет следующий вид:

Первое слагаемое не зависит от , его можно не учитывать. Преобразование второго слагаемого дает

Задача квадратична по , решение находится аналитически

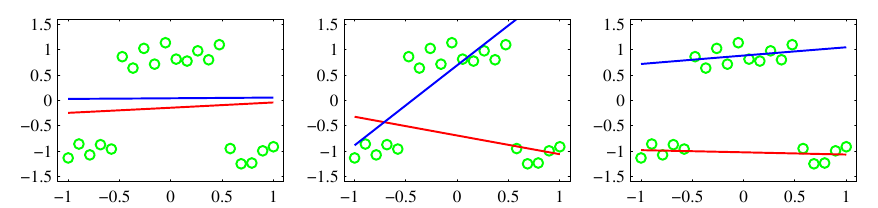

Пример смеси линейных моделей

Оценка параметров смеси обобщенно-линейных моделей

В случае обобщенных линейный моделей функция плотности распределения имеет вид

-шаг алгоритма сводится к максимизации

Последнее слагаемое не зависит от параметров модели , что позволяет упростить функционал

Дальнейшая минимизация зависит от конкретного семейства из обобщенного класса, вида функции .

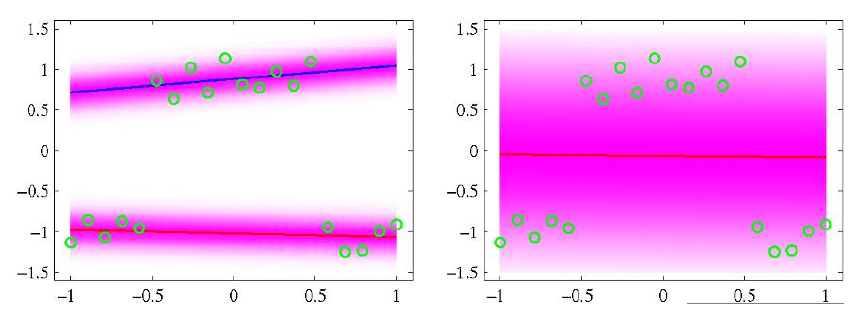

Пример смеси логистических моделей

На изображениях классификация одной и двумя моделями. Розовым показына плотность распределения зависимой переменной.

Оценка параметров смеси экспертов

Понятие смеси экспертов было введено Якобсом (Jacobs) в 1991г. Предполагается, что параметры смеси являются функциями от объекта, т.е.

Компоненты называются функциями селективности, а

экспертами. Функция селективности отвечает за компетентность эксперта в определенной области.

Оказывается (Jordan and Jacobs, 1994), что наличие функции компетенции допускает решение задачи с помощью -алгоритма, причем,

-шаг остается прежним:

-шаг принимает вид:

Последенее уравнение можно решить с помощью метода итеративно перевзвешенных наименьших квадратов ( IRLS).

Литература

- Bishop, C. Pattern Recognition And Machine Learning. Springer. 2006., p 654 - 676

- Nelder, John; Wedderburn, Robert (1972). "Generalized Linear Models". Journal of the Royal Statistical Society. Series A (General) (Blackwell Publishing)

- Воронцов~К.~В. "Курс лекций по машинному обучению". стр. 32 - 37

Смотри также

| | Данная статья была создана в рамках учебного задания.

См. также методические указания по использованию Ресурса MachineLearning.ru в учебном процессе. |