Статистические свойства МНК-оценок коэффициентов регрессии

Материал из MachineLearning.

(Новая: Для того, чтобы '''МНК-оценки коэффициентов [[многомерная линейная регре...) |

|||

| Строка 9: | Строка 9: | ||

::'''2.3.''' <tex>D\varepsilon_i = \sigma^2</tex> (гомоскедастичность); | ::'''2.3.''' <tex>D\varepsilon_i = \sigma^2</tex> (гомоскедастичность); | ||

::'''2.4.''' <tex>E\varepsilon_i\varepsilon_j = 0, \; i\neq j</tex> (некореллированность). | ::'''2.4.''' <tex>E\varepsilon_i\varepsilon_j = 0, \; i\neq j</tex> (некореллированность). | ||

| - | *'''Дополнительное Предположение 3 (ДП3):''' | + | *'''Дополнительное Предположение 3 (ДП3):''' <tex>\; \; \varepsilon \sim N(0,\sigma^2I_n)</tex>, |

| - | + | :т.е вектор регрессионных остатков <tex>\varepsilon</tex> - [[нормальное распределение|нормально распределенный]] [[многомерная случайная величина|случайный вектор]] со [[многомерная случайная величина|средним]] 0 и [[ковариационная матрица|матрицей ковариации]] <tex>\sigma^2I_n</tex> (<tex>I_n</tex> - единичная матрица размера <tex>n\times n</tex>). В этом случаем модель называется ''нормальной линейной регрессионной моделью''. | |

| - | :т.е | + | |

==Свойства МНК-оценок без предположения о нормальности== | ==Свойства МНК-оценок без предположения о нормальности== | ||

| Строка 35: | Строка 34: | ||

* если <tex>c = (x_{i1},\cdots,x_{ik}),</tex> то | * если <tex>c = (x_{i1},\cdots,x_{ik}),</tex> то | ||

::<tex>c^T\hat\theta = \hat y_i</tex> - несмещенная, эффективная оценка <tex>y(x_i)_k.</tex> | ::<tex>c^T\hat\theta = \hat y_i</tex> - несмещенная, эффективная оценка <tex>y(x_i)_k.</tex> | ||

| - | |||

==Свойства МНК-оценок с предположением о нормальности== | ==Свойства МНК-оценок с предположением о нормальности== | ||

| + | |||

| + | Пусть теперь к тому же выполнено ДП3, т.е. <tex>\varepsilon</tex> - многомерная [[нормальное распределение|нормально распределенная]] [[многомерная случайная величина|случайная величина]], или, что то же самое <tex>y_i</tex> имеют совместное нормальное распределение. Тогда к перечисленным выше свойствам добавятся следующие: | ||

| + | |||

| + | * МНК-оценка коэффициентов регрессии <tex>\hat\theta</tex> имеет нормальное распределение: | ||

| + | ::<tex> \hat\theta \sim N(\theta, \sigma^2(X^TX)^{-1});</tex> | ||

| + | |||

| + | * Несмещенная оценка для дисперсии шума <tex>\sigma^2</tex> имеет вид: | ||

| + | ::<tex>\hat\sigma^2 = \frac{RSS}{n-k},</tex> | ||

| + | :где RSS есть [[остаточная сумма квадратов]]; | ||

| + | |||

| + | * Случайная величина <tex>\frac{RSS}{\sigma^2}</tex> распределена по закону [[распределение хи-квадрат|хи-квадрат]] с <tex>n-k</tex> степенями свободы <tex>\chi^2_{n-k}.</tex> | ||

| + | |||

| + | * Оценки <tex>\hat\theta</tex> и <tex>s^2</tex> линейно независимы. Откуда получается, что величина | ||

| + | ::<tex>\frac{\hat\theta-\theta}{\hat\sigma\sqrt{(X^TX)^{-1}}} \sim t_{n-k}</tex> | ||

| + | :имеет [[распределение Стьюдента]] с <tex>n-k</tex> степенями свободы. | ||

Версия 01:19, 29 января 2009

Для того, чтобы МНК-оценки коэффициентов многомерной регрессии обладали полезными статистическими свойствами необходимо выполнение ряда предпосылок относительно оцениваемой регрессионной модели, называемых Основными Положениями.

Основные Положения

- ОП.0

(модель линейна по параметрам);

- ОП.1

- детерминированная

матрица,

(признаки линейно независимы);

- ОП.2 Регрессионные остатки

- 2.1. одинаково распределены;

- 2.2.

(модель несмещенная);

- 2.3.

(гомоскедастичность);

- 2.4.

(некореллированность).

- Дополнительное Предположение 3 (ДП3):

,

- т.е вектор регрессионных остатков

- нормально распределенный случайный вектор со средним 0 и матрицей ковариации

(

- единичная матрица размера

). В этом случаем модель называется нормальной линейной регрессионной моделью.

Свойства МНК-оценок без предположения о нормальности

Теорема Гаусса-Маркова. Пусть выполнены основные положения 0-2. Тогда оценка полученная по методу наименьших квадратов является эффективной в классе линейных (вида

) несмещенных оценок (Best Linear Unbiased Estimator, BLUE).

Исходя из этой теоремы можно выделить несколько основных свойств МНК-оценки

- Линейность:

-

где

-

- Несмещенность:

- Матрица ковариации равна:

- МНК-оценка

эффективна.

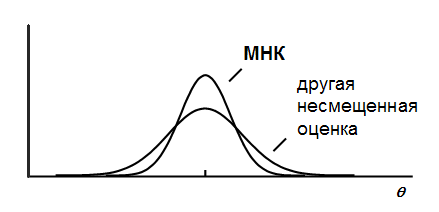

Итак, теорема Гаусса-Маркова утверждает, что любая другая линейная несмещенная оценка будет иметь большую дисперсию, чем МНК-оценка:

Нетрудно показать, что для любого вектора оценка

будет обладать теми же свойствами, что и МНК-оценка

. Поэтому:

- если взять

то получим что

- несмещенная, эффективная оценка

- если

то

- несмещенная, эффективная оценка

Свойства МНК-оценок с предположением о нормальности

Пусть теперь к тому же выполнено ДП3, т.е. - многомерная нормально распределенная случайная величина, или, что то же самое

имеют совместное нормальное распределение. Тогда к перечисленным выше свойствам добавятся следующие:

- МНК-оценка коэффициентов регрессии

имеет нормальное распределение:

- Несмещенная оценка для дисперсии шума

имеет вид:

- где RSS есть остаточная сумма квадратов;

- Случайная величина

распределена по закону хи-квадрат с

степенями свободы

- Оценки

и

линейно независимы. Откуда получается, что величина

- имеет распределение Стьюдента с

степенями свободы.